diff --git a/LICENSE b/LICENSE

new file mode 100644

index 00000000..261eeb9e

--- /dev/null

+++ b/LICENSE

@@ -0,0 +1,201 @@

+ Apache License

+ Version 2.0, January 2004

+ http://www.apache.org/licenses/

+

+ TERMS AND CONDITIONS FOR USE, REPRODUCTION, AND DISTRIBUTION

+

+ 1. Definitions.

+

+ "License" shall mean the terms and conditions for use, reproduction,

+ and distribution as defined by Sections 1 through 9 of this document.

+

+ "Licensor" shall mean the copyright owner or entity authorized by

+ the copyright owner that is granting the License.

+

+ "Legal Entity" shall mean the union of the acting entity and all

+ other entities that control, are controlled by, or are under common

+ control with that entity. For the purposes of this definition,

+ "control" means (i) the power, direct or indirect, to cause the

+ direction or management of such entity, whether by contract or

+ otherwise, or (ii) ownership of fifty percent (50%) or more of the

+ outstanding shares, or (iii) beneficial ownership of such entity.

+

+ "You" (or "Your") shall mean an individual or Legal Entity

+ exercising permissions granted by this License.

+

+ "Source" form shall mean the preferred form for making modifications,

+ including but not limited to software source code, documentation

+ source, and configuration files.

+

+ "Object" form shall mean any form resulting from mechanical

+ transformation or translation of a Source form, including but

+ not limited to compiled object code, generated documentation,

+ and conversions to other media types.

+

+ "Work" shall mean the work of authorship, whether in Source or

+ Object form, made available under the License, as indicated by a

+ copyright notice that is included in or attached to the work

+ (an example is provided in the Appendix below).

+

+ "Derivative Works" shall mean any work, whether in Source or Object

+ form, that is based on (or derived from) the Work and for which the

+ editorial revisions, annotations, elaborations, or other modifications

+ represent, as a whole, an original work of authorship. For the purposes

+ of this License, Derivative Works shall not include works that remain

+ separable from, or merely link (or bind by name) to the interfaces of,

+ the Work and Derivative Works thereof.

+

+ "Contribution" shall mean any work of authorship, including

+ the original version of the Work and any modifications or additions

+ to that Work or Derivative Works thereof, that is intentionally

+ submitted to Licensor for inclusion in the Work by the copyright owner

+ or by an individual or Legal Entity authorized to submit on behalf of

+ the copyright owner. For the purposes of this definition, "submitted"

+ means any form of electronic, verbal, or written communication sent

+ to the Licensor or its representatives, including but not limited to

+ communication on electronic mailing lists, source code control systems,

+ and issue tracking systems that are managed by, or on behalf of, the

+ Licensor for the purpose of discussing and improving the Work, but

+ excluding communication that is conspicuously marked or otherwise

+ designated in writing by the copyright owner as "Not a Contribution."

+

+ "Contributor" shall mean Licensor and any individual or Legal Entity

+ on behalf of whom a Contribution has been received by Licensor and

+ subsequently incorporated within the Work.

+

+ 2. Grant of Copyright License. Subject to the terms and conditions of

+ this License, each Contributor hereby grants to You a perpetual,

+ worldwide, non-exclusive, no-charge, royalty-free, irrevocable

+ copyright license to reproduce, prepare Derivative Works of,

+ publicly display, publicly perform, sublicense, and distribute the

+ Work and such Derivative Works in Source or Object form.

+

+ 3. Grant of Patent License. Subject to the terms and conditions of

+ this License, each Contributor hereby grants to You a perpetual,

+ worldwide, non-exclusive, no-charge, royalty-free, irrevocable

+ (except as stated in this section) patent license to make, have made,

+ use, offer to sell, sell, import, and otherwise transfer the Work,

+ where such license applies only to those patent claims licensable

+ by such Contributor that are necessarily infringed by their

+ Contribution(s) alone or by combination of their Contribution(s)

+ with the Work to which such Contribution(s) was submitted. If You

+ institute patent litigation against any entity (including a

+ cross-claim or counterclaim in a lawsuit) alleging that the Work

+ or a Contribution incorporated within the Work constitutes direct

+ or contributory patent infringement, then any patent licenses

+ granted to You under this License for that Work shall terminate

+ as of the date such litigation is filed.

+

+ 4. Redistribution. You may reproduce and distribute copies of the

+ Work or Derivative Works thereof in any medium, with or without

+ modifications, and in Source or Object form, provided that You

+ meet the following conditions:

+

+ (a) You must give any other recipients of the Work or

+ Derivative Works a copy of this License; and

+

+ (b) You must cause any modified files to carry prominent notices

+ stating that You changed the files; and

+

+ (c) You must retain, in the Source form of any Derivative Works

+ that You distribute, all copyright, patent, trademark, and

+ attribution notices from the Source form of the Work,

+ excluding those notices that do not pertain to any part of

+ the Derivative Works; and

+

+ (d) If the Work includes a "NOTICE" text file as part of its

+ distribution, then any Derivative Works that You distribute must

+ include a readable copy of the attribution notices contained

+ within such NOTICE file, excluding those notices that do not

+ pertain to any part of the Derivative Works, in at least one

+ of the following places: within a NOTICE text file distributed

+ as part of the Derivative Works; within the Source form or

+ documentation, if provided along with the Derivative Works; or,

+ within a display generated by the Derivative Works, if and

+ wherever such third-party notices normally appear. The contents

+ of the NOTICE file are for informational purposes only and

+ do not modify the License. You may add Your own attribution

+ notices within Derivative Works that You distribute, alongside

+ or as an addendum to the NOTICE text from the Work, provided

+ that such additional attribution notices cannot be construed

+ as modifying the License.

+

+ You may add Your own copyright statement to Your modifications and

+ may provide additional or different license terms and conditions

+ for use, reproduction, or distribution of Your modifications, or

+ for any such Derivative Works as a whole, provided Your use,

+ reproduction, and distribution of the Work otherwise complies with

+ the conditions stated in this License.

+

+ 5. Submission of Contributions. Unless You explicitly state otherwise,

+ any Contribution intentionally submitted for inclusion in the Work

+ by You to the Licensor shall be under the terms and conditions of

+ this License, without any additional terms or conditions.

+ Notwithstanding the above, nothing herein shall supersede or modify

+ the terms of any separate license agreement you may have executed

+ with Licensor regarding such Contributions.

+

+ 6. Trademarks. This License does not grant permission to use the trade

+ names, trademarks, service marks, or product names of the Licensor,

+ except as required for reasonable and customary use in describing the

+ origin of the Work and reproducing the content of the NOTICE file.

+

+ 7. Disclaimer of Warranty. Unless required by applicable law or

+ agreed to in writing, Licensor provides the Work (and each

+ Contributor provides its Contributions) on an "AS IS" BASIS,

+ WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or

+ implied, including, without limitation, any warranties or conditions

+ of TITLE, NON-INFRINGEMENT, MERCHANTABILITY, or FITNESS FOR A

+ PARTICULAR PURPOSE. You are solely responsible for determining the

+ appropriateness of using or redistributing the Work and assume any

+ risks associated with Your exercise of permissions under this License.

+

+ 8. Limitation of Liability. In no event and under no legal theory,

+ whether in tort (including negligence), contract, or otherwise,

+ unless required by applicable law (such as deliberate and grossly

+ negligent acts) or agreed to in writing, shall any Contributor be

+ liable to You for damages, including any direct, indirect, special,

+ incidental, or consequential damages of any character arising as a

+ result of this License or out of the use or inability to use the

+ Work (including but not limited to damages for loss of goodwill,

+ work stoppage, computer failure or malfunction, or any and all

+ other commercial damages or losses), even if such Contributor

+ has been advised of the possibility of such damages.

+

+ 9. Accepting Warranty or Additional Liability. While redistributing

+ the Work or Derivative Works thereof, You may choose to offer,

+ and charge a fee for, acceptance of support, warranty, indemnity,

+ or other liability obligations and/or rights consistent with this

+ License. However, in accepting such obligations, You may act only

+ on Your own behalf and on Your sole responsibility, not on behalf

+ of any other Contributor, and only if You agree to indemnify,

+ defend, and hold each Contributor harmless for any liability

+ incurred by, or claims asserted against, such Contributor by reason

+ of your accepting any such warranty or additional liability.

+

+ END OF TERMS AND CONDITIONS

+

+ APPENDIX: How to apply the Apache License to your work.

+

+ To apply the Apache License to your work, attach the following

+ boilerplate notice, with the fields enclosed by brackets "[]"

+ replaced with your own identifying information. (Don't include

+ the brackets!) The text should be enclosed in the appropriate

+ comment syntax for the file format. We also recommend that a

+ file or class name and description of purpose be included on the

+ same "printed page" as the copyright notice for easier

+ identification within third-party archives.

+

+ Copyright [yyyy] [name of copyright owner]

+

+ Licensed under the Apache License, Version 2.0 (the "License");

+ you may not use this file except in compliance with the License.

+ You may obtain a copy of the License at

+

+ http://www.apache.org/licenses/LICENSE-2.0

+

+ Unless required by applicable law or agreed to in writing, software

+ distributed under the License is distributed on an "AS IS" BASIS,

+ WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

+ See the License for the specific language governing permissions and

+ limitations under the License.

diff --git a/Object_detection_image.py b/Object_detection_image.py

index 0068d3bc..577b8c6b 100644

--- a/Object_detection_image.py

+++ b/Object_detection_image.py

@@ -3,9 +3,9 @@

# Author: Evan Juras

# Date: 1/15/18

# Description:

-# This program uses a TensorFlow-trained classifier to perform object detection.

-# It loads the classifier uses it to perform object detection on an image.

-# It draws boxes and scores around the objects of interest in the image.

+# This program uses a TensorFlow-trained neural network to perform object detection.

+# It loads the classifier and uses it to perform object detection on an image.

+# It draws boxes, scores, and labels around the objects of interest in the image.

## Some of the code is copied from Google's example at

## https://github.com/tensorflow/models/blob/master/research/object_detection/object_detection_tutorial.ipynb

@@ -90,7 +90,8 @@

# expand image dimensions to have shape: [1, None, None, 3]

# i.e. a single-column array, where each item in the column has the pixel RGB value

image = cv2.imread(PATH_TO_IMAGE)

-image_expanded = np.expand_dims(image, axis=0)

+image_rgb = cv2.cvtColor(image, cv2.COLOR_BGR2RGB)

+image_expanded = np.expand_dims(image_rgb, axis=0)

# Perform the actual detection by running the model with the image as input

(boxes, scores, classes, num) = sess.run(

@@ -107,7 +108,7 @@

category_index,

use_normalized_coordinates=True,

line_thickness=8,

- min_score_thresh=0.80)

+ min_score_thresh=0.60)

# All the results have been drawn on image. Now display the image.

cv2.imshow('Object detector', image)

diff --git a/Object_detection_video.py b/Object_detection_video.py

index 60800fda..a6ca6d5d 100644

--- a/Object_detection_video.py

+++ b/Object_detection_video.py

@@ -4,9 +4,9 @@

# Date: 1/16/18

# Description:

# This program uses a TensorFlow-trained classifier to perform object detection.

-# It loads the classifier uses it to perform object detection on a video.

-# It draws boxes and scores around the objects of interest in each frame

-# of the video.

+# It loads the classifier and uses it to perform object detection on a video.

+# It draws boxes, scores, and labels around the objects of interest in each

+# frame of the video.

## Some of the code is copied from Google's example at

## https://github.com/tensorflow/models/blob/master/research/object_detection/object_detection_tutorial.ipynb

@@ -95,7 +95,8 @@

# Acquire frame and expand frame dimensions to have shape: [1, None, None, 3]

# i.e. a single-column array, where each item in the column has the pixel RGB value

ret, frame = video.read()

- frame_expanded = np.expand_dims(frame, axis=0)

+ frame_rgb = cv2.cvtColor(frame, cv2.COLOR_BGR2RGB)

+ frame_expanded = np.expand_dims(frame_rgb, axis=0)

# Perform the actual detection by running the model with the image as input

(boxes, scores, classes, num) = sess.run(

@@ -111,7 +112,7 @@

category_index,

use_normalized_coordinates=True,

line_thickness=8,

- min_score_thresh=0.80)

+ min_score_thresh=0.60)

# All the results have been drawn on the frame, so it's time to display it.

cv2.imshow('Object detector', frame)

diff --git a/Object_detection_webcam.py b/Object_detection_webcam.py

index 1f98d26c..ffbe767d 100644

--- a/Object_detection_webcam.py

+++ b/Object_detection_webcam.py

@@ -4,9 +4,9 @@

# Date: 1/20/18

# Description:

# This program uses a TensorFlow-trained classifier to perform object detection.

-# It loads the classifier uses it to perform object detection on a webcam feed.

-# It draws boxes and scores around the objects of interest in each frame from

-# the webcam.

+# It loads the classifier and uses it to perform object detection on a webcam feed.

+# It draws boxes, scores, and labels around the objects of interest in each frame

+# from the webcam.

## Some of the code is copied from Google's example at

## https://github.com/tensorflow/models/blob/master/research/object_detection/object_detection_tutorial.ipynb

@@ -95,7 +95,8 @@

# Acquire frame and expand frame dimensions to have shape: [1, None, None, 3]

# i.e. a single-column array, where each item in the column has the pixel RGB value

ret, frame = video.read()

- frame_expanded = np.expand_dims(frame, axis=0)

+ frame_rgb = cv2.cvtColor(frame, cv2.COLOR_BGR2RGB)

+ frame_expanded = np.expand_dims(frame_rgb, axis=0)

# Perform the actual detection by running the model with the image as input

(boxes, scores, classes, num) = sess.run(

diff --git a/README.md b/README.md

index 17585083..ec98b75c 100644

--- a/README.md

+++ b/README.md

@@ -1,12 +1,15 @@

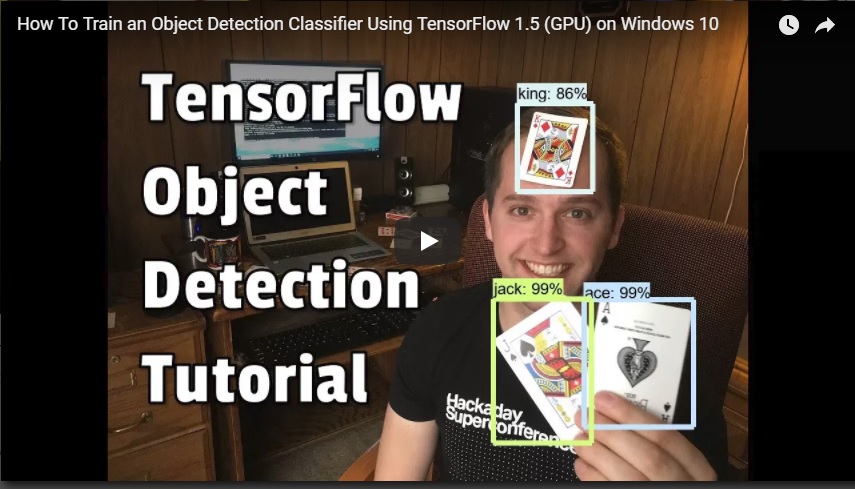

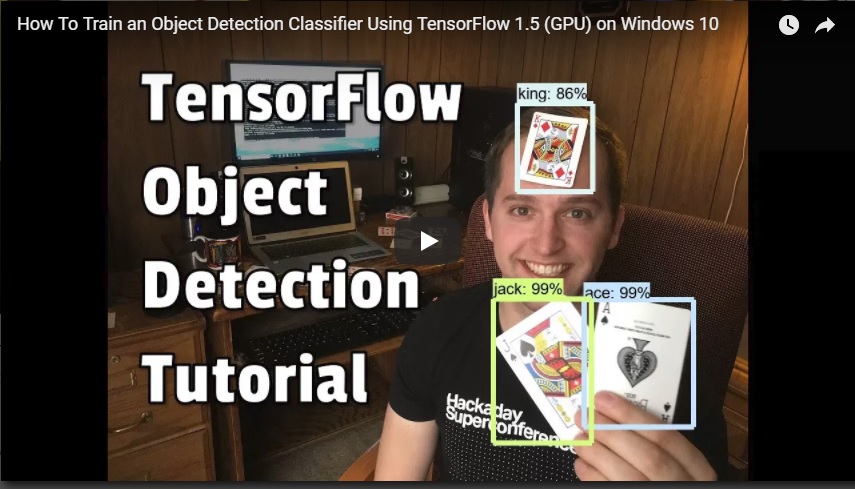

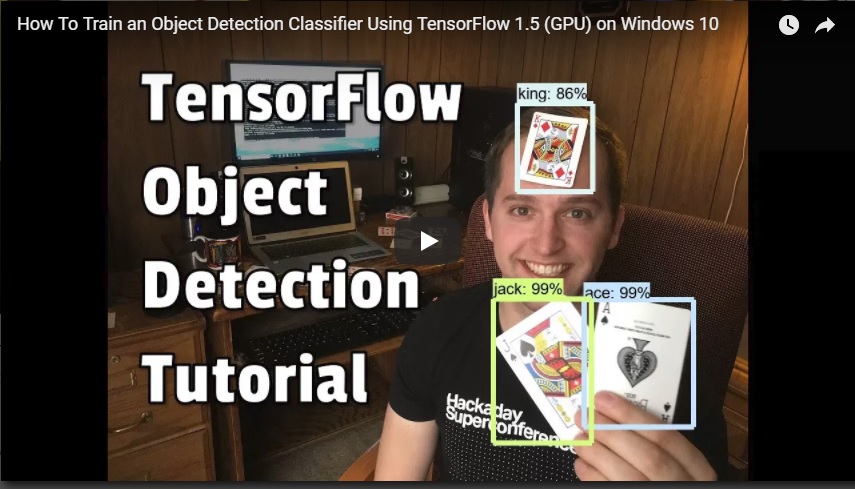

# How To Train an Object Detection Classifier for Multiple Objects Using TensorFlow (GPU) on Windows 10

## Brief Summary

-*Last updated: 9/26/2018 with TensorFlow v1.10*

-

-*Changes: Added note that the train.py file is now located in the /object_detection/legacy folder and must be moved into the main folder before issuing the training command.*

+*Last updated: 6/22/2019 with TensorFlow v1.13.1*

This repository is a tutorial for how to use TensorFlow's Object Detection API to train an object detection classifier for multiple objects on Windows 10, 8, or 7. (It will also work on Linux-based OSes with some minor changes.) It was originally written using TensorFlow version 1.5, but will also work for newer versions of TensorFlow.

+Translated versions of this guide are listed below. If you would like to contribute a translation in another language, please feel free! You can add it as a pull request and I will merge it when I get the chance.

+* [Korean translation](https://github.com/EdjeElectronics/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10/blob/master/translate/README_Korean.md) (thanks @cocopambag!)

+* [Chinese translation](https://github.com/EdjeElectronics/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10/blob/master/translate/README_Chinese.md) (thanks @Marco-Ray!)

+* [Vietnamese translation](https://github.com/EdjeElectronics/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10/blob/master/translate/README_Vietnamese.md) (thanks @winter2897!)

+

I also made a YouTube video that walks through this tutorial. Any discrepancies between the video and this written tutorial are due to updates required for using newer versions of TensorFlow.

**If there are differences between this written tutorial and the video, follow the written tutorial!**

@@ -14,7 +17,7 @@ I also made a YouTube video that walks through this tutorial. Any discrepancies

[](https://www.youtube.com/watch?v=Rgpfk6eYxJA)

This readme describes every step required to get going with your own object detection classifier:

-1. [Installing TensorFlow-GPU](https://github.com/EdjeElectronics/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10#1-install-tensorflow-gpu-15-skip-this-step-if-tensorflow-gpu-15-is-already-installed)

+1. [Installing Anaconda, CUDA, and cuDNN](https://github.com/EdjeElectronics/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10#1-install-anaconda-cuda-and-cudnn)

2. [Setting up the Object Detection directory structure and Anaconda Virtual Environment](https://github.com/EdjeElectronics/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10#2-set-up-tensorflow-directory-and-anaconda-virtual-environment)

3. [Gathering and labeling pictures](https://github.com/EdjeElectronics/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10#3-gather-and-label-pictures)

4. [Generating training data](https://github.com/EdjeElectronics/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10#4-generate-training-data)

@@ -36,20 +39,17 @@ The purpose of this tutorial is to explain how to train your own convolutional n

There are several good tutorials available for how to use TensorFlow’s Object Detection API to train a classifier for a single object. However, these usually assume you are using a Linux operating system. If you’re like me, you might be a little hesitant to install Linux on your high-powered gaming PC that has the sweet graphics card you’re using to train a classifier. The Object Detection API seems to have been developed on a Linux-based OS. To set up TensorFlow to train a model on Windows, there are several workarounds that need to be used in place of commands that would work fine on Linux. Also, this tutorial provides instructions for training a classifier that can detect multiple objects, not just one.

-The tutorial is written for Windows 10, and it will also work for Windows 7 and 8. The general procedure can also be used for Linux operating systems, but file paths and package installation commands will need to change accordingly.

-

-TensorFlow-GPU allows your PC to use the video card to provide extra processing power while training, so it will be used for this tutorial. In my experience, using TensorFlow-GPU instead of regular TensorFlow reduces training time by a factor of about 8 (3 hours to train instead of 24 hours). Regular TensorFlow can also be used for this tutorial, but it will take longer. If you use regular TensorFlow, you do not need to install CUDA and cuDNN in Step 1. I used TensorFlow-GPU v1.5 while writing this tutorial, but it will likely work for future versions of TensorFlow.

+The tutorial is written for Windows 10, and it will also work for Windows 7 and 8. The general procedure can also be used for Linux operating systems, but file paths and package installation commands will need to change accordingly. I used TensorFlow-GPU v1.5 while writing the initial version of this tutorial, but it will likely work for future versions of TensorFlow.

+TensorFlow-GPU allows your PC to use the video card to provide extra processing power while training, so it will be used for this tutorial. In my experience, using TensorFlow-GPU instead of regular TensorFlow reduces training time by a factor of about 8 (3 hours to train instead of 24 hours). The CPU-only version of TensorFlow can also be used for this tutorial, but it will take longer. If you use CPU-only TensorFlow, you do not need to install CUDA and cuDNN in Step 1.

## Steps

-### 1. Install TensorFlow-GPU 1.5 (skip this step if TensorFlow-GPU 1.5 is already installed)

-Install TensorFlow-GPU by following the instructions in [this YouTube Video by Mark Jay](https://www.youtube.com/watch?v=RplXYjxgZbw).

-

-The video is made for TensorFlow-GPU v1.4, but the “pip install --upgrade tensorflow-gpu” command will automatically download version 1.5. Download and install CUDA v9.0 and cuDNN v7.0 (rather than CUDA v8.0 and cuDNN v6.0 as instructed in the video), because they are supported by TensorFlow-GPU v1.5. As future versions of TensorFlow are released, you will likely need to continue updating the CUDA and cuDNN versions to the latest supported version.

+### 1. Install Anaconda, CUDA, and cuDNN

+Anaconda is a software toolkit that creates virtual Python environments so you can install and use Python libraries without worrying about creating version conflicts with existing installations. Anaconda works well on Windows, and enables you to use many Python libraries that normally would only work on a Linux system. It provides a simple method for installing TensorFlow (which we'll do in Step 2d). It also automatically installs the CUDA and cuDNN versions you need for using TensorFlow on a GPU.

-Be sure to install Anaconda with Python 3.6 as instructed in the video, as the Anaconda virtual environment will be used for the rest of this tutorial.

+Download Anaconda for Windows from [their webpage](https://www.anaconda.com/products/individual) (you have to scroll down a ways to get to the download links). Once it's downloaded, execute the installer file and work through the installation steps.

-Visit [TensorFlow's website](https://www.tensorflow.org/install/install_windows) for further installation details, including how to install it on other operating systems (like Linux). The [object detection repository](https://github.com/tensorflow/models/tree/master/research/object_detection) itself also has [installation instructions](https://github.com/tensorflow/models/blob/master/research/object_detection/g3doc/installation.md).

+If you are using a version of TensorFlow older than TF v1.13, make sure you use the CUDA and cuDNN versions that are compatible with the TensorFlow version you are using. [Here](https://www.tensorflow.org/install/source#tested_build_configurations) is a table showing which version of TensorFlow requires which versions of CUDA and cuDNN. Anaconda will automatically install the correct version of CUDA and cuDNN for the version of TensorFlow you are using, so you shouldn't have to worry about this.

### 2. Set up TensorFlow Directory and Anaconda Virtual Environment

The TensorFlow Object Detection API requires using the specific directory structure provided in its GitHub repository. It also requires several additional Python packages, specific additions to the PATH and PYTHONPATH variables, and a few extra setup commands to get everything set up to run or train an object detection model.

@@ -60,10 +60,26 @@ This portion of the tutorial goes over the full set up required. It is fairly me

Create a folder directly in C: and name it “tensorflow1”. This working directory will contain the full TensorFlow object detection framework, as well as your training images, training data, trained classifier, configuration files, and everything else needed for the object detection classifier.

Download the full TensorFlow object detection repository located at https://github.com/tensorflow/models by clicking the “Clone or Download” button and downloading the zip file. Open the downloaded zip file and extract the “models-master” folder directly into the C:\tensorflow1 directory you just created. Rename “models-master” to just “models”.

-(Note, this tutorial was done using this [GitHub commit](https://github.com/tensorflow/models/tree/079d67d9a0b3407e8d074a200780f3835413ef99) of the TensorFlow Object Detection API. If portions of this tutorial do not work, it may be necessary to download and use this exact commit rather than the most up-to-date version.)

-#### 2b. Download the Faster-RCNN-Inception-V2-COCO model from TensorFlow's model zoo

-TensorFlow provides several object detection models (pre-trained classifiers with specific neural network architectures) in its [model zoo](https://github.com/tensorflow/models/blob/master/research/object_detection/g3doc/detection_model_zoo.md). Some models (such as the SSD-MobileNet model) have an architecture that allows for faster detection but with less accuracy, while some models (such as the Faster-RCNN model) give slower detection but with more accuracy. I initially started with the SSD-MobileNet-V1 model, but it didn’t do a very good job identifying the cards in my images. I re-trained my detector on the Faster-RCNN-Inception-V2 model, and the detection worked considerably better, but with a noticeably slower speed.

+**Note: The TensorFlow models repository's code (which contains the object detection API) is continuously updated by the developers. Sometimes they make changes that break functionality with old versions of TensorFlow. It is always best to use the latest version of TensorFlow and download the latest models repository. If you are not using the latest version, clone or download the commit for the version you are using as listed in the table below.**

+

+ If you are using an older version of TensorFlow, here is a table showing which GitHub commit of the repository you should use. I generated this by going to the release branches for the models repository and getting the commit before the last commit for the branch. (They remove the research folder as the last commit before they create the official version release.)

+

+| TensorFlow version | GitHub Models Repository Commit |

+|--------------------|---------------------------------|

+|TF v1.7 |https://github.com/tensorflow/models/tree/adfd5a3aca41638aa9fb297c5095f33d64446d8f |

+|TF v1.8 |https://github.com/tensorflow/models/tree/abd504235f3c2eed891571d62f0a424e54a2dabc |

+|TF v1.9 |https://github.com/tensorflow/models/tree/d530ac540b0103caa194b4824af353f1b073553b |

+|TF v1.10 |https://github.com/tensorflow/models/tree/b07b494e3514553633b132178b4c448f994d59df |

+|TF v1.11 |https://github.com/tensorflow/models/tree/23b5b4227dfa1b23d7c21f0dfaf0951b16671f43 |

+|TF v1.12 |https://github.com/tensorflow/models/tree/r1.12.0 |

+|TF v1.13 |https://github.com/tensorflow/models/tree/r1.13.0 |

+|Latest version |https://github.com/tensorflow/models |

+

+This tutorial was originally done using TensorFlow v1.5 and this [GitHub commit](https://github.com/tensorflow/models/tree/079d67d9a0b3407e8d074a200780f3835413ef99) of the TensorFlow Object Detection API. If portions of this tutorial do not work, it may be necessary to install TensorFlow v1.5 and use this exact commit rather than the most up-to-date version.

+

+#### 2b. Download the Faster-RCNN-Inception-V2-COCO model from TensorFlow's model

+TensorFlow provides several object detection models (pre-trained classifiers with specific neural network architectures) in its [model zoo](https://github.com/tensorflow/models/blob/master/research/object_detection/g3doc/tf1_detection_zoo.md). Some models (such as the SSD-MobileNet model) have an architecture that allows for faster detection but with less accuracy, while some models (such as the Faster-RCNN model) give slower detection but with more accuracy. I initially started with the SSD-MobileNet-V1 model, but it didn’t do a very good job identifying the cards in my images. I re-trained my detector on the Faster-RCNN-Inception-V2 model, and the detection worked considerably better, but with a noticeably slower speed.

@@ -103,20 +119,28 @@ In the command terminal that pops up, create a new virtual environment called

```

C:\> conda create -n tensorflow1 pip python=3.5

```

-Then, activate the environment by issuing:

+Then, activate the environment and update pip by issuing:

```

C:\> activate tensorflow1

+

+(tensorflow1) C:\>python -m pip install --upgrade pip

```

Install tensorflow-gpu in this environment by issuing:

```

(tensorflow1) C:\> pip install --ignore-installed --upgrade tensorflow-gpu

```

+

+Since we're using Anaconda, installing tensorflow-gpu will also automatically download and install the correct versions of CUDA and cuDNN.

+

+(Note: You can also use the CPU-only version of TensorFow, but it will run much slower. If you want to use the CPU-only version, just use "tensorflow" instead of "tensorflow-gpu" in the previous command.)

+

Install the other necessary packages by issuing the following commands:

```

(tensorflow1) C:\> conda install -c anaconda protobuf

(tensorflow1) C:\> pip install pillow

(tensorflow1) C:\> pip install lxml

(tensorflow1) C:\> pip install Cython

+(tensorflow1) C:\> pip install contextlib2

(tensorflow1) C:\> pip install jupyter

(tensorflow1) C:\> pip install matplotlib

(tensorflow1) C:\> pip install pandas

@@ -129,14 +153,19 @@ A PYTHONPATH variable must be created that points to the \models, \models\resear

```

(tensorflow1) C:\> set PYTHONPATH=C:\tensorflow1\models;C:\tensorflow1\models\research;C:\tensorflow1\models\research\slim

```

-(Note: Every time the "tensorflow1" virtual environment is exited, the PYTHONPATH variable is reset and needs to be set up again.)

+(Note: Every time the "tensorflow1" virtual environment is exited, the PYTHONPATH variable is reset and needs to be set up again. You can use "echo %PYTHONPATH% to see if it has been set or not.)

#### 2f. Compile Protobufs and run setup.py

Next, compile the Protobuf files, which are used by TensorFlow to configure model and training parameters. Unfortunately, the short protoc compilation command posted on TensorFlow’s Object Detection API [installation page](https://github.com/tensorflow/models/blob/master/research/object_detection/g3doc/installation.md) does not work on Windows. Every .proto file in the \object_detection\protos directory must be called out individually by the command.

-In the Anaconda Command Prompt, change directories to the \models\research directory and copy and paste the following command into the command line and press Enter:

+In the Anaconda Command Prompt, change directories to the \models\research directory:

+```

+(tensorflow1) C:\> cd C:\tensorflow1\models\research

+```

+

+Then copy and paste the following command into the command line and press Enter:

```

-protoc --python_out=. .\object_detection\protos\anchor_generator.proto .\object_detection\protos\argmax_matcher.proto .\object_detection\protos\bipartite_matcher.proto .\object_detection\protos\box_coder.proto .\object_detection\protos\box_predictor.proto .\object_detection\protos\eval.proto .\object_detection\protos\faster_rcnn.proto .\object_detection\protos\faster_rcnn_box_coder.proto .\object_detection\protos\grid_anchor_generator.proto .\object_detection\protos\hyperparams.proto .\object_detection\protos\image_resizer.proto .\object_detection\protos\input_reader.proto .\object_detection\protos\losses.proto .\object_detection\protos\matcher.proto .\object_detection\protos\mean_stddev_box_coder.proto .\object_detection\protos\model.proto .\object_detection\protos\optimizer.proto .\object_detection\protos\pipeline.proto .\object_detection\protos\post_processing.proto .\object_detection\protos\preprocessor.proto .\object_detection\protos\region_similarity_calculator.proto .\object_detection\protos\square_box_coder.proto .\object_detection\protos\ssd.proto .\object_detection\protos\ssd_anchor_generator.proto .\object_detection\protos\string_int_label_map.proto .\object_detection\protos\train.proto .\object_detection\protos\keypoint_box_coder.proto .\object_detection\protos\multiscale_anchor_generator.proto .\object_detection\protos\graph_rewriter.proto

+protoc --python_out=. .\object_detection\protos\anchor_generator.proto .\object_detection\protos\argmax_matcher.proto .\object_detection\protos\bipartite_matcher.proto .\object_detection\protos\box_coder.proto .\object_detection\protos\box_predictor.proto .\object_detection\protos\eval.proto .\object_detection\protos\faster_rcnn.proto .\object_detection\protos\faster_rcnn_box_coder.proto .\object_detection\protos\grid_anchor_generator.proto .\object_detection\protos\hyperparams.proto .\object_detection\protos\image_resizer.proto .\object_detection\protos\input_reader.proto .\object_detection\protos\losses.proto .\object_detection\protos\matcher.proto .\object_detection\protos\mean_stddev_box_coder.proto .\object_detection\protos\model.proto .\object_detection\protos\optimizer.proto .\object_detection\protos\pipeline.proto .\object_detection\protos\post_processing.proto .\object_detection\protos\preprocessor.proto .\object_detection\protos\region_similarity_calculator.proto .\object_detection\protos\square_box_coder.proto .\object_detection\protos\ssd.proto .\object_detection\protos\ssd_anchor_generator.proto .\object_detection\protos\string_int_label_map.proto .\object_detection\protos\train.proto .\object_detection\protos\keypoint_box_coder.proto .\object_detection\protos\multiscale_anchor_generator.proto .\object_detection\protos\graph_rewriter.proto .\object_detection\protos\calibration.proto .\object_detection\protos\flexible_grid_anchor_generator.proto

```

This creates a name_pb2.py file from every name.proto file in the \object_detection\protos folder.

@@ -159,6 +188,8 @@ This opens the script in your default web browser and allows you to step through

Once you have stepped all the way through the script, you should see two labeled images at the bottom section the page. If you see this, then everything is working properly! If not, the bottom section will report any errors encountered. See the [Appendix](https://github.com/EdjeElectronics/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10#appendix-common-errors) for a list of errors I encountered while setting this up.

+**Note: If you run the full Jupyter Notebook without getting any errors, but the labeled pictures still don't appear, try this: go in to object_detection/utils/visualization_utils.py and comment out the import statements around lines 29 and 30 that include matplotlib. Then, try re-running the Jupyter notebook.**

+

@@ -103,20 +119,28 @@ In the command terminal that pops up, create a new virtual environment called

```

C:\> conda create -n tensorflow1 pip python=3.5

```

-Then, activate the environment by issuing:

+Then, activate the environment and update pip by issuing:

```

C:\> activate tensorflow1

+

+(tensorflow1) C:\>python -m pip install --upgrade pip

```

Install tensorflow-gpu in this environment by issuing:

```

(tensorflow1) C:\> pip install --ignore-installed --upgrade tensorflow-gpu

```

+

+Since we're using Anaconda, installing tensorflow-gpu will also automatically download and install the correct versions of CUDA and cuDNN.

+

+(Note: You can also use the CPU-only version of TensorFow, but it will run much slower. If you want to use the CPU-only version, just use "tensorflow" instead of "tensorflow-gpu" in the previous command.)

+

Install the other necessary packages by issuing the following commands:

```

(tensorflow1) C:\> conda install -c anaconda protobuf

(tensorflow1) C:\> pip install pillow

(tensorflow1) C:\> pip install lxml

(tensorflow1) C:\> pip install Cython

+(tensorflow1) C:\> pip install contextlib2

(tensorflow1) C:\> pip install jupyter

(tensorflow1) C:\> pip install matplotlib

(tensorflow1) C:\> pip install pandas

@@ -129,14 +153,19 @@ A PYTHONPATH variable must be created that points to the \models, \models\resear

```

(tensorflow1) C:\> set PYTHONPATH=C:\tensorflow1\models;C:\tensorflow1\models\research;C:\tensorflow1\models\research\slim

```

-(Note: Every time the "tensorflow1" virtual environment is exited, the PYTHONPATH variable is reset and needs to be set up again.)

+(Note: Every time the "tensorflow1" virtual environment is exited, the PYTHONPATH variable is reset and needs to be set up again. You can use "echo %PYTHONPATH% to see if it has been set or not.)

#### 2f. Compile Protobufs and run setup.py

Next, compile the Protobuf files, which are used by TensorFlow to configure model and training parameters. Unfortunately, the short protoc compilation command posted on TensorFlow’s Object Detection API [installation page](https://github.com/tensorflow/models/blob/master/research/object_detection/g3doc/installation.md) does not work on Windows. Every .proto file in the \object_detection\protos directory must be called out individually by the command.

-In the Anaconda Command Prompt, change directories to the \models\research directory and copy and paste the following command into the command line and press Enter:

+In the Anaconda Command Prompt, change directories to the \models\research directory:

+```

+(tensorflow1) C:\> cd C:\tensorflow1\models\research

+```

+

+Then copy and paste the following command into the command line and press Enter:

```

-protoc --python_out=. .\object_detection\protos\anchor_generator.proto .\object_detection\protos\argmax_matcher.proto .\object_detection\protos\bipartite_matcher.proto .\object_detection\protos\box_coder.proto .\object_detection\protos\box_predictor.proto .\object_detection\protos\eval.proto .\object_detection\protos\faster_rcnn.proto .\object_detection\protos\faster_rcnn_box_coder.proto .\object_detection\protos\grid_anchor_generator.proto .\object_detection\protos\hyperparams.proto .\object_detection\protos\image_resizer.proto .\object_detection\protos\input_reader.proto .\object_detection\protos\losses.proto .\object_detection\protos\matcher.proto .\object_detection\protos\mean_stddev_box_coder.proto .\object_detection\protos\model.proto .\object_detection\protos\optimizer.proto .\object_detection\protos\pipeline.proto .\object_detection\protos\post_processing.proto .\object_detection\protos\preprocessor.proto .\object_detection\protos\region_similarity_calculator.proto .\object_detection\protos\square_box_coder.proto .\object_detection\protos\ssd.proto .\object_detection\protos\ssd_anchor_generator.proto .\object_detection\protos\string_int_label_map.proto .\object_detection\protos\train.proto .\object_detection\protos\keypoint_box_coder.proto .\object_detection\protos\multiscale_anchor_generator.proto .\object_detection\protos\graph_rewriter.proto

+protoc --python_out=. .\object_detection\protos\anchor_generator.proto .\object_detection\protos\argmax_matcher.proto .\object_detection\protos\bipartite_matcher.proto .\object_detection\protos\box_coder.proto .\object_detection\protos\box_predictor.proto .\object_detection\protos\eval.proto .\object_detection\protos\faster_rcnn.proto .\object_detection\protos\faster_rcnn_box_coder.proto .\object_detection\protos\grid_anchor_generator.proto .\object_detection\protos\hyperparams.proto .\object_detection\protos\image_resizer.proto .\object_detection\protos\input_reader.proto .\object_detection\protos\losses.proto .\object_detection\protos\matcher.proto .\object_detection\protos\mean_stddev_box_coder.proto .\object_detection\protos\model.proto .\object_detection\protos\optimizer.proto .\object_detection\protos\pipeline.proto .\object_detection\protos\post_processing.proto .\object_detection\protos\preprocessor.proto .\object_detection\protos\region_similarity_calculator.proto .\object_detection\protos\square_box_coder.proto .\object_detection\protos\ssd.proto .\object_detection\protos\ssd_anchor_generator.proto .\object_detection\protos\string_int_label_map.proto .\object_detection\protos\train.proto .\object_detection\protos\keypoint_box_coder.proto .\object_detection\protos\multiscale_anchor_generator.proto .\object_detection\protos\graph_rewriter.proto .\object_detection\protos\calibration.proto .\object_detection\protos\flexible_grid_anchor_generator.proto

```

This creates a name_pb2.py file from every name.proto file in the \object_detection\protos folder.

@@ -159,6 +188,8 @@ This opens the script in your default web browser and allows you to step through

Once you have stepped all the way through the script, you should see two labeled images at the bottom section the page. If you see this, then everything is working properly! If not, the bottom section will report any errors encountered. See the [Appendix](https://github.com/EdjeElectronics/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10#appendix-common-errors) for a list of errors I encountered while setting this up.

+**Note: If you run the full Jupyter Notebook without getting any errors, but the labeled pictures still don't appear, try this: go in to object_detection/utils/visualization_utils.py and comment out the import statements around lines 29 and 30 that include matplotlib. Then, try re-running the Jupyter notebook.**

+

@@ -196,12 +227,6 @@ Download and install LabelImg, point it to your \images\train directory, and the

LabelImg saves a .xml file containing the label data for each image. These .xml files will be used to generate TFRecords, which are one of the inputs to the TensorFlow trainer. Once you have labeled and saved each image, there will be one .xml file for each image in the \test and \train directories.

-Also, you can check if the size of each bounding box is correct by running sizeChecker.py

-

-```

-(tensorflow1) C:\tensorflow1\models\research\object_detection> python sizeChecker.py --move

-```

-

### 4. Generate Training Data

With the images labeled, it’s time to generate the TFRecords that serve as input data to the TensorFlow training model. This tutorial uses the xml_to_csv.py and generate_tfrecord.py scripts from [Dat Tran’s Raccoon Detector dataset](https://github.com/datitran/raccoon_dataset), with some slight modifications to work with our directory structure.

@@ -230,7 +255,7 @@ def class_text_to_int(row_label):

elif row_label == 'ace':

return 6

else:

- return None

+ None

```

With this:

```

@@ -243,7 +268,7 @@ def class_text_to_int(row_label):

elif row_label == 'shoe':

return 3

else:

- return None

+ None

```

Then, generate the TFRecord files by issuing these commands from the \object_detection folder:

```

@@ -314,16 +339,16 @@ Navigate to C:\tensorflow1\models\research\object_detection\samples\configs and

Make the following changes to the faster_rcnn_inception_v2_pets.config file. Note: The paths must be entered with single forward slashes (NOT backslashes), or TensorFlow will give a file path error when trying to train the model! Also, the paths must be in double quotation marks ( " ), not single quotation marks ( ' ).

- Line 9. Change num_classes to the number of different objects you want the classifier to detect. For the above basketball, shirt, and shoe detector, it would be num_classes : 3 .

-- Line 110. Change fine_tune_checkpoint to:

+- Line 106. Change fine_tune_checkpoint to:

- fine_tune_checkpoint : "C:/tensorflow1/models/research/object_detection/faster_rcnn_inception_v2_coco_2018_01_28/model.ckpt"

-- Lines 126 and 128. In the train_input_reader section, change input_path and label_map_path to:

+- Lines 123 and 125. In the train_input_reader section, change input_path and label_map_path to:

- input_path : "C:/tensorflow1/models/research/object_detection/train.record"

- label_map_path: "C:/tensorflow1/models/research/object_detection/training/labelmap.pbtxt"

-- Line 132. Change num_examples to the number of images you have in the \images\test directory.

+- Line 130. Change num_examples to the number of images you have in the \images\test directory.

-- Lines 140 and 142. In the eval_input_reader section, change input_path and label_map_path to:

+- Lines 135 and 137. In the eval_input_reader section, change input_path and label_map_path to:

- input_path : "C:/tensorflow1/models/research/object_detection/test.record"

- label_map_path: "C:/tensorflow1/models/research/object_detection/training/labelmap.pbtxt"

@@ -384,7 +409,7 @@ If you encounter errors, please check out the Appendix: it has a list of errors

## Appendix: Common Errors

It appears that the TensorFlow Object Detection API was developed on a Linux-based operating system, and most of the directions given by the documentation are for a Linux OS. Trying to get a Linux-developed software library to work on Windows can be challenging. There are many little snags that I ran in to while trying to set up tensorflow-gpu to train an object detection classifier on Windows 10. This Appendix is a list of errors I ran in to, and their resolutions.

-#### 1. ModuleNotFoundError: No module named 'deployment'

+#### 1. ModuleNotFoundError: No module named 'deployment' or No module named 'nets'

This error occurs when you try to run object_detection_tutorial.ipynb or train.py and you don’t have the PATH and PYTHONPATH environment variables set up correctly. Exit the virtual environment by closing and re-opening the Anaconda Prompt window. Then, issue “activate tensorflow1” to re-enter the environment, and then issue the commands given in Step 2e.

@@ -435,4 +460,18 @@ rate_index = tf.reduce_max(tf.where(tf.greater_equal(global_step, boundaries),

[0] * num_boundaries))

```

-[Ref: Tensorflow Issue#3705](https://github.com/tensorflow/models/issues/3705#issuecomment-375563179)

\ No newline at end of file

+[Ref: Tensorflow Issue#3705](https://github.com/tensorflow/models/issues/3705#issuecomment-375563179)

+

+#### 6. ImportError: DLL load failed: The specified procedure could not be found. (or other DLL-related errors)

+This error occurs because the CUDA and cuDNN versions you have installed are not compatible with the version of TensorFlow you are using. The easiest way to resolve this error is to use Anaconda's cudatoolkit package rather than manually installing CUDA and cuDNN. If you ran into these errors, try creating a new Anaconda virtual environment:

+```

+conda create -n tensorflow2 pip python=3.5

+```

+Then, once inside the environment, install TensorFlow using CONDA rather than PIP:

+```

+conda install tensorflow-gpu

+```

+Then restart this guide from Step 2 (but you can skip the part where you install TensorFlow in Step 2d).

+

+#### 7. In Step 2g, the Jupyter Notebook runs all the way through with no errors, but no pictures are displayed at the end.

+If you run the full Jupyter Notebook without getting any errors, but the labeled pictures still don't appear, try this: go in to object_detection/utils/visualization_utils.py and comment out the import statements around lines 29 and 30 that include matplotlib. Then, try re-running the Jupyter notebook. (The visualization_utils.py script changes quite a bit, so it might not be exactly line 29 and 30.)

diff --git a/doc/object_detection_directory.jpg b/doc/object_detection_directory.jpg

index b17a2c65..7385476d 100644

Binary files a/doc/object_detection_directory.jpg and b/doc/object_detection_directory.jpg differ

diff --git a/generate_tfrecord.py b/generate_tfrecord.py

index c318ff7b..36c97ed5 100644

--- a/generate_tfrecord.py

+++ b/generate_tfrecord.py

@@ -14,7 +14,12 @@

import os

import io

import pandas as pd

-import tensorflow as tf

+

+from tensorflow.python.framework.versions import VERSION

+if VERSION >= "2.0.0a0":

+ import tensorflow.compat.v1 as tf

+else:

+ import tensorflow as tf

from PIL import Image

from object_detection.utils import dataset_util

diff --git a/resizer.py b/resizer.py

index 108c4b01..3a2383cf 100644

--- a/resizer.py

+++ b/resizer.py

@@ -17,5 +17,5 @@

# If the images are not .JPG images, change the line below to match the image type.

if filename.endswith(".JPG"):

image = cv2.imread(filename)

- resized = cv2.resize(image,None,fx=0.125, fy=0.125, interpolation=cv2.INTER_AREA)

+ resized = cv2.resize(image,None,fx=0.25, fy=0.25, interpolation=cv2.INTER_AREA)

cv2.imwrite(filename,resized)

diff --git a/training/faster_rcnn_inception_v2_pets.config b/training/faster_rcnn_inception_v2_pets.config

index 40095e39..0f7b0f76 100644

--- a/training/faster_rcnn_inception_v2_pets.config

+++ b/training/faster_rcnn_inception_v2_pets.config

@@ -89,7 +89,7 @@ train_config: {

manual_step_learning_rate {

initial_learning_rate: 0.0002

schedule {

- step: 0

+ step: 1

learning_rate: .0002

}

schedule {

diff --git a/translate/README_Chinese.md b/translate/README_Chinese.md

new file mode 100644

index 00000000..ea5a7f6c

--- /dev/null

+++ b/translate/README_Chinese.md

@@ -0,0 +1,452 @@

+# 如何在Windows10上使用TensorFlow(GPU)进行多物体目标识别分类器的训练

+---

+## 简要总结

+---

+这个仓库是一个如何使用TensorFlow的物体识别API在Windows10,8,7上进行物体识别分类器训练的教程。(它同样能在基于Linux的系统,只需要一些微小的改变。)它最初使用TensorFlow的1.5版本,但同样适用于更新版本的TensorFlow。

+

+我同样制作了一个Youtube视频一步一步讲解本教程。视频和本教程之间存在的任何差异是由更新新版本的TensorFlow导致的。

+

+__如果视频和本教程有任何不同,请以本教程为准。__

+

+

+

+这个readme描述了你部署自己的物体识别分类器所要求的每一个步骤:

+1. [安装Anaconda,CUDA和cuDNN](https://github.com/EdjeElectronics/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10#1-install-anaconda-cuda-and-cudnn)

+2. [设置物体识别目录结构和Anaconda虚拟环境](https://github.com/EdjeElectronics/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10#2-set-up-tensorflow-directory-and-anaconda-virtual-environment)

+3. [收集和标注图片](https://github.com/EdjeElectronics/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10#3-gather-and-label-pictures)

+4. [生成训练数据](https://github.com/EdjeElectronics/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10#4-generate-training-data)

+5. [生成一个标注映射并配置训练](https://github.com/EdjeElectronics/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10#5-create-label-map-and-configure-training)

+6. [训练](https://github.com/EdjeElectronics/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10#6-run-the-training)

+7. [导出结论图](https://github.com/EdjeElectronics/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10#7-export-inference-graph)

+8. [测试和使用你的新训练好的物体识别分类器](https://github.com/EdjeElectronics/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10#8-use-your-newly-trained-object-detection-classifier)

+

+[附录:常见错误](https://github.com/EdjeElectronics/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10#appendix-common-errors)

+

+本仓库提供了训练“Pinochle Deck”扑克牌识别器所需要的所有文件,该识别器可以准确识别9,10,jack,queen,king和ace。本教程描述了如何用自己的文件替换这些文件,来训练一个你想要的识别分类器。它同样有Python脚本来测试你的分类器在图像、视频、网络摄像头上的效果。

+

+

+

+## 介绍

+---

+本教程的目的是解释如何从头开始训练你自己的多目标卷积神经网络物体识别分类器。在本教程的最后,会有一个对图片、视频和网络摄像头上识别并绘框的程序。

+

+目前已经有一些很好的教程教你如何使用TensorFlow的物体识别API去训练单目标的分类器。然而,它们通常假设你使用Linux操作系统。如果你和我一样,你会犹豫是否在自己拥有用于训练分类器的美妙显卡的高性能游戏PC上安装Linux。TensorFlow的物体识别API似乎是在Linux系统上发展起来的。为了在Windows上设置TensorFlow以训练模型,需要用几种代替方法来代替在Linux上可以正常使用的命令。此外,本教程提供了训练多目标识别的分类器的指导,而不是单目标。

+

+本教程基于Windows10,但也适用于Windows7和8。本文介绍的过程同样适用于Linux操作系统,但文件路径和包的安装命令需要相应改变。我在写本教程的最初版本时是用了TensorFlow GPU v1.5版本,但它仍适用于未来版本的TensorFlow。

+

+TensorFlow-GPU版能在训练时让你的PC使用显卡来提供额外的处理能力,所以它会在本教程中被使用。在我的经验中,使用TensorFlow-GPU而不是TensorFlow的常规版本,可以缩短大约8倍的训练时间(从24小时缩短至3小时)。CPU-only版本的TensorFlow也适用于本教程,但会训练更长时间。如果你使用CPU-only版本的TensorFlow,在step1中你就无需安装CUDA和cuDNN。

+

+## Steps

+---

+### 1. 安装Anaconda,CUDA和cuDNN

+跟随[这个Mark Jay的Youtube教程](https://www.youtube.com/watch?v=RplXYjxgZbw),它展示了Anaconda,CUDA和cuDNN的安装步骤。你不需要如视频中那样安装TensorFlow,因为我们会在后续的Step2中安装。这个视频是基于TensorFlow-GPU v1.4,所以请下载和安装和TensorFlow对应的最新版本的CUDA和cuDNN,而不是如同视频里指导的CUDA v8.0和cuDNN v6.0。

+

+如果你正在使用旧版本的TensorFlow,请确保你使用的CUDA和cuDNN版本和你使用的TensorFlow版本是兼容的。[这里](https://www.tensorflow.org/install/source#tested_build_configurations)展示了TensorFlow和CUDA、cuDNN的对应关系表。

+

+请确保如同视频中指导的那样安装[Anaconda](https://www.anaconda.com/distribution/#download-section),因为后续步骤中需要使用到Anaconda的虚拟环境。(Note:目前版本的Anaconda使用Python 3.7,TensorFlow不支持此版本。然而在Step 2d中创建Anaconda虚拟环境时我们会使用Python 3.5。)

+

+访问[TensorFlow官网](https://www.tensorflow.org/install)以了解更多安装细节,包括如何在其他操作系统(如Linux)上安装。 [物体识别仓库](https://github.com/tensorflow/models/tree/master/research/object_detection)同样有[安装指导](https://github.com/tensorflow/models/blob/master/research/object_detection/g3doc/installation.md)

+

+### 2. 设置物体识别目录结构和Anaconda虚拟环境

+TensorFlow物体识别API要求使用其提供在Github仓库内的特定的目录结构。它还要求一些额外的Python库,特定的PATH和PYTHONPATH变量的添加,和一些额外的设置命令以使一切运作或训练一个物体识别模型。

+

+教程的本部分覆盖了所需的完整设置步骤。它非常精细,但请务必紧跟本教程,因为错误的设置会导致后续步骤中难以预料的错误。

+

+#### 2a. 从GitHub下载TensorFlow物体识别API库

+在C盘根目录下创建一个文件夹,并命名为"tensorflow1"。这个工作目录会包含整个TensorFlow物体识别框架,也包括你的训练图片,训练数据,训练好了的分类器,配置文件和其他所有物体识别分类器所需的文件。

+

+从[https://github.com/tensorflow/models](https://github.com/tensorflow/models)下载整个TensorFlow物体识别库,点击“Clone and Download”按钮并下载zip文件。打开下载好的zip文件并解压“models-master”文件夹至你刚创建好的C:\tensorflow1目录下。重命名“models-master”为“models”。

+

+__Note:TensorFlow模型库的代码(包含物体识别API)在持续不断地更新。有时他们做的改变会破快旧版本的功能。因此使用最新版本的TensorFlow和下载最新版本的模型库总是最好的选择。如果你并没有使用最新版本,克隆或下载下表中列出的对应版本。__

+

+如果你正使用旧版的TensorFlow,下表展示了你应该使用哪个版本的GitHub仓库。我通过前往模型库的发布分支并获取该分支最新版本之前的版本。(在发布正式版本前,他们在最新非正式版中去除了research文件夹)

+

+|TensorFlow version|GitHub Models Repository Commit|

+|---|---|

+|TF v1.7|https://github.com/tensorflow/models/tree/adfd5a3aca41638aa9fb297c5095f33d64446d8f|

+|TF v1.8|https://github.com/tensorflow/models/tree/abd504235f3c2eed891571d62f0a424e54a2dabc|

+|TF v1.9|https://github.com/tensorflow/models/tree/d530ac540b0103caa194b4824af353f1b073553b|

+|TF v1.10|https://github.com/tensorflow/models/tree/b07b494e3514553633b132178b4c448f994d59df|

+|TF v1.11|https://github.com/tensorflow/models/tree/23b5b4227dfa1b23d7c21f0dfaf0951b16671f43|

+|TF v1.12|https://github.com/tensorflow/models/tree/r1.12.0|

+|TF v1.13|https://github.com/tensorflow/models/tree/r1.13.0|

+|Latest version|https://github.com/tensorflow/models|

+本教程最初基于TensorFlow v1.5和TensorFlow物体识别API的这个[GitHub commit](https://github.com/tensorflow/models/tree/079d67d9a0b3407e8d074a200780f3835413ef99)完成。如果教程本部分失败,你也许需要安装TensorFlow v1.5并使用和我一样的commit而不是最新版本。

+

+#### 2b. 从TensorFlow模型中下载Faster-RCNN-Inception-V2-COCO模型

+TensorFlow在[model zoo](https://github.com/tensorflow/models/blob/master/research/object_detection/g3doc/tf1_detection_zoo.md)里提供了一些物体识别模型(基于特定神经网络架构的预训练分类器)。一些模型(比如SSD-MobileNet模型)有着更快速识别但是更低正确率的架构,而另一些模型(如Faster-RCNN模型)识别更慢但是准确率更高。我最初使用SSD-MobileNet-V1模型,但对我的图片并没能取得很好的识别效果。我用Faster-RCNN-Incep-V2模型重新训练了我的识别器,它的识别效果明显更好,只是速度显著变慢了。

+

+

+

+你可以选择使用哪个模型来训练你的物体识别分类器。如果你计划在低算力的设备上使用物体识别(如手机或树莓派),请使用SSD-MobileNet。如果你将在性能优异的笔记本或台式PC上运行,请使用RCNN模型中的一种。

+

+本教程将使用Faster-RCNN-Inception-V2模型。[在此下载模型](http://download.tensorflow.org/models/object_detection/faster_rcnn_inception_v2_coco_2018_01_28.tar.gz)。用文件解压器如WinZip或7-Zip打开下载的faster_rcnn_inception_v2_coco_2018_01_28.tar.gz文件并解压faster_rcnn_inception_v2_coco_2018_01_28文件夹至C:\tensorflow1\models\research\object_detection文件夹(Note:模型日期和版本可能会在未来改变,但应该仍适用于本教程。)

+

+#### 2c. 从GitHub下载本教程仓库

+下载位于本页面的整个仓库(滚动到顶部并点击克隆或下载)并解压所有内容到C:\tensorflow1\models\research\object_detection directory。(你可以覆写已经存在的“README.md”文件)这会建立一个后续使用所需的特定的目录结构。

+

+至此,你的object_detection文件夹下应该如图所示:

+

+

+

+本仓库包含训练“Pinochle Deck”扑克牌识别器所需的图片,注释数据,csv文件,和TFRecords。你可以使用这些图片和数据来试着制作你自己的扑克牌识别器。它还包含用于产生训练数据的Python脚本。也包含用于测试物体识别分类器在图片、视频和网络摄像头上的效果的脚本。你可以忽略doc文件夹和里面的文件,它们只是保存了readme中的图片。

+

+如果你想要训练自己的“Pinochle Deck”卡片识别器,你可以保留所有文件。你可以根据本教程了解每一个文件是如何产生的,然后开始训练。像Step 4中描述的那样,你仍然会需要产生TFRecord文件(train.record和test.record)。

+

+你也可以从这个[链接](https://www.dropbox.com/s/va9ob6wcucusse1/inference_graph.zip?dl=0)下载我训练好的卡牌识别器的冻结了的结论图,并解压到\object_detection\inference_graph。这个结论图能在架构外独立工作,你可以在设置完所有Step 2a - 2f后通过运行Object_detection_image.py(或video或wecam)脚本来测试它。

+

+如果你想要训练你自己的物体识别器,删除以下文件(不要删除文件夹):

+* \object_detection\images\train和 \object_detection\images\test中的所有文件

+* \object_detection\images中的test_labels.csv和train_labels.csv文件

+* \object_detection\training中所有文件

+* \object_detection\inference_graph中所有文件

+

+现在,你已经准备好从头开始训练你自己的物体识别器了。本教程会假设上述列举的文件全部被删除,并阐述如何生成这些文件用于你自己的训练数据。

+

+#### 2d. 设置新的Anaconda虚拟环境

+接下来,我们将在Anaconda中为tensorflow-gpu设置一个新的虚拟环境。从Windows的开始菜单中,寻找Anaconda Prompt,右击它,选择以管理员身份运行。如果Windows要求你是否允许允许它对你的电脑做出改变,请点击确定。

+

+在弹出的命令终端里,通过下列命令创建一个新的名为“tensorflow1”的虚拟环境:

+```

+C:\> conda create -n tensorflow1 pip python=3.5

+```

+然后激活这个环境并升级pip:

+```

+C:\> activate tensorflow1

+

+(tensorflow1) C:\>python -m pip install --upgrade pip

+```

+在环境下安装tensorflow-gpu

+```

+(tensorflow1) C:\> pip install --ignore-installed --upgrade tensorflow-gpu

+```

+(Note:你也可以使用CPU-only版本,但它会跑的更慢。如果你想使用CPU-only版本,请在之前的命令中使用“tensorflow”而非“tensorflow-gpu”。)

+

+安装其他必需的包:

+```

+(tensorflow1) C:\> conda install -c anaconda protobuf

+(tensorflow1) C:\> pip install pillow

+(tensorflow1) C:\> pip install lxml

+(tensorflow1) C:\> pip install Cython

+(tensorflow1) C:\> pip install contextlib2

+(tensorflow1) C:\> pip install jupyter

+(tensorflow1) C:\> pip install matplotlib

+(tensorflow1) C:\> pip install pandas

+(tensorflow1) C:\> pip install opencv-python

+```

+(Note:tensorflow并不需要“pandas”和“opencv-python”包,但在python脚本中它们被用来生成TFRecords和处理图片、视频以及网络摄像头。)

+

+#### 2e. 配置PYTHONPATH环境变量

+必须创建一个PYTHONPATH变量指向\models,\models\research,和\models\research\slim目录。通过以下命令实现(可以从任意目录下):

+```

+(tensorflow1) C:\> set PYTHONPATH=C:\tensorflow1\models;C:\tensorflow1\models\research;C:\tensorflow1\models\research\slim

+```

+(Note: 每次退出“tensorflow1”虚拟环境后,PYTHONPATH变量会被重置,下次进入环境需要重新设置。你可以使用“echo %PYTHONPATH%”查看它是否被设置。)

+

+#### 2f. 编译静态库并运行setup.py

+

+接下来,编译静态库文件,它被Tensorflow用于配置模型和训练参数。不幸的是,Tensorflow的物体识别API[安装页面](https://github.com/tensorflow/models/blob/master/research/object_detection/g3doc/installation.md)s上便捷的protoc编译命令无法在Windows上使用。 在\object_detection\protos路径下的每一个.proto文件都必须被调用。

+

+在Anaconda Command Promt下,更换路径到\models\research:

+```

+(tensorflow1) C:\> cd C:\tensorflow1\models\research

+```

+然后拷贝并黏贴以下命令然后按回车运行:

+```

+protoc --python_out=. .\object_detection\protos\anchor_generator.proto .\object_detection\protos\argmax_matcher.proto .\object_detection\protos\bipartite_matcher.proto .\object_detection\protos\box_coder.proto .\object_detection\protos\box_predictor.proto .\object_detection\protos\eval.proto .\object_detection\protos\faster_rcnn.proto .\object_detection\protos\faster_rcnn_box_coder.proto .\object_detection\protos\grid_anchor_generator.proto .\object_detection\protos\hyperparams.proto .\object_detection\protos\image_resizer.proto .\object_detection\protos\input_reader.proto .\object_detection\protos\losses.proto .\object_detection\protos\matcher.proto .\object_detection\protos\mean_stddev_box_coder.proto .\object_detection\protos\model.proto .\object_detection\protos\optimizer.proto .\object_detection\protos\pipeline.proto .\object_detection\protos\post_processing.proto .\object_detection\protos\preprocessor.proto .\object_detection\protos\region_similarity_calculator.proto .\object_detection\protos\square_box_coder.proto .\object_detection\protos\ssd.proto .\object_detection\protos\ssd_anchor_generator.proto .\object_detection\protos\string_int_label_map.proto .\object_detection\protos\train.proto .\object_detection\protos\keypoint_box_coder.proto .\object_detection\protos\multiscale_anchor_generator.proto .\object_detection\protos\graph_rewriter.proto .\object_detection\protos\calibration.proto .\object_detection\protos\flexible_grid_anchor_generator.proto

+```

+这会为\object_detection\protos路径下的每一个name.proto文件创建一个name_pb2.py文件。

+

+__(Note:TensorFlow时不时在\protos文件夹下添加新的.proto文件。如果你得到如下错误:ImportError: cannot import name 'something_something_pb2',你可能需要将新的.proto文件添加到protoc命令)__

+

+最终,在C:\tensorflow1\models\research路径下运行如下命令:

+```

+(tensorflow1) C:\tensorflow1\models\research> python setup.py build

+(tensorflow1) C:\tensorflow1\models\research> python setup.py install

+```

+

+#### 2g. 测试TensorFlow设置,以核实安装成功

+TensorFlow物体识别API现在已经能使用预训练模型用于物体识别或训练一个新模型。你可以通过jupyter运行object_detection_tutorial.ipynb脚本测试并检验你的安装成功了。在\object_detection路径下,运行以下命令:

+```

+(tensorflow1) C:\tensorflow1\models\research\object_detection> jupyter notebook object_detection_tutorial.ipynb

+```

+这会在你的默认浏览器中打开脚本,并允许你一次运行一节代码。你可以点击上方工具栏的“Run”按钮依次运行每一节。当该节旁的"In[*]"文本中填充了数字(如"In[1]")时,该节运行完毕。

+

+(Note:脚本中部分代码会从GitHub上下载ssd_mobilenet_v1模型,大约74MB。这意味着它将运行一段时间,请耐心等待。)

+

+一旦你已经运行了所有脚本,你应该在页面上节的底部看到两张标注了的图片。如果你观察到了,那么一切都运行正常!如果不,节的底部将会报错。参考[附录](https://github.com/EdjeElectronics/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10#appendix-common-errors)中列出的我在安装过程遇到的错误。

+

+__Note:如果你运行个整个Jupyter Notebook而没有报错,但仍然未显示标注了的图片,尝试在object_detection/utils/visualization_utils.py里注释掉大约第29和30行对matplotlib的import。然后再次尝试运行Jupyter Notebook。__

+

+

+

+### 3. 收集并标注图片

+现在TensorFlow物体识别API已经一切就绪,我们需要为它提供用于训练新分类器的图片。

+

+#### 3a. 收集图片

+TensorFlow需要一个目标的上百张图片以训练一个优秀的识别分类器。为了训练一个强大的分类器,训练图片中除了所需的目标应该还要有其他随机物体,并需要有丰富的背景和光照条件。有些图片中的目标物体需要被其他事物部分遮挡、重叠或只露出一半。

+

+对于我的Pinochle Card识别分类器,我有六种不同的检测目标(卡片9、10、jack、queen、king和ace,我不准备识别花色,只识别大小。)我用我的iPhone为每一种卡牌拍摄了大约40张照片,其中包含大量其他非目标物体。然后我拍摄了大约100张多卡牌照片。我知道我想要能够识别重叠的卡牌,所以我确保在很多照片中有被重叠的卡牌。

+

+

+

+你可以使用你的手机拍摄物体的照片或者从Google图片中下载。我建议至少有200张以上的图片集。我使用了311张图片来训练我的卡牌识别器。

+

+务必确保所有照片不会太大。它们都需要小于200KB,并且分辨率不应该大于720x1280。图片越大,训练所需时间越长。你可以使用本仓库中的resizer.py脚本来减少图片的尺寸。

+

+当你有了所需的图片,将20%移动到\object_detection\images\test目录下,将剩余80%移动到\object_detection\images\train目录下。确保\test和\train目录下都有足够图片。

+

+#### 3b. 标注图片

+有趣的部分来了!当收集了所有图片后,是时候在每个图片中标注目标物体了。LabelImg是一个标注图片的强大工具,并且它的GitHub网页上游非常清晰的安装和使用教程。

+

+[LabelImg GitHub link](https://github.com/tzutalin/labelImg)

+

+[LabelImg download link](https://www.dropbox.com/s/tq7zfrcwl44vxan/windows_v1.6.0.zip?dl=1)

+

+下载并安装LabelImg,打开后移动到你的\images\train路径,然后在每张照片的每个目标物体上画框。为\images\test路径下的所有图片重复此步骤。这会耗费一些时间!

+

+

+

+LabelImg为每一张图片保存一个包含标注信息的.xml文件。这些.xml文件会用于生成TFRecords,它是TensorFlow训练器的输入之一。一旦你标注并保存完了所有图片,在\test和\train目录下每张图片将会对应一个.xml文件。

+

+### 4. 生成训练数据

+当标注完图片后,是时候生成输入给TensorFlow训练模块的TFRecords了。本教程使用[Dat Tran's Raccoon Detector dataset](https://github.com/datitran/raccoon_dataset)中的xml_to_csv.py和generate_tfrecords.py脚本,稍作调整以适用于我们自己的目录结构。

+

+首先,image.xml数据将会被用于创建包含所有test和train图片信息的.csv文件。在 \object_detection路径下,在Anaconda Command Prompt运行以下命令:

+```

+(tensorflow1) C:\tensorflow1\models\research\object_detection> python xml_to_csv.py

+```

+这会在\object_detection\images文件夹下生成一个train_labels.csv和test_labels.csv文件。

+

+接着,用文本编辑器打开generate_tfrecord.py。用自己的标注映射图替换从31行开始的标注映射图,每一个目标物体被分配一个ID号码。在Step 5b中,相同的号码分配会被用于配置labelmap.pbtxt文件。

+

+比如,假设你要训练一个分类器以识别篮球、衬衫和鞋子。你将替换generate_tfrecord.py中下列代码:

+```

+# TO-DO replace this with label map

+def class_text_to_int(row_label):

+ if row_label == 'nine':

+ return 1

+ elif row_label == 'ten':

+ return 2

+ elif row_label == 'jack':

+ return 3

+ elif row_label == 'queen':

+ return 4

+ elif row_label == 'king':

+ return 5

+ elif row_label == 'ace':

+ return 6

+ else:

+ None

+```

+变成:

+```

+# TO-DO replace this with label map

+def class_text_to_int(row_label):

+ if row_label == 'basketball':

+ return 1

+ elif row_label == 'shirt':

+ return 2

+ elif row_label == 'shoe':

+ return 3

+ else:

+ None

+```

+然后,在\object_detection路径下运行下列命令生成TFRecord文件:

+```

+python generate_tfrecord.py --csv_input=images\train_labels.csv --image_dir=images\train --output_path=train.record

+python generate_tfrecord.py --csv_input=images\test_labels.csv --image_dir=images\test --output_path=test.record

+```

+这会在\object_detection路径下生成train.record和test.record文件。它们将用于训练物体识别分类器。

+

+### 5. 生成标注映射图和配置训练

+开始训练前的最后一步是创建一个标注映射并编辑训练配置文件。

+

+#### 5a. 标注映射图

+标注映射图通过定义一个类名到类ID的映射来告诉训练器每一个物体是什么。在 C:\tensorflow1\models\research\object_detection\training文件夹下使用任意文本编辑器来新建一个文件并保存为labelmap.pbtxt。(确保文件的后缀是.pbtxt而不是.txt!)在文本编辑器中,复制或输入以下格式的标注映射。(以下示例为我的Pinochle Deck卡牌识别器所用的标注映射图。):

+```

+item {

+ id: 1

+ name: 'nine'

+}

+

+item {

+ id: 2

+ name: 'ten'

+}

+

+item {

+ id: 3

+ name: 'jack'

+}

+

+item {

+ id: 4

+ name: 'queen'

+}

+

+item {

+ id: 5

+ name: 'king'

+}

+

+item {

+ id: 6

+ name: 'ace'

+}

+```

+标注映射图中的ID号需要和generate_tfrecord.py中定义的一致。对于Step 4中提到的篮球、衬衫和鞋子的识别器例子,其labelmap.pbtxt文件应如下所示:

+```

+item {

+ id: 1

+ name: 'basketball'

+}

+

+item {

+ id: 2

+ name: 'shirt'

+}

+

+item {

+ id: 3

+ name: 'shoe'

+}

+```

+

+#### 5b. 配置训练

+最后,必须配置物体识别训练管道。它定义了哪些模型和参数将被用于训练。这是开始训练前的最后一步!

+

+导航至C:\tensorflow1\models\research\object_detection\samples\configs并拷贝faster_rcnn_inception_v2_pets.config文件到\object_detection\training路径下。然后用文本编辑器打开文件。需要对其做几处修改,主要修改类别和样本的数目,并添加文件路径到训练数据。

+

+在faster_rcnn_inception_v2_pets.config文件中做如下几处修改。Note:路径必须使用单个正斜杠(/),而不是反斜杠(\\),否则在尝试训练模型时,TensorFlow会给出路径错误。同样,路径必须使用双引号(")而非单引号(')。

+* Line 9. 修改num_classes为你想要识别的物体的类别数目。对于先前的篮球、衬衫和鞋子识别器,num_classes将会是3。

+* Line 106. 修改 fine_tune_checkpoint为:

+ * fine_tune_checkpoint : "C:/tensorflow1/models/research/object_detection/faster_rcnn_inception_v2_coco_2018_01_28/model.ckpt"

+* Lines 123 and 125. 在train_input_reader模块中,修改input_path和label_map_path为:

+ * input_path : "C:/tensorflow1/models/research/object_detection/train.record"

+ * label_map_path: "C:/tensorflow1/models/research/object_detection/training/labelmap.pbtxt"

+* Lines 130. 修改num_examples为你在\images\test路径下有的图片数目。

+* Lines 135和137. 在eval_input_reader模块,修改input_path和label_map_path为:

+ * input_path : "C:/tensorflow1/models/research/object_detection/test.record"

+ * label_map_path: "C:/tensorflow1/models/research/object_detection/training/labelmap.pbtxt"

+

+修改完毕后保存文件。That's it!一切已经配置完毕!

+

+### 6. 开始训练

+__UPDATE 9/26/18:__ 在1.9版本中,TensorFlow移除了“train.py”文件并用“model_main.py”文件替换了它。我目前还没能用model_mian.py成功运行(我得到与pycocotools有关的错误)。幸运的是,train.py文件仍在/object_detection/legacy文件夹下能找到。只要将train.py从/object_detection/legacy文件夹下移动到/object_detection文件夹下然后继续下列步骤。

+

+Here we go!在\object_detection路径下,运行下列命令开始训练:

+```

+python train.py --logtostderr --train_dir=training/ --pipeline_config_path=training/faster_rcnn_inception_v2_pets.config

+```

+如果一切设置正确,TensorFlow将会初始化训练。在正式开始训练前,初始化会占用30秒。当训练开始,看起来将会是这样子:

+

+

+

+每一步训练会报告损失值。它会随着训练过程由高变得越来越低。对与我对Faster-RCNN-Inception-V2 model的训练,损失值由约3.0快速下降到0.8以下。我建议允许你的模型训练直到损失值保持在0.05以下,这大概需要40,000步,或2小时(取决于你的CPU和GPU算力有多强)。Note:如果使用不同的模型,损失值的数值会不同。MobileNet—SSD的损失值起始于大约20,并应该训练至保持在2以下。

+

+你可以通过TensorBoard观察训练过程。打开一个新的Anaconda Prompt窗口,激活tensorflow1环境,修改路径至C:\tensorflow1\models\research\object_detection,并运行以下命令:

+```

+(tensorflow1) C:\tensorflow1\models\research\object_detection>tensorboard --logdir=training

+```

+这将在本地创建一个端口为6006的网页,可在浏览器上浏览。TensorBoard网页提供展示训练如何进行的信息和图表。一个重要的图标是损失图表,它展示分类器随时间变化的全局损失值。

+

+

+

+训练过程每过大约五分钟会周期性保存检查点。你可以在Command Prompt窗口通过Ctrl+C终止训练。我一般等到一个检查点被保存后才终止训练。你可以终止训练并在之后重启它,它会从最后保存的检查点开始继续训练。最高编号的检查点将会用于生成冻结结论图。

+

+### 7. 导出结论图

+现在,训练已经结束了,最后一步是生成冻结结论图(.pb文件)。在\object_detection路径下,运行下列命令,其中"model.ckpt-XXXX"中的"XXXX"需要被替换成training文件夹下最高编号的.ckpt文件:

+```

+python export_inference_graph.py --input_type image_tensor --pipeline_config_path training/faster_rcnn_inception_v2_pets.config --trained_checkpoint_prefix training/model.ckpt-XXXX --output_directory inference_graph

+```

+这会在\object_detection\inference_graph文件夹下生成一个frozen_inference_graph.pb文件。这个.pb文件包含物体识别分类器。

+

+### 8. 使用你新训练的物体识别分类器!

+这个物体识别分类器已经准备就绪!我已经写好了Python脚本以测试它在图片、视频和网络摄像头上的表现。

+

+在运行Python脚本前,你需要在脚本中修改NUM_CLASSES变量为你想检测的种类数目。(对于我的Pinochle卡牌识别器,我想检测六种卡牌,因此NUM_CLASSES = 6。)

+

+为了测试你的物体识别器,将一张单物体或多物体的照片移动到\object_detection文件夹下,并修改Object_detection_image.py中的IMAGE_NAME变量为图片文件名称。另外,你也可以使用物体的视频(使用Object_detection_video.py),或连接一个USB摄像头并对准物体(使用Object_detection_webcam.py)。

+

+为了运行上述任一脚本,在Anaconda Command Prompt(“tensorflow1”环境激活条件下)中输入“idle”并按回车。这将打开IDLE,在此你可以打开任何Python脚本并运行它们。

+

+如果一切运行正确,物体识别器会初始化10秒然后显示一个展示了任何它在图片中检测到的物体的窗口!

+

+

+

+如果你遇到错误,请检查附录:它包含了一系列我设置我的物体识别分类器时遇到的错误。你也可以尝试google一下错误。通常在Stack Exchange或GitHub上的TensorFlow's Issues中有有用的信息。

+

+## 附录:常见错误

+---

+TensorFlow对象检测API似乎是在基于Linux的操作系统上开发的,文档中给出的大多数指导都是针对Linux OS的。试图让Linux开发的软件库在Windows上运行会具有挑战性。在尝试设置tensorflow-gpu以在Windows 10上训练对象检测分类器时,我遇到了很多麻烦。本附录列出了我遇到的错误及其解决方案。

+

+1. ModuleNotFoundError: No module named 'deployment' or No module named 'nets'

+

+这个错误会出现在你尝试运行object_detection_tutorial.ipynb或train.py但你没将PATH和PYTHONPATH环境变量设置正确时。关闭Anaconda Command Prompt窗口退出虚拟环境并重新打开。然后输入“activate tensorflow1”重新激活环境,并输入Step 2e中给出的命令。

+

+你可以使用“echo %PATH%”和“echo %PYTHONPATH%”来确认环境变量是否设置正确。

+

+同样,确保你在\models\research路径下运行下列命令:

+```

+setup.py build

+setup.py install

+```

+

+2. ImportError: cannot import name 'preprocessor_pb2'

+

+ImportError: cannot import name 'string_int_label_map_pb2'

+(或和pb2文件相关的相似错误)

+

+这个错误出现在protobuf文件(在此例中,preprocessor.proto)未被编译。重新运行Step 2f中给出的protoc命令。检查\object_detection\protos文件夹,确保所有name_pb2.py文件都对应有一个name.proto文件。

+

+3. object_detection/protos/.proto: No such file or directory

+这个错误出现在你尝试运行TensorFlow物体识别API安装页面的

+```

+“protoc object_detection/protos/*.proto --python_out=.”

+```

+命令时。抱歉,它无法在Windows上运行!复制和黏贴Step 2f中给出的完整命令。这应该有更优雅的方式来实现它,但我不知道如何实现。

+

+4. Unsuccessful TensorSliceReader constructor: Failed to get "file path" … The filename, directory name, or volume label syntax is incorrect.

+

+这个错误出现在当训练配置文件(faster_rcnn_inception_v2_pets.config或其他)的文件路径没有使用但正斜杠而用了反斜杠时。打开.config文件并确保所有文件路径为如下格式:

+```

+“C:/path/to/model.file”

+```

+

+5. ValueError: Tried to convert 't' to a tensor and failed. Error: Argument must be a dense tensor: range(0, 3) - got shape [3], but wanted [].

+

+这个问题源自models/research/object_detection/utils/learning_schedules.py

+目前它是

+```

+rate_index = tf.reduce_max(tf.where(tf.greater_equal(global_step, boundaries),

+ range(num_boundaries),

+ [0] * num_boundaries))s

+```

+用list()将range()像这样包起来:

+```

+rate_index = tf.reduce_max(tf.where(tf.greater_equal(global_step, boundaries),

+ list(range(num_boundaries)),

+ [0] * num_boundaries))

+```

+[Ref: Tensorflow Issue#3705](https://github.com/tensorflow/models/issues/3705#issuecomment-375563179)

+

+6. ImportError: DLL load failed: The specified procedure could not be found. (or other DLL-related errors)

+

+这个错误出现是因为你安装的CUDA和cuDNN版本和你使用的TensorFlow版本不兼容。最简单的解决这个错误的方式是使用Anaconda的cudatoolkit包而不是手动安装CUDA和cuDNN。如果你得到了这个错误,尝试新建一个Anaconda虚拟环境:

+```

+conda create -n tensorflow2 pip python=3.5

+```

+然后,当进入这个环境后,使用CONDA而非PIP安装TensorFlow:

+```

+conda install tensorflow-gpu

+```

+然后从Step 2重新开始后续步骤(但你可以跳过Step 2d中安装TensorFlow的部分)。

+

+7. 在Step 2g中,Jupyter Notebook运行未出错,但最终没有图片显示

+

+如果你运行整个Jupyter Notebook而未得到任何报错,但标注了的图片还是没有显示,尝试:

+进入object_detection/utils/visualization_utils.py并注释掉大约第29和30行对matplotlib的import。然后再次尝试运行Jupyter Notebook。(visualization_utils.py脚本经常被修改,因此可能并不是在line 29和30。)

+

+## 译者注:

+目前TensorFlow已经移除了v1.5版本,译者使用v1.15版本成功完成本教程的所有步骤,但未能用v2.0以上版本成功实现。

diff --git a/translate/README_Korean.md b/translate/README_Korean.md

new file mode 100644

index 00000000..d63ad062

--- /dev/null

+++ b/translate/README_Korean.md

@@ -0,0 +1,501 @@

+

+# Windows 10(GPU) 에서 TensorFlow를 사용하여 다중 사물 인식 학습을 하는 방법

+

+## 간단한 요약

+*마지막 업데이트: 9/26/2018 TensorFlow v1.10 사용*

+

+*변환된 점: train.py 파일이 현재 /object_detection/legacy 폴더에 있으며 학습 전에는 반드시 메인 폴더로 옮겨야 합니다.*

+

+이 Repository 는 Windows 10, 8 또는 7 에서 TensorFlow의 Object Detection API를 사용하여 많은 물체가 있는 환경에서 사물 인식 분류를 학습하기 위한 것입니다.( 조금만 바꾼다면 Linux기반의 운영체제에서도 돌아갑니다.)

+기본적으로 TensorFlow 1.5 버전에서 작성되었으며, 더 높은 버전에서도 잘 작동 될 것입니다.(아마도?)

+

+이 튜토리얼을 따라 Yotube 비디오를 만들었습니다. 튜토리얼과 비디오 사이의 다른 점은 TensorFlow 버전이 업데이트 되면서 발생한 것이다.

+(잘 보면서 따라 하면 됩니다.)

+

+**비디오랑 메뉴얼이랑 다르면 메뉴얼을 따라서 해주시면 되겠습니다!**

+

+[](https://www.youtube.com/watch?v=Rgpfk6eYxJA)

+

+이 readme는 커스텀 사물 인식 분류를 하기위해서 차례대로 따라 할 수 있게 표시 했습니다.:

+1. [TensorFlow-GPU 설치방법](https://github.com/cocopambag/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10#1-tensorflow-gpu-15--설치하기)

+2. [Anaconda 가상 환경과 사물 인식 경로 설정](https://github.com/cocopambag/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10#2-tensorflow-폴더와-anaconda-가상-환경-설정)

+3. [사진(사물) 수집 및 라벨링](https://github.com/cocopambag/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10#3-사진-수집-및-라벨링)

+4. [학습 데이터 실행방법](https://github.com/cocopambag/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10#4-학습-데이터-생성)

+5. [label map 생성 및 학습 구성](https://github.com/cocopambag/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10#5-label-map-생성-및-학습-준비)

+6. [학습](https://github.com/cocopambag/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10#6-학습-실행)

+7. [학습된 그래프 추출](https://github.com/cocopambag/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10#7-inference-graph-추출하기)

+8. [학습된 사물 인식 그래프를 사용하고 테스트해보기](https://github.com/cocopambag/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10#8-새로-학습된-사물-인식-분류기-사용하기!)

+

+[부록: 에러 발생시](https://github.com/cocopambag/TensorFlow-Object-Detection-API-Tutorial-Train-Multiple-Objects-Windows-10#appendix--공통적인-에러)

+

+이 repository는 9,10,잭,퀸,킹 그리고 에이스를 정확하게 구별할 수 있는 "Pinochle Deck" 카드 분류 학습에 필요한 모든 파일을 제공합니다. 본 튜터리얼은 사용자가 자신의 파일로 학습을 진행하고 싶을때 어떻게 파일들을 정리해야하는지 알려 줍니다. 사진, 비디오 또는 웹캠으로 학습이 잘 됐는지 파이썬 코드로 실행할 수 있습니다.

+

+

+  +

+

+

+## 소개

+이 튜토리얼의 목적은 프로젝트를 시작하기전에 많은 사물에서 자신의 CNN 사물 인식 분류를 학습시키는지에 대해 설명하기 위함이다. 튜터리얼이 끝났을때, 사진,비디오 또는 웹캠으로 특정한 물체를 인식하고 boxing(박스를 그리는 것)을 하는 프로그램을 만들 수 있다.

+