diff --git a/.vscode/settings.json b/.vscode/settings.json

index ac73ba9674..46bc5a7273 100644

--- a/.vscode/settings.json

+++ b/.vscode/settings.json

@@ -10,5 +10,6 @@

"springframework"

],

"Codegeex.RepoIndex": true,

- "files.autoSave": "afterDelay"

+ "files.autoSave": "afterDelay",

+ "codingcopilot.httpProxySettings": "system"

}

\ No newline at end of file

diff --git a/docs/.vuepress/config.js b/docs/.vuepress/config.js

index f97454f809..2b75a96587 100644

--- a/docs/.vuepress/config.js

+++ b/docs/.vuepress/config.js

@@ -751,22 +751,26 @@ module.exports = {

text: 'LangChain4j',

link: '/md/AI/langchain4j/01-intro'

},

- {

- text: 'MCP',

- link: '/md/AI/mcp/mcp-fad-or-fixture'

- },

{

text: '大模型发展',

link: '/md/AI/llm/GPTs'

},

{

text: 'Prompt工程',

- link: '/md/AI/prompt/01-Prompt网站'

+ link: '/md/AI/prompt/prompt-website'

},

{

text: 'AI Agent',

link: '/md/AI/agent/changelog-cursor'

},

+ {

+ text: 'MCP',

+ link: '/md/AI/mcp/mcp-fad-or-fixture'

+ },

+ {

+ text: 'A2A',

+ link: '/md/AI/a2a/a2a-a-new-era-of-agent-interoperability'

+ },

]

},

@@ -797,6 +801,11 @@ module.exports = {

link: '/md/chain/01-以太坊智能合约与高级语言.md'

},

+ {

+ text: '隐私计算',

+ link: '/md/chain/隐私计算技术原理.md'

+ },

+

]

},

@@ -1179,8 +1188,9 @@ module.exports = {

collapsable: false,

sidebarDepth: 0,

children: [

- "MQTT与Kafka在物联网消息与流数据集成实践",

- "07-MQTT发布订阅模式介绍"

+ "mqtt-kafka-iot-message-streaming-integration",

+ "mqtt-publish-subscribe-intro",

+ "avoid-bare-parsefrom-mqtt-protobuf-consumption",

]

}],

@@ -1246,15 +1256,16 @@ module.exports = {

sidebarDepth: 0,

children: [

"java-se-support-roadmap",

- "Java9新特性概述",

+ "Java9-new-features",

"jdk14-new-features-complete-guide",

- "JDK16新特性",

+ "Java16-new-features",

"understanding-java17-new-features-sealed-classes",

- "JDK21新特性",

- "JDK22新特性",

- "JDK23新特性",

+ "Java21-new-features",

+ "Java22-new-features",

+ "Java23-new-features",

"java24-new-features",

"java2024",

+ "java-news-roundup-jun02-2025",

]

},

@@ -1397,7 +1408,7 @@ module.exports = {

"03-Tomcat的生命周期管理",

"04-Tomcat实现热部署、热加载原理解析",

"05-Tomcat如何打破双亲委派机制实现隔离Web应用的?",

- "Tomcat进程占用CPU过高怎么办?",

+ "how-to-solve-high-cpu-usage-in-tomcat-process",

]

}],

@@ -1501,6 +1512,8 @@ module.exports = {

"为什么临时表可以重名?",

"为什么阿里不推荐使用MySQL分区表?",

"一文看懂这篇MySQL的锁机制",

+ "mysql-transaction-isolation-mechanism",

+ "mysql-index-left-most-matching-rule",

]

},

@@ -1515,6 +1528,7 @@ module.exports = {

"MySQL查询优化",

"MySQL深分页调优实战",

"online-sql-deadlock-incident-how-to-prevent-deadlocks",

+ "optimize-slow-queries-massive-row-deletions",

]

},

@@ -1542,7 +1556,7 @@ module.exports = {

"05-流式操作:如何使用 Flux 和 Mono 高效构建响应式数据流?",

]

}],

-

+

"/md/sentinel/": [{

title: "Sentinel基础",

collapsable: false,

@@ -1679,10 +1693,11 @@ module.exports = {

children: [

"00-Kafka专栏大纲",

"01-为何大厂都选择Kafka作为消息队列",

+ "kafka-core-components",

"Kafka门派知多少",

"08-全网最全图解Kafka适用场景",

"09-消息队列的消息大量积压怎么办?",

- "13-KafkaAdminClient",

+ "kafka-operations-tool-exploring-adminclient-principles-and-practices",

"15-基于kafka实现延迟队列",

"kafka-transaction-implementation",

"kafka-versions",

@@ -2153,10 +2168,22 @@ module.exports = {

"lm-studio-transform-mac-into-ai-tool",

"navigating-llm-deployment-tips-tricks-and-techniques",

"only-ai-flow-can-do",

- "chatgpt-canva",

"llm-reasoning-limitations",

"making-an-llm-that-sees-and-reasons",

"lmstudio-local-llm-call",

+ "inference-engine",

+ "cuda",

+ "gpullama3-java-gpu-llm",

+ ]

+ },

+ {

+ title: "ChatGPT",

+ collapsable: false,

+ sidebarDepth: 0,

+ children: [

+ "chatgpt-canva",

+ "memory-faq",

+ "GPT-5",

]

},

{

@@ -2166,6 +2193,7 @@ module.exports = {

children: [

"qwen-QwQ",

"qwen3",

+ "qwen3-coder",

]

},

@@ -2178,6 +2206,16 @@ module.exports = {

]

},

+ {

+ title: "Kimi",

+ collapsable: false,

+ sidebarDepth: 0,

+ children: [

+ "Kimi-K2",

+ "kimi-k2-whats-fuss-whats-like-use",

+ ]

+ },

+

{

title: "Claude",

collapsable: false,

@@ -2187,6 +2225,17 @@ module.exports = {

"计算机使用功能",

"claude-3-7-sonnet",

"claude-4",

+ "claude-4-5-sonnet",

+ ]

+ },

+

+ {

+ title: "Grok",

+ collapsable: false,

+ sidebarDepth: 0,

+ children: [

+ "grok4",

+ "grok-code-fast",

]

},

@@ -2214,6 +2263,7 @@ module.exports = {

"boost-ai-workflow-resilience-with-error-handling",

"introducing-parent-child-retrieval-for-enhanced-knowledge",

"dify-v1-0-building-a-vibrant-plugin-ecosystem",

+ "dify-v1-1-0-filtering-knowledge-retrieval-with-customized-metadata",

"dify-deep-research-workflow-farewell-to-fragmented-search-unlock-ai-driven-insights",

"dify-agent-and-zapier-mcp-unlock-ai-automation",

]

@@ -2327,29 +2377,102 @@ module.exports = {

]

},

{

- title: "辅助编程",

+ title: "cursor",

collapsable: false,

sidebarDepth: 0,

children: [

"changelog-cursor",

+ ]

+ },

+

+ {

+ title: "kiro",

+ collapsable: false,

+ sidebarDepth: 0,

+ children: [

+ "kiro",

+ ]

+ },

+

+ {

+ title: "trae",

+ collapsable: false,

+ sidebarDepth: 0,

+ children: [

+ "trae",

+ "solo",

+ "trae-update",

+ ]

+ },

+

+ {

+ title: "CodeBuddy",

+ collapsable: false,

+ sidebarDepth: 0,

+ children: [

+ "codebuddy",

+ ]

+ },

+

+ {

+ title: "windsurf",

+ collapsable: false,

+ sidebarDepth: 0,

+ children: [

"goodbye-cursor-hello-windsurf",

- "Junie",

- "introducing-codex",

+ "windsurf-update",

+ ]

+ },

+

+ {

+ title: "qoder",

+ collapsable: false,

+ sidebarDepth: 0,

+ children: [

+ "qoder",

+ ]

+ },

+

+ {

+ title: "Cline",

+ collapsable: false,

+ sidebarDepth: 0,

+ children: [

+ "cline",

+ ]

+ },

+

+ {

+ title: "Roo Code",

+ collapsable: false,

+ sidebarDepth: 0,

+ children: [

+ "roocode",

]

},

- ],

- "/md/AI/agent/dify/": [{

- title: "快速上手",

+ {

+ title: "Augment",

collapsable: false,

sidebarDepth: 0,

children: [

- "ai-agents-dont-security-nightmare",

- "improve-quality-gen-ai",

+ "augment",

+ ]

+ },

+ {

+ title: "Dify基础",

+ collapsable: false,

+ sidebarDepth: 0,

+ children: [

+ "what-is-llmops",

+ "configuring-models-in-dify",

+ "Build-App-with-Dify",

+ "integrate-dify-and-aws-services-to-enable-more-flexible-translation-workflows",

+ "llm-knowledge-base-segmentation-data-cleaning",

]

},

{

- title: "案例",

+ title: "Dify案例",

collapsable: false,

sidebarDepth: 0,

children: [

@@ -2359,6 +2482,15 @@ module.exports = {

"introducing-codex",

]

},

+

+ {

+ title: "Perplexity",

+ collapsable: false,

+ sidebarDepth: 0,

+ children: [

+ "perplexity-labs",

+ ]

+ },

],

"/md/AI/mcp/": [{

@@ -2381,6 +2513,16 @@ module.exports = {

},

],

+ "/md/AI/a2a/": [{

+ title: "A2A",

+ collapsable: false,

+ sidebarDepth: 0,

+ children: [

+ "a2a-a-new-era-of-agent-interoperability",

+ ]

+ },

+ ],

+

"/md/AI/spring-ai-alibaba/": [{

title: "Spring AI Alibaba",

collapsable: false,

@@ -2395,8 +2537,8 @@ module.exports = {

collapsable: false,

sidebarDepth: 0,

children: [

- "01-Prompt网站",

- "02-常用Prompt",

+ "prompt-website",

+ "prompt-toollist",

]

}, ,],

@@ -2425,6 +2567,7 @@ module.exports = {

"03-core-of-rag-result-retrieval-and-reordering",

"04-prompt-helping-llm-understand-knowledge",

"2025-future-rag-trends-four-technologies",

+ "why-vector-embeddings-are-here-to-stay",

]

},

{

@@ -2529,6 +2672,7 @@ module.exports = {

sidebarDepth: 0,

children: [

"01-单一职责原则",

+ "open-close-principle",

"rest-api-design-resource-modeling",

]

},

diff --git a/docs/md/AI/a2a/a2a-a-new-era-of-agent-interoperability.md b/docs/md/AI/a2a/a2a-a-new-era-of-agent-interoperability.md

new file mode 100644

index 0000000000..47271d5f00

--- /dev/null

+++ b/docs/md/AI/a2a/a2a-a-new-era-of-agent-interoperability.md

@@ -0,0 +1,288 @@

+# Agent2Agent (A2A) 协议发布

+

+

+

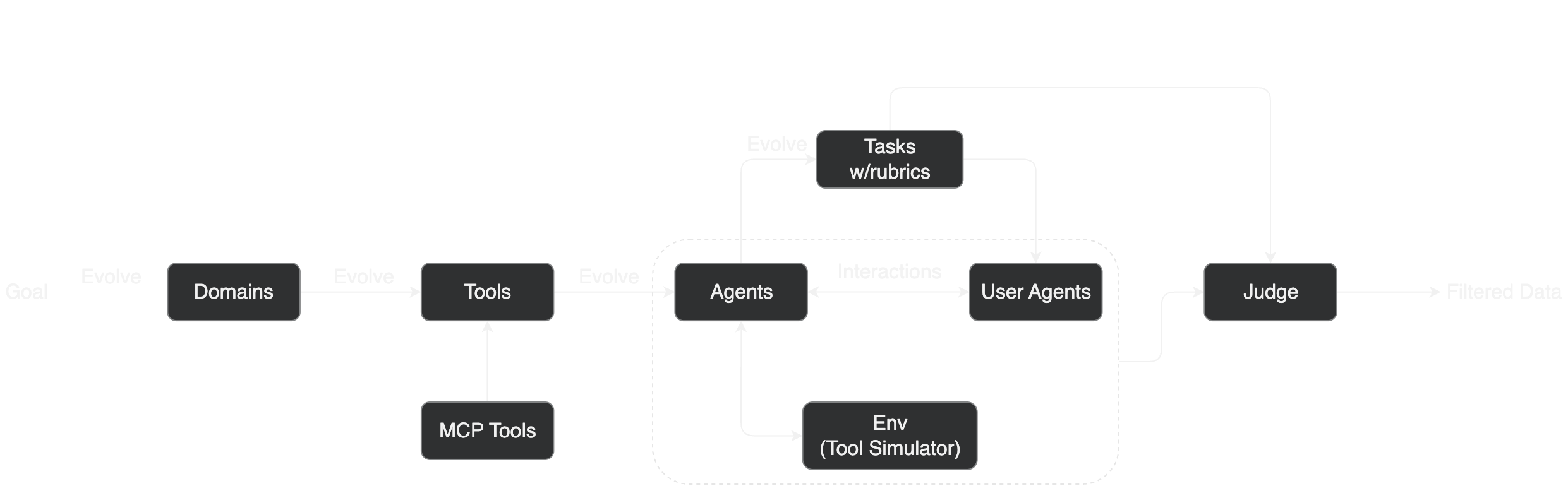

+## 1 智能体互操作性的新时代

+

+通过自主处理大量日常重复性或复杂性任务,AI智能体为提高人们工作效率带来独特机遇。如今,企业正在构建和部署越来越多的自主智能体,以便扩展、自动化和改进工作场所的各种流程,如订购新笔记本电脑、协助客户服务代表和协助供应链规划。

+

+为最大限度发挥智能体 AI 优势,这些智能体须能在横跨孤立数据系统和应用程序的动态、多智能体生态系统中协作。即使智能体由不同供应商构建或在不同的框架中构建,也能实现智能体之间的互操作性,这将提高自主性并成倍提高生产力,同时降低长期成本。

+

+今天,Google发布Agent2Agent (A2A) 全新开放协议,Atlassian、Box、Cohere、Intuit、Langchain、MongoDB、PayPal、Salesforce、SAP、ServiceNow、UKG 和 Workday 等 50 多家技术合作伙伴及埃森哲、BCG、Capgemini、Cognizant、德勤、HCLTech、Infosys、毕马威、麦肯锡、普华永道、TCS 和 Wipro 等领先服务提供商均支持。

+

+凭借 A2A 协议,AI 智能体能在各种企业平台或应用程序之上相互通信、安全交换信息和协调操作。A2A 框架将为客户创造巨大的价值,他们的 AI 智能体将服务于整个企业的各类应用程序资产。

+

+这种协作努力体现人们对未来的共同愿景,即无论底层技术如何,AI 智能体都能无缝协作,以自动化复杂企业工作流程,推动效率与创新达到前所未有的高度。

+

+A2A 是一个开放协议,是对MCP的补充,MCP为智能体提供了有用的工具和上下文。借鉴 Google 在扩展智能体系统方面的内部专业知识,我们设计了 A2A 协议,以应对我们在为客户部署大规模、多智能体系统时遇到的挑战。借助 A2A 协议,开发者可以构建能够与使用该协议构建的任何其他智能体建立连接的智能体,让用户能够灵活地组合来自各种提供商的智能体。至关重要的是,企业可以受益于这种标准化方法,跨不同平台和云环境管理其智能体。我们相信,这种通用的互操作性对于充分发挥协作 AI 智能体的潜力至关重要。

+

+

+

+## 2 A2A设计原则

+

+A2A 是一种开放协议,提供了一种让智能体相互协作的标准方式,无论其底层框架或供应商是什么。与合作伙伴一起设计该协议时,坚持五大关键原则:

+

+- 拥抱智能体能力:A2A聚焦于让智能体以其自然、非结构化的方式进行协作,即使彼此没有共享内存、工具和上下文,也能高效协作。我们将实现真正的多智能体场景,不再将智能体仅仅看作是“工具”

+

+- 依托现有标准构建:该协议是基于 HTTP、SSE、JSON-RPC等当下主流标准构建而成,即其能更轻松与企业当前日常使用的 IT 堆栈进行集成

+

+- 默认安全:A2A旨在支持企业级身份验证和授权,并在发布时与 OpenAPI 的身份验证方案保持对等

+

+- 支持长时间运行的任务:A2A非常灵活,支持各种场景,可出色完成从快速任务到深入研究(在有人类参与时,可能需数小时甚至数天时间才能完成)的所有任务。在整个过程中,A2A 可以向用户提供实时反馈、通知和状态更新

+

+- 模式不受限:智能体世界不仅限于文本,这就是为什么我们将 A2A 设计为支持各种模式,包括音频和视频流

+

+## 3 A2A工作原理

+

+一个说明远程Agent和客户端Agent之间数据流的插图流程图,以产生安全协作、任务和状态管理、用户体验协商及能力发现

+

+

+

+A2A方便了“客户端”智能体与“远程”智能体之间的通信。客户端智能体负责制定和传达任务,而远程智能体负责执行这些任务,力图提供正确的信息或采取正确的行动。这种交互涉及几个关键功能:

+

+- 能力发现:智能体可用 JSON 格式“智能体卡”来宣传其能力,使客户端智能体能识别出能执行任务的最佳智能体,并利用 A2A 与远程智能体进行通信

+

+- 任务管理:客户端智能体与远程智能体之间的通信以完成任务为导向,智能体在其中努力完成最终用户的请求。该“任务”对象由协议定义,且具有生命周期。任务可立即完成,而长时间运行的任务,每个智能体都可进行通信,以便彼此之间保持同步,了解任务完成情况的最新状态。任务的输出被称为“工件”

+

+- 协作:智能体可相互发送信息,交流上下文、回复、工件或用户指令

+

+- 用户体验协商:每条消息都包含“部件”,“部件”是一个完整的内容片段,如生成的图像。每个部件都有指定的内容类型,允许客户端和远程智能体协商所需的正确格式,并明确包括用户界面功能的协商,如 iframe、视频、网页表单等

+

+参阅[规范草案](https://github.com/google/A2A),了解协议工作原理的完整细节。

+

+## 3 真实案例:搜寻候选人

+

+通过 A2A 协作,可大大简化软件工程师招聘过程。在 Agentspace 这样的统一界面中,用户(如招聘经理)可以要求其智能体寻找符合职位列表、地点和技能组合的候选人。然后,智能体与其他专业智能体互动,寻找潜在的候选人。用户收到这些建议后,可指示其智能体安排进一步面试,简化候选人搜寻流程。面试流程结束后,还可让另一个智能体协助背调。这这只是 AI 智能体需要跨系统协作以寻找合格求职者的一个示例。

+

+## 4 智能体互操作性的未来

+

+A2A有望开启智能体互操作性的新时代,推动创新浪潮,构建功能更强大、用途更广泛的智能体系统。我们坚信,该协议将为未来智能体发展奠定基础,促使智能体无缝协作以攻克复杂难题,提升我们生活品质。

+

+致力于与合作伙伴和社区公开合作构建该协议。开源方式发布该协议,并建立明确贡献途径。可在 [A2A 网站](https://google.github.io/A2A)查看[完整版规范草案](https://github.com/google/A2A)、试用代码示例和查看示例场景,并了解贡献方式。

+

+正与合作伙伴合作,计划今年晚些推出可用于生产的协议版本。

+

+## 5 A2A技术合作伙伴反馈

+

+### ask-ai.com

+

+> Ask-AI 很高兴与 Google 合作开发 A2A 协议,共同塑造 AI 互操作性和无缝智能体协作的未来,从而提升其在企业 AI 客户体验领域的领导地位。

+> ——Alon Talmor 博士,首席执行官

+

+### Atlassian

+

+> 凭借 Atlassian 对 Rovo 智能体的投资,像 A2A 这样的标准化协议的开发将帮助智能体成功地发现、协调和推理彼此,从而实现更丰富的授权和大规模协作形式。

+> ——Brendan Haire,Atlassian 的 AI 平台工程副总裁

+

+### Articul8

+

+> 在 Articul8,我们认为 AI 必须协作和互操作,才能真正跨企业扩展。我们很高兴支持 A2A 互操作性协议的开发,该计划与我们提供跨复杂系统和工作流程无缝运行的特定领域 GenAI 功能的使命完美契合。我们正在使 Articul8 的 ModelMesh(“智能体中的智能体”)将 A2A 视为一等公民,从而实现智能智能体之间的安全、无缝通信。

+> —— Arun Subramaniyan,Articul8 创始人兼首席执行官

+

+### Arize AI

+

+> Arize AI很荣幸与 Google 合作,成为 A2A 互操作性协议的产品发布合作伙伴,从而推进跨 AI 智能体的无缝、安全交互,这是 Arize 对开源评估和可观测性框架立场承诺的一部分。

+> ——Jason Lopatecki,Arize AI 联合创始人兼首席执行官

+

+### BCG

+

+> BCG 帮助重新设计以智能为核心的组织。像 A2A 这样开放和可互操作的功能可以加速这一进程,从而实现可持续的、自主的竞争优势。

+> —— *Djon Kleine,BCG 合伙人兼总经理*

+

+### Box

+

+> 我们期待扩大与 Google 的合作,使 Box 智能体能够使用 A2A 与 Google Cloud 的智能体生态系统协同工作,共同创新以塑造 AI 智能体的未来,同时使组织能够更好地自动化工作流程、降低成本并生成值得信赖的 AI 输出。*

+> ——Ketan Kittur,Box 的产品管理、平台和集成副总裁*

+

+### **C3 AI**

+

+> 在 C3 AI,我们认为开放、可互操作的系统是使企业 AI 在现实世界发挥作用和创造价值的关键,A2A 有潜力帮助客户打破孤岛,并安全地使 AI 智能体在系统、团队和应用程序之间协同工作。

+> —— *Nikhil Krishnan,C3 AI 高级副总裁兼负责数据科学的首席技术官*

+

+### **Chronosphere**

+

+> A2A 将支持可靠且安全的智能体专业化和协调,为计算编排的新时代打开大门,使公司能够更快、更可靠地交付产品和服务,并使他们能够将工程工作重点放在推动创新和创造价值上。*

+> ——Rob Skillington,创始人兼首席技术官*

+

+### **Cognizant**

+

+> “作为企业多智能体系统的先驱,Cognizant 致力于实现智能体互操作性,并主动将其视作我们客户的关键要求。”

+> —— *Babak Hodjat,AI 首席技术官*

+

+### **Cohere**

+

+> 在 Cohere,我们正在构建企业放心地采用自主智能体所需的安全 AI 基础设施,而开放的 A2A 协议可确保即使在气隙环境中也能实现无缝、可信的协作,使企业能够在不影响控制或合规性的情况下进行大规模创新。*

+> ——Autumn Moulder,Cohere 工程副总裁*

+

+### **Confluent**

+

+> A2A 使智能智能体能够建立直接、实时的数据交换,简化复杂的数据管道,从根本上改变智能体的通信方式并促进决策。*

+> ——Pascal Vantrepote,Confluent 创新高级总监*

+

+### **Cotality(原 CoreLogic)**

+

+> A2A 为智能、实时通信和协作的新时代打开了大门,Cotality 将其带给房屋贷款、保险、房地产和政府领域的客户,帮助他们提高生产力,加快决策速度。*

+> ——Sachin Rajpal,Cotality 数据解决方案总经理*

+

+### **DataStax**

+

+> DataStax 很高兴能成为 A2A 的一部分,并探索如何利用它为 Langflow 提供支持,这是迈向真正可互操作的 AI 系统的重要一步,这些系统可以协作完成跨多个环境的复杂任务。*

+> ——Ed Anuff,DataStax 首席产品官*

+

+### **Datadog**

+

+> 我们很高兴看到 Google Cloud 推出 A2A 协议,以简化复杂智能体系统的开发,这将帮助 Datadog 使其用户能够构建更具创新性、更优的和更安全的智能体 AI 应用程序。*

+> ——Yrieix Garnier,Datadog 产品副总裁*

+

+### **Elastic**

+

+> Elastic 支持开放、可互操作的智能体生态系统这一愿景,期待与 Google Cloud 和其他行业领导者合作开发 A2A,并提供其数据管理和工作流程编排经验来改进该协议。*

+> ——Steve Kearns,Elastic 副总裁兼搜索业务总经理*

+

+### **GrowthLoop**

+

+> A2A 有潜力加速 GrowthLoop 为我们的客户实现复合营销的愿景——使我们的 AI 智能体能够与其他专业智能体无缝协作,更快地从企业数据中学习,并快速优化整个营销生态系统中的活动,同时尊重客户云基础设施上的数据隐私。*

+> ——Anthony Rotio,GrowthLoop 首席数据战略官*

+

+### **Harness**

+

+> Harness 很高兴支持 A2A,并致力于通过将 AI 驱动的智能集成到软件生命周期的每个阶段来简化开发者体验,从而使团队能够从运行时数据中获得更深入的见解,自动化复杂的工作流程,提高系统性能。*

+> ——Gurashish Brar,Harness 工程主管*

+

+### **Incorta**

+

+> Incorta 很高兴支持 A2A 并推进客户的智能体通信,使未来的企业自动化更智能、更快速,并真正实现数据驱动。*

+> ——Osama Elkady,Incorta 首席执行官*

+

+### **Intuit**

+

+> Intuit 坚信,像 A2A 这样的开源协议将支持复杂的智能体工作流程,加速我们的合作伙伴集成,并通过有效协作的跨平台智能体推动行业向前发展。*

+> ——Tapasvi Moturu,Intuit 的智能体框架软件工程副总裁*

+

+### **JetBrains**

+

+> 我们很高兴成为 A2A 的产品发布合作伙伴,该计划增强了智能体协作,使我们更接近真正的多智能体世界,为 JetBrains IDE、团队工具和 Google Cloud 的开发者赋能。*

+> ——Vladislav Tankov,JetBrains 的 AI 总监*

+

+### **JFrog**

+

+> JFrog 很高兴加入 A2A 协议,我们认为该计划将有助于克服当今的许多集成挑战,并将成为新一代智能体应用程序的关键驱动力。*

+> ——Yoav Landman,JFrog 首席技术官兼联合创始人*

+

+### **LabelBox**

+

+> A2A 是充分发挥 AI 智能体潜力的关键一步,它支持 AI 真正增强人类能力、实现复杂工作流程自动化和推动创新的未来。*

+> ——创始人兼首席执行官 Manu Sharma*

+

+### **LangChain**

+

+> LangChain 认为,智能体与其他智能体交互是指日可待的未来,我们很高兴与 Google Cloud 合作,提出一个满足智能体构建者和用户需求的共享协议。*

+> ——Harrison Chase,LangChain 联合创始人兼首席执行官*

+

+### **MongoDB**

+

+> 通过将 MongoDB 强大的数据库基础设施和混合搜索功能与 A2A 和 Google Cloud 的前沿 AI 模型相结合,企业可以释放零售、制造等行业的新可能性,从而重新定义 AI 应用程序的未来。*

+> ——Andrew Davidson,MongoDB 产品高级副总裁*

+

+### **Neo4j**

+

+> Neo4j 很荣幸与 Google Cloud 合作,将我们的图技术知识图谱和 GraphRAG 功能与 A2A 相结合,帮助组织释放新的自动化和智能水平,同时确保智能体交互在上下文中保持相关、可解释和值得信赖。*

+> ——Sudhir Hasbe,Neo4j 首席产品官*

+

+### **New Relic**

+

+> 我们相信,Google Cloud 的 A2A 协议与 New Relic 的智能可观测性平台之间的协作,将通过简化集成、促进跨不同系统的数据交换,并最终创建一个更统一的 AI 智能体生态系统,为我们的客户提供显著价值。*

+> ——Thomas Lloyd,New Relic 首席业务和运营官*

+

+### **Pendo**

+

+> 我们很荣幸与 Google Cloud 的 A2A 协议合作,这将是使 AI 智能体能够有效协同工作,同时保持大规模信任和可用性的关键一步。

+> —— *Rahul Jain,Pendo 联合创始人兼首席产品官*

+

+### **PayPal**

+

+> PayPal 支持 Google Cloud 的 A2A 协议,这代表着开发者和商家创建由智能体 AI 驱动的新一代商业体验的新方式。*

+> ——Prakhar Mehrotra,PayPal 高级副总裁兼人工智能主管*

+

+### **普华永道**

+

+> 在普华永道,我们相信企业 AI 的未来在于无缝协作,它不仅仅是人员和系统之间的协作,还有智能体之间的协作;因此,我们很荣幸能与普华永道的智能体操作系统协作支持 A2A,帮助制定企业级的安全、可扩展的智能体互操作性标准。

+> —— *Dallas Dolen,全球 Google Cloud 联盟负责人*

+

+### **SAP**

+

+> SAP 致力于与 Google Cloud 和更广泛的生态系统合作,通过 A2A 协议塑造智能体互操作性的未来,这是使 SAP Joule 和其他 AI 智能体能够跨企业平台无缝协作,并释放端到端业务流程的全部潜力的关键一步。*

+> ——Walter Sun,高级副总裁兼 AI 工程全球主管*

+

+### **Salesforce**

+

+> Salesforce 正在率先支持 A2A 标准,以扩展我们的开放平台,使 AI 智能体能够在 Agentforce 和其他生态系统中无缝协作,将脱节的功能转化为精心设计的解决方案,并为客户和员工提供增强的数字化劳动力。*

+> ——产品架构副总裁 Gary Lerhaupt*

+

+### **ServiceNow**

+

+> ServiceNow 和 Google Cloud 正在合作,为智能体间互操作性设定新的行业标准,我们相信 A2A 将为更高效、更互联的支持体验奠定基础。*

+> ——Pat Casey,ServiceNow 的首席技术官兼 DevOps 执行副总裁*

+

+### **Supertab**

+

+> 借助 Google Cloud 的 A2A 协议和 Supertab Connect,智能体将能够像人类企业一样支付服务费用、收取服务费用和交换服务。*

+> ——Cosmin Ene,Supertab 创始人*

+

+### **UKG**

+

+> UKG 很高兴与 Google Cloud 合作开发新的 A2A 协议,该框架将使我们能够构建更智能、更具支持性的人力资本和劳动力体验,以前所未有的方式预测和响应员工需求。*

+> ——Eli Tsinovoi,UKG 的 AI 主管*

+

+### **Weights & Biases**

+

+> Weights & Biases 很荣幸与 Google Cloud 合作开发 A2A 协议,该协议设定了一个关键的开放标准,使组织能够放心地部署、编排和扩展各种 AI 智能体,而无需考虑底层技术。*

+> ——Shawn Lewis,Weights & Biases 首席技术官兼联合创始人*

+

+## 6 服务合作伙伴

+

+### **埃森哲**

+

+> Google Cloud 的多智能体 A2A 协议是将跨不同平台的特定领域智能体连接起来以应对复杂挑战的桥梁,从而实现无缝通信和集体智能,以实现更智能和更高效的智能体解决方案。*

+> ——Scott Alfieri,埃森哲 AGBG 全球负责人*

+

+### **德勤**

+

+> 智能体间互操作性是实现智能体 AI 架构演进的基础要素,Google Cloud 发起的 A2A 计划将技术行业参与者的生态系统凝聚到一起,共同开发和支持该协议,将极大地加速智能体 AI 的采用。*

+> ——德勤的 Gopal Srinivasan*

+

+### **EPAM**

+

+> 我们已经在 A2A 领域处于领先地位,专注于能产生实际商业价值的行业解决方案,此等价值包括节省时间、减少管理费用以及帮助客户增加收入和改进流程(如药物发现过程中 FDA 文件的编制)。*

+> ——Marc Cerro,EPAM 全球 Google Cloud 合作伙伴副总裁*

+

+### **HCLTech**

+

+> HCLTech 处于智能体企业的前沿,我们很荣幸与 Google Cloud 合作,通过开放的 A2A 标准定义智能体间互操作性并推进智能体 AI 的可能性。*

+> ——Vijay Guntur,HCLTech 首席技术官兼生态系统主管*

+

+### **毕马威**

+

+> 毕马威很高兴能参与这项新兴计划,因为 A2A 提供了不同 AI 智能体真正有效和负责任地协作所需的基本标准,借助该标准,客户和企业可以无缝地利用 AI 来实现创新和效率提升。*

+> ——Sherif AbdElGawad,毕马威的合伙人兼 Google Cloud 和 AI 负责人*

+

+**Quantiphi**

+

+> 智能体动态发现功能并打造跨平台用户体验的能力对于释放企业的真正潜力至关重要。我们认为 A2A 协议是支持企业构建此类可互操作智能体的关键一步。*

+> ——Asif Hasan,Quantiphi 联合创始人*

+

+### **塔塔咨询服务公司 (TCS)**

+

+> A2A 协议为智能体自动化新时代奠定了基础,语义互操作性在新时代占据突出地位,我们很荣幸能够引领这一变革之旅。*

+> ——Anupam Singhal,TCS 主管制造业务的总裁*

+

+### **Wipro**

+

+> 因为 AI 的未来在于无缝协作,所以像 A2A 这样的开放协议将成为 AI 智能体大规模推动创新的生态系统的基础。*

+> ——Nagendra P Bandaru,Wipro 管理合伙人兼技术服务全球主管*

+

+## 7 详细了解A2A

+

+要了解有关 A2A框架更多信息,仔细研读[**完整规范草案**](https://github.com/google/A2A),并探索[**可用的代码示例**](https://google.github.io/A2A),以根据其代码检查该协议的结构实验。

+

+[提交想法](https://docs.google.com/forms/d/e/1FAIpQLScS23OMSKnVFmYeqS2dP7dxY3eTyT7lmtGLUa8OJZfP4RTijQ/viewform)、[贡献文档](https://github.com/google/A2A/blob/main/CONTRIBUTING.md)以及与社区互动,为协议的演进做出贡献,一起定义智能体互操作性的未来。

\ No newline at end of file

diff --git a/docs/md/AI/llm/Build-App-with-Dify.md b/docs/md/AI/agent/Build-App-with-Dify.md

similarity index 100%

rename from docs/md/AI/llm/Build-App-with-Dify.md

rename to docs/md/AI/agent/Build-App-with-Dify.md

diff --git a/docs/md/AI/agent/augment.md b/docs/md/AI/agent/augment.md

new file mode 100644

index 0000000000..e9b0c05a73

--- /dev/null

+++ b/docs/md/AI/agent/augment.md

@@ -0,0 +1,226 @@

+# 告别文档搜索与同事打扰:Augment AI 聊天 + 200K 上下文全方位助力开发

+

+## 0 前言

+

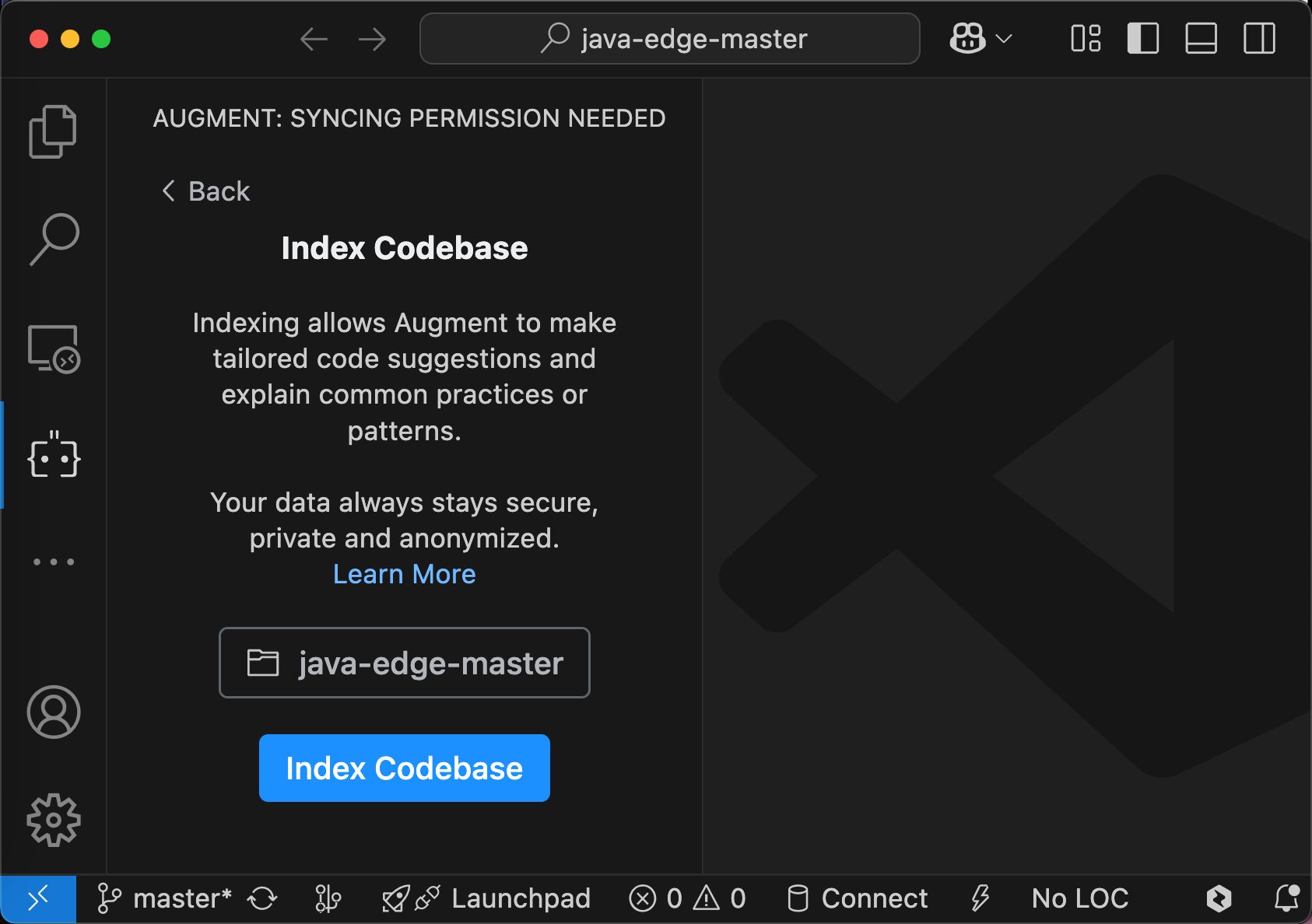

+超强AI,助力你的编码方式。每按下一个键,即可获得极速、全面的代码库上下文。你的所有代码、文档及依赖项都会自动嵌入到每一次代码变更中,实时更新。

+

+各种环境安装支持:

+

+

+

+## 1 Agent

+

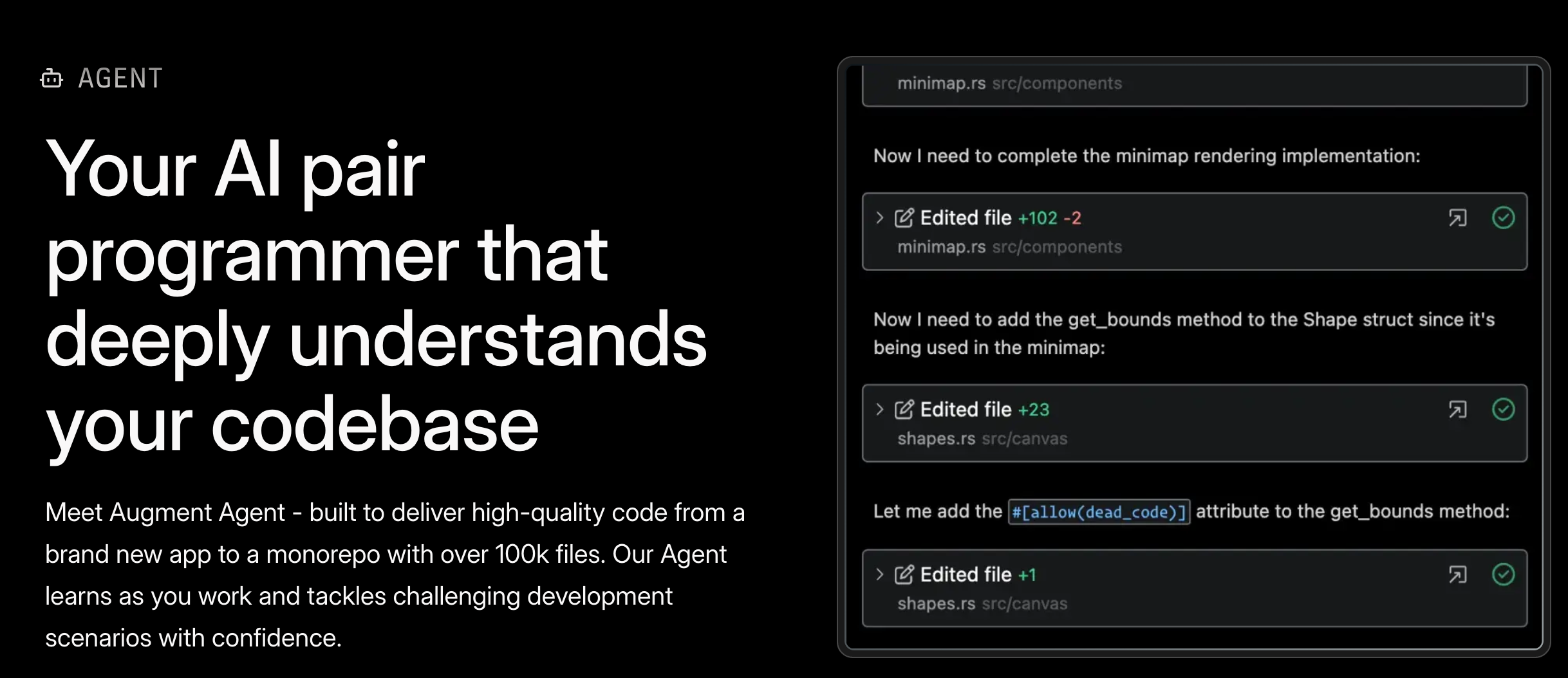

+### 1.0 你的AI结对程序员,能深入理解你的代码库

+

+

+

+ Meet Augment Agent——专为从全新应用到拥有超过10万文件的单体仓库,交付高质量代码而打造。我们的Agent会在你工作时不断学习,并自信应对各种棘手的开发场景。处理大型代码库时依然轻松。

+

+### 1.1 记忆与上下文

+

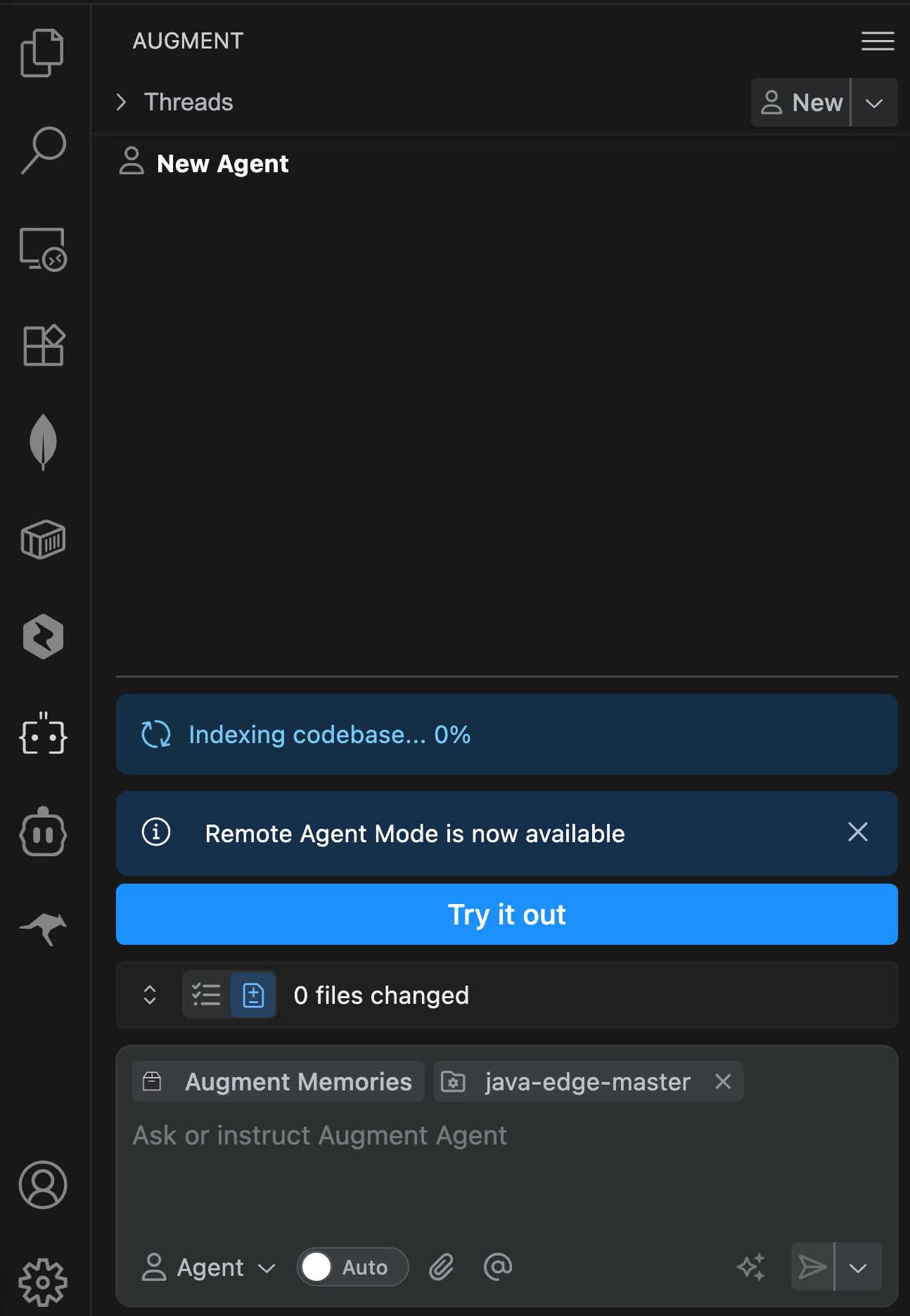

+我们的智能助手会自动引入“记忆”功能,这些记忆会随着你的工作动态更新,并在对话间持续保留,从而不断提升代码生成质量,帮助你更快完成任务,同时精准匹配你的代码风格与编写模式。

+

+Agent Memories:

+

+

+

+### 1.2 原生工具与MCP支持

+

+通过我们提供的原生工具,轻松接入GitHub、Jira、Confluence、Notion、Linear等平台;同时,全面支持Vercel、Cloudflare及其他基础设施的MCP集成。

+

+Agent Tools:

+

+

+

+### 1.3 代码检查点

+

+自动变更追踪,支持轻松回滚,助你保持编程风格。

+

+### 1.4 多模态功能

+

+共享截图、Figma 文件及任何视觉内容,便于修复 bug 或实现 UI 设计。

+

+### 1.5 终端命令

+

+运行 npm 安装、启动开发服务器、执行 Git 命令,并直接与你的终端互动。

+

+### 1.6 200K上下文容量

+

+业界领先的上下文处理能力——是同类工具的两倍。

+

+基于项目的问答(Ask)表现出色,理解准确,响应极快。在我的测试中,与Cursor对比,Augment在处理涉及整个项目代码库的复杂问题时,其上下文理解的精准度也常常更胜一筹。

+

+

+

+考虑到 Cursor 可能未使用其最强模型,Augment的上下文理解和回答质量也至少与 Cursor 不相上下,甚至在某些场景下略显优势。这足以证明 Augment 在上下文处理的底蕴。

+

+### remote agent mode

+

+

+

+点击 try it out后:

+

+### Inline Edit

+

+Augment 的行内编辑模式有一个特点:它会在一个独立的、临时的代码副本中进行操作(推测是基于原始文件在内存中生成副本)。虽然不是直接在原始文件上修改,少了一点“所见即所得”的直观感,但这并不会牺牲效率。最终的修改会清晰地以 Diff (差异对比) 的形式呈现,方便你确认和应用。

+

+## 2 Chat

+

+随时问我关于你代码的问题,立即获得解答——无需再费时查阅文档、打扰同事,或提交工单。聊天帮你快速扫清障碍!

+

+

+

+### 快速上手

+

+自信地投入任何任务。迅速了解组件的工作原理,深入排查故障,或轻松驾驭全新 API。

+

+### 保持高效流畅

+

+无需打断团队协作或翻阅文档,即可轻松掌握代码库及依赖项的详细信息。

+

+### 深度探索

+

+Chat 会主动揭示其答案背后的来源,让你一目了然地看到哪些因素影响了它的回答。

+

+### 精准聚焦

+

+灵活选择代码块、文件,甚至整个文件夹,以精确界定讨论范围。

+

+### 智能应用

+

+Augment 会根据需求自动调整代码,并将其无缝整合到正确的位置。

+

+### 第三方文档

+

+内置300多种外部文档包,助你事半功倍。

+

+## 3 Next Edit

+

+### 为你的工作提供逐段指引

+

+即使是微小的改动,也会在代码库中引发连锁反应。Next Edit 会引导你完成代码、测试和文档中相关的更新步骤。

+

+

+

+### 让复杂变更化繁为简

+

+重构、依赖升级和模式变更往往伴随着大量重复性工作。告别手动查找与替换,选择循序渐进的引导式操作。

+

+

+

+### 轻松掌控全局

+

+无需记住繁琐细节,即可快速完成多步骤变更,让流程更顺畅。

+

+

+

+### 渐进式编辑

+

+只需轻按键盘,即可直接跳转到下一处修改。

+

+### 跨文件编辑

+

+支持同时对多行代码或完全不同的文件进行修改。

+

+### 智能清理

+

+自动识别并移除未使用或已失效的代码片段。

+

+### 轻松导入

+

+随时调用任意 SDK、函数或 API,无缝衔接开发流程,绝不打断你的工作节奏。

+

+## 4 Completions

+

+### 你需要的代码,随时可用

+

+通过个性化、真正理解你的代码库、依赖关系及外部API的内联补全功能,更快写出更优质的代码。

+

+

+

+### 轻松应对各项任务

+

+补全速度飞快——你再也不用为效率发愁。无论是复杂的代码片段、测试,还是整段函数,都能瞬间搞定。

+

+

+

+### 减轻认知负担

+

+记住类、API和架构设计本就不易,而补全功能让你轻松触手可及,省去记忆之苦。

+

+

+

+### 洞悉你的代码

+

+补全功能精准反映你的代码结构、依赖关系、编程习惯及最佳实践。

+

+### 内联提示,自然高效

+

+只需用自然语言撰写注释,补全功能便会自动帮你实现。

+

+### 极速响应

+

+你思维敏捷,Augment同样如此——它总能迅速跟上你的节奏,让你无需再为编辑器的延迟而烦恼。

+

+### 智能感知聊天内容

+

+补全功能会无缝衔接你之前的聊天记录,确保工作流程始终连贯顺畅。

+

+## Slack

+

+### 保持对话顺畅

+

+你需要的一切,助你快速获得答案、让新人迅速上手,或即时做出决策。

+

+### 只需向 Augment 提问

+

+无需等待团队回复或打断他们的工作节奏,即可快速获取答案。

+

+### 优于搜索

+

+将代码库中的洞察与答案融入团队的技术讨论中。

+

+

+

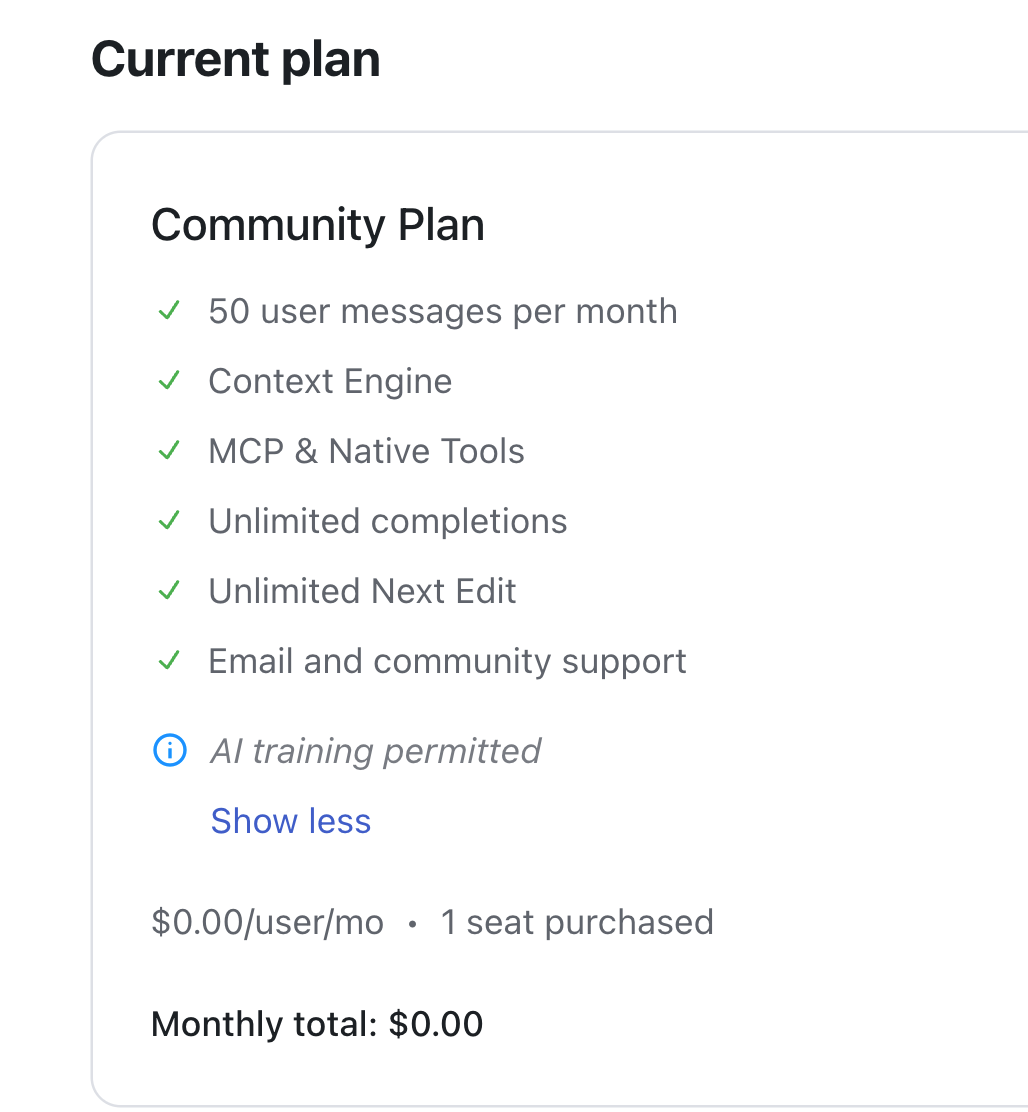

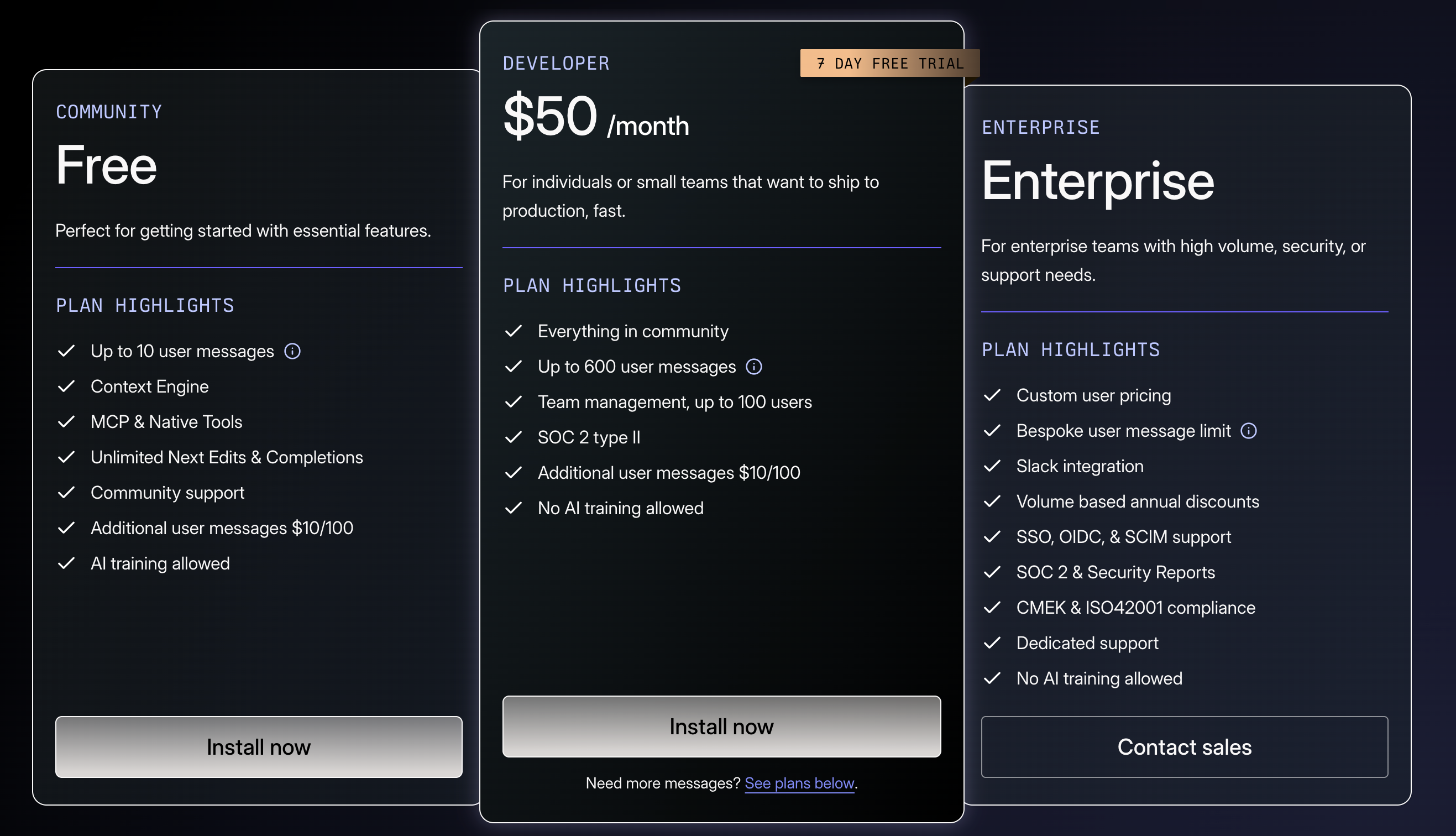

+## 6 价格

+

+近乎免费的日常体验:

+

+

+

+新用户免费体验 Pro 版本一个月。试用期结束后,自动降级为免费版。免费版除了 Ask 问答功能有每月 50 次限制,其他核心功能(如 Next Edit、Inline Edit)与 Pro 版无异!

+

+

+

+每月 50 次的 Ask 对日常编码、补全和行内编辑为主的开发者基本足够。如需大量提问,如刚进新公司,读一群屎山代码,可多备几个账号。

+

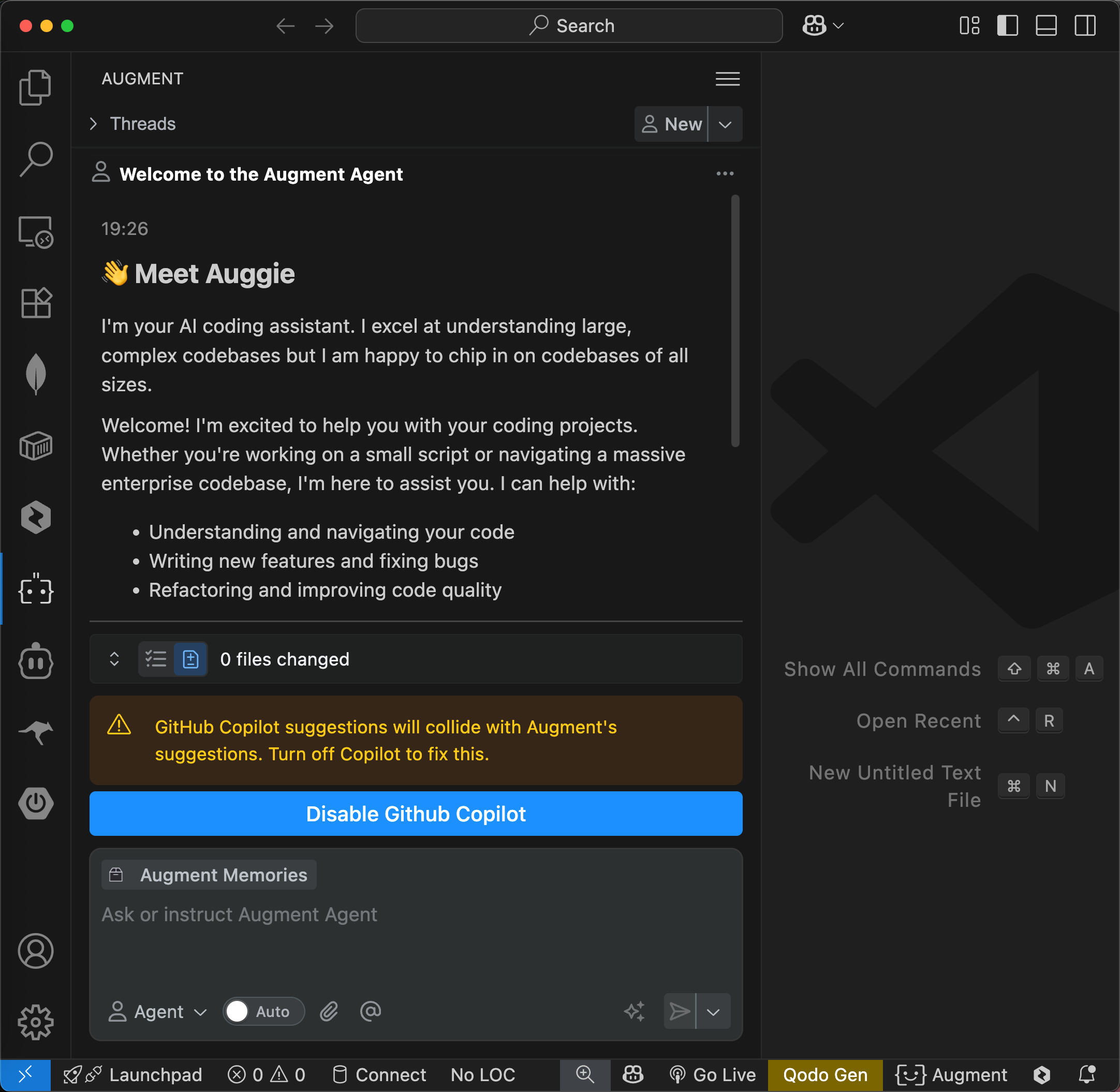

+## 7 功能冲突

+

+Augment 与 Copilot 等其他 AI 代码补全/建议类插件通常不能同时启用,否则可能会产生冲突。请确保在使用 Augment 时禁用其他同类插件。

+

+```java

+欢迎使用 Augment Agent

+19:26

+

+👋 认识一下 Auggie

+我是你的 AI 编码助理,擅长理解大型、复杂的代码库,同时也乐于帮助任何规模的项目。

+

+---

+

+欢迎!我很高兴能协助你的编码项目。无论你是在编写一个小脚本,还是在浏览庞大的企业级代码库,我都可以为你提供帮助。我能帮你完成以下工作:

+

+- 理解并浏览代码

+- 编写新功能与修复 Bug

+- 重构代码并提升代码质量

+- 编写测试和文档

+- 搭建新项目

+- 以及更多其他任务

+

+今天想要一起做什么呢?随时分享你的项目,或就编码相关的任何问题向我提问!

+```

+

+

+

+## 8 总结

+

+Augment 是一款开发者AI平台,助你轻松理解代码、快速排查问题并加速交付,因为它能深入洞察您的代码库。通过聊天功能、智能补全及代码建议,让你事半功倍。

\ No newline at end of file

diff --git a/docs/md/AI/llm/boost-ai-workflow-resilience-with-error-handling.md b/docs/md/AI/agent/boost-ai-workflow-resilience-with-error-handling.md

similarity index 100%

rename from docs/md/AI/llm/boost-ai-workflow-resilience-with-error-handling.md

rename to docs/md/AI/agent/boost-ai-workflow-resilience-with-error-handling.md

diff --git a/docs/md/AI/agent/changelog-cursor.md b/docs/md/AI/agent/changelog-cursor.md

index fb566cb4e6..b41cd1ede8 100644

--- a/docs/md/AI/agent/changelog-cursor.md

+++ b/docs/md/AI/agent/changelog-cursor.md

@@ -2,6 +2,578 @@

旨在让你获得超凡的生产力, Cursor 是使用 AI 编写代码的最佳方式。

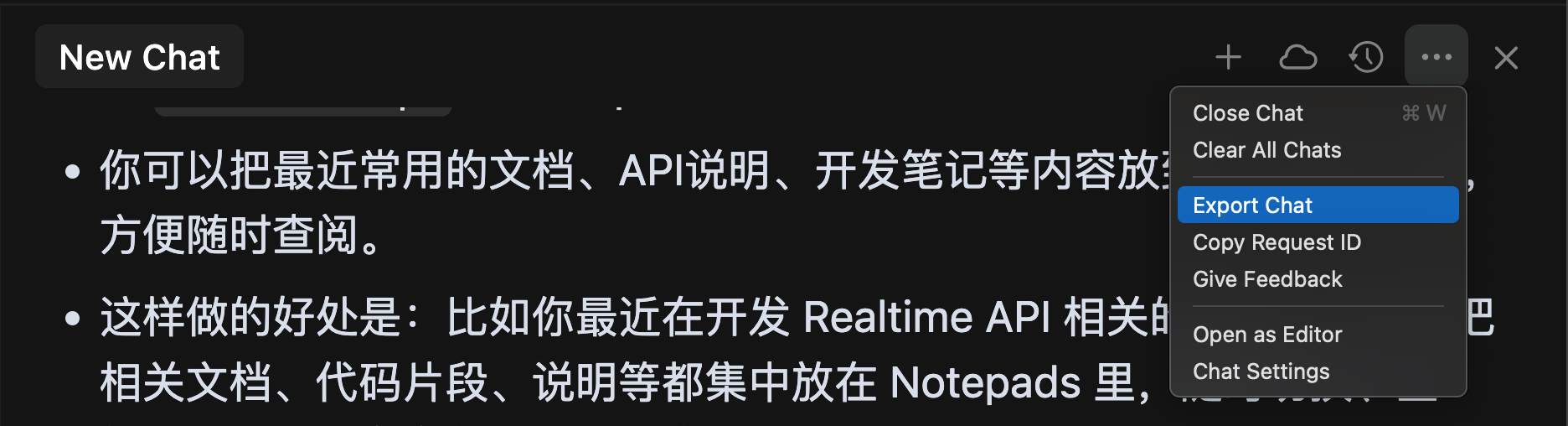

+## 1.4 - 更强大的 Agent 工具、可控性和使用情况可视化

+

+2025 年 8 月 6 日

+

+### 更强的 Agent 可控性

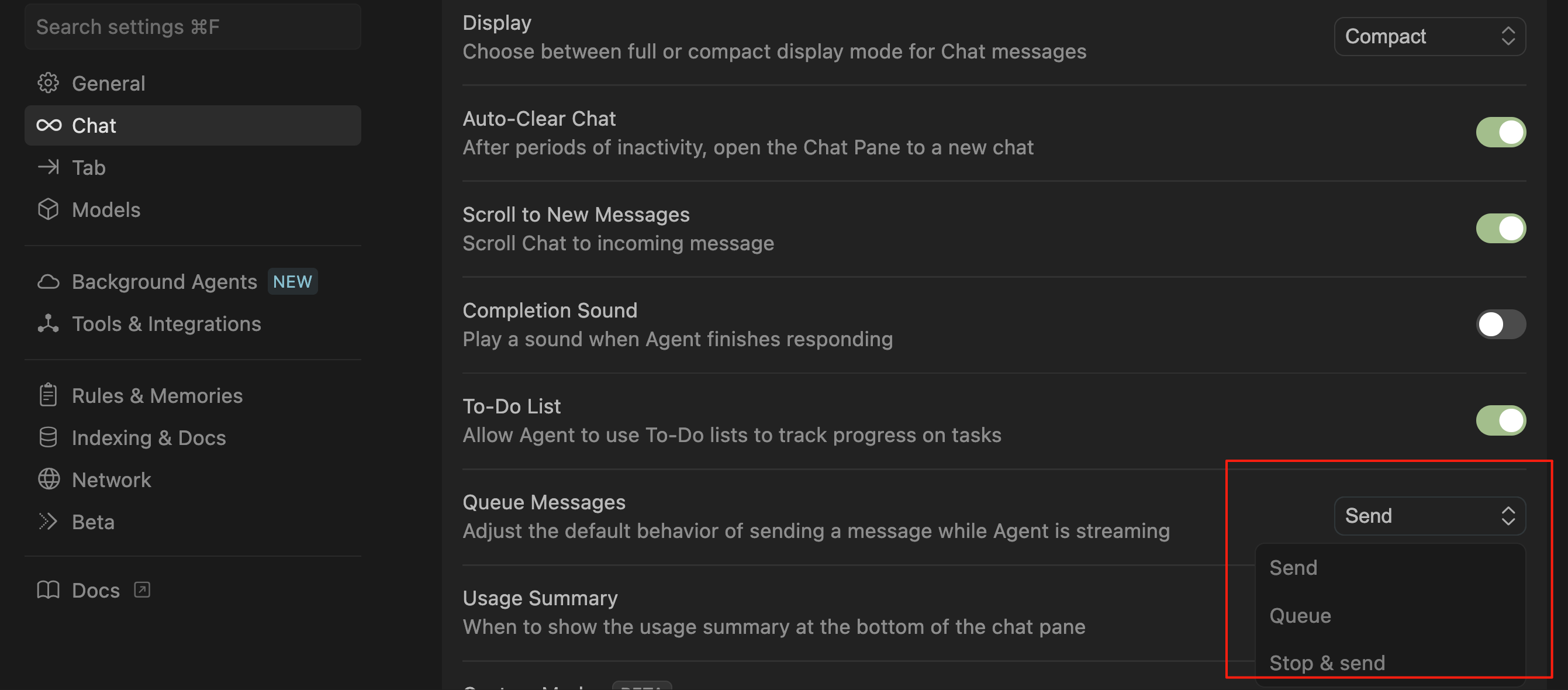

+

+当 Cursor 正在运行时发送消息,现可更有效地引导 Agent 行为。发送的消息将在下一个合适的时机执行,通常在调用工具之后,而非等到生成完成才执行。

+

+- ⌥+Enter(Windows 为 Alt+Enter)可像以前一样排队发消息

+- ⌘+Enter(Windows 为 Ctrl+Enter)则立即中断当前操作并发送消息

+

+可在 Cursor 设置中调整默认行为:设置 -> 聊天 -> 消息排队。

+

+

+

+### 改进的 Agent 工具

+

+处理大型代码库时,Agent 表现显著提升。上下文选择更相关,token 使用更高效,编辑质量更优:

+

+- **读取文件:** 现在在合适的情况下可以读取完整文件,并取消了 2MB 的大小限制。

+- **列出文件:** 一次调用就能浏览整个目录树,并显示文件数量、类型等元数据。

+- **代码库搜索:** 排名和索引方式更优,返回的上下文更相关

+- **网页搜索:** 使用轻量本地模型,返回更简洁、更精准的搜索结果

+

+### 不同 Agent 可选用不同模型

+

+可为不同tab或编辑器中的 Agent 指定不同的模型。如果你复制了一个 Agent,其所用模型也会一并保留。

+

+### 使用量和价格可视化

+

+可在聊天界面查看使用情况。不论是总使用量 or 当你超过套餐配额 50% 时,都可以看到清晰统计信息。

+

+这个使用情况摘要可以在设置中开启或关闭。团队和企业用户将在 9 月获得此功能的访问权限。

+

+

+

+### 紧凑聊天模式

+

+会隐藏工具图标、默认折叠差异内容(diffs),并在闲置时自动隐藏输入框。

+

+对有大量工具调用、终端操作和差异查看的长时间会话,该模式更实用。可在设置中开启或关闭该模式。

+

+开启状态:

+

+

+

+关闭状态:

+

+

+

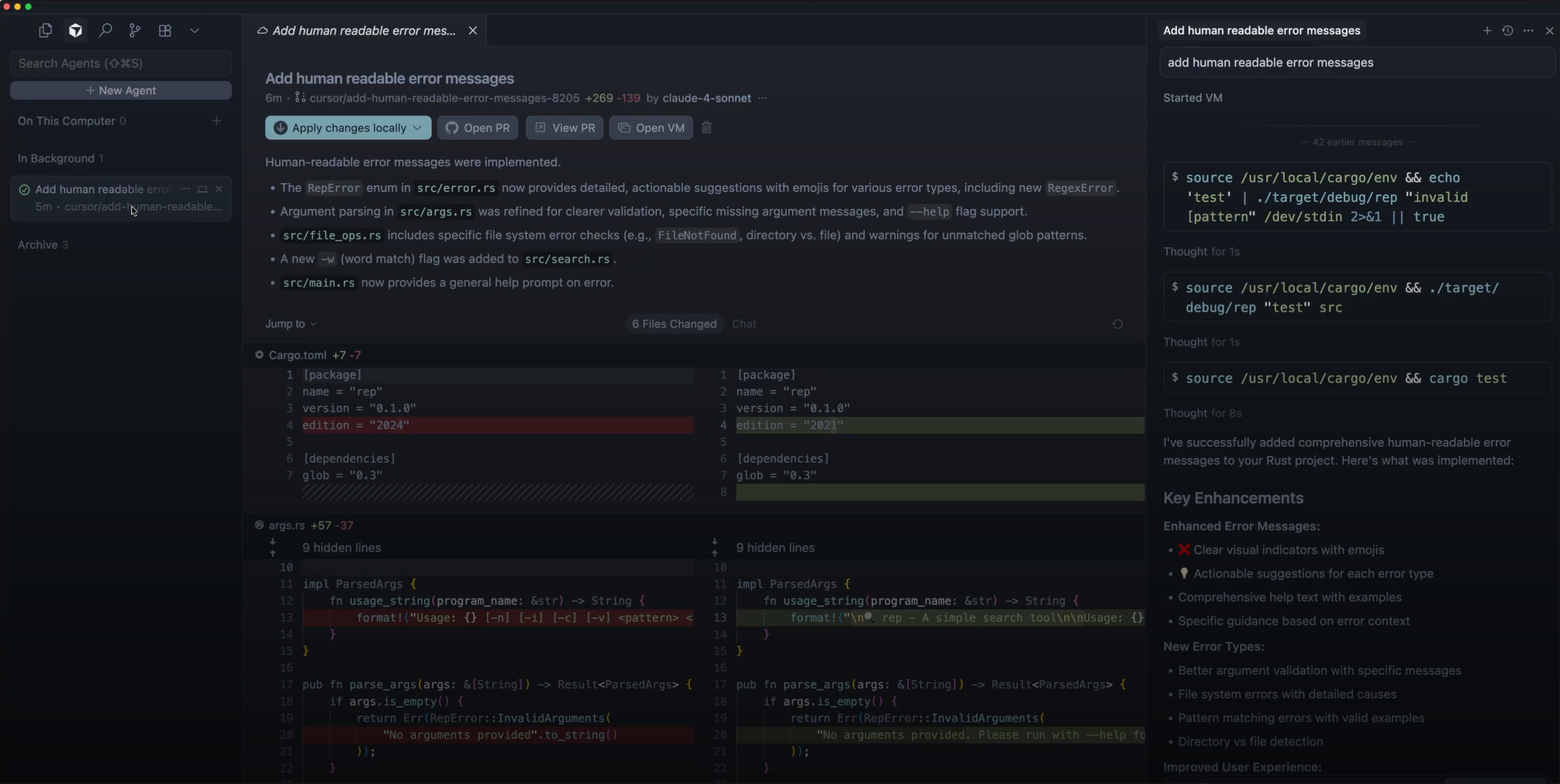

+### GitHub 支持后台 Agent

+

+可在 GitHub 的 Pull Request 中直接使用 Agent。只需在评论中 @Cursor,Agent 就会读取提示内容、进行修复,并提交代码。

+

+后台 Agent 还会通过评论和待办事项(todo)更新你任务的执行进度。

+

+GitHub PR 中的后台 Agent:

+

+

+

+### 所有 Agent 的侧边栏管理

+

+可在左侧边栏查看和管理所有 Agent,包括前台和后台的。点击某个后台 Agent,就能查看它在远程机器上的执行状态。

+

+

+

+### 更快的后台 Agent 启动速度

+

+对后台 Agent 大量优化,启动速度提升一倍。

+

+

+

+### 企业功能

+

+- [AI 代码追踪 API](https://docs.cursor.com/en/account/teams/ai-code-tracking-api):以提交为单位,追踪 AI 使用情况和被接受的更改

+- [屏蔽列表管理 API](https://docs.cursor.com/en/account/teams/admin-api#repo-blocklists-api):禁止特定文件或目录被索引或用于上下文

+- [成员导出](https://cursor.com/dashboard?tab=members):从控制台将工作区的所有成员导出为 CSV 文件

+

+## 1.3-与Agent共享终端、聊天中上下文使用情况查看、编辑更快

+

+2025年7月29日

+

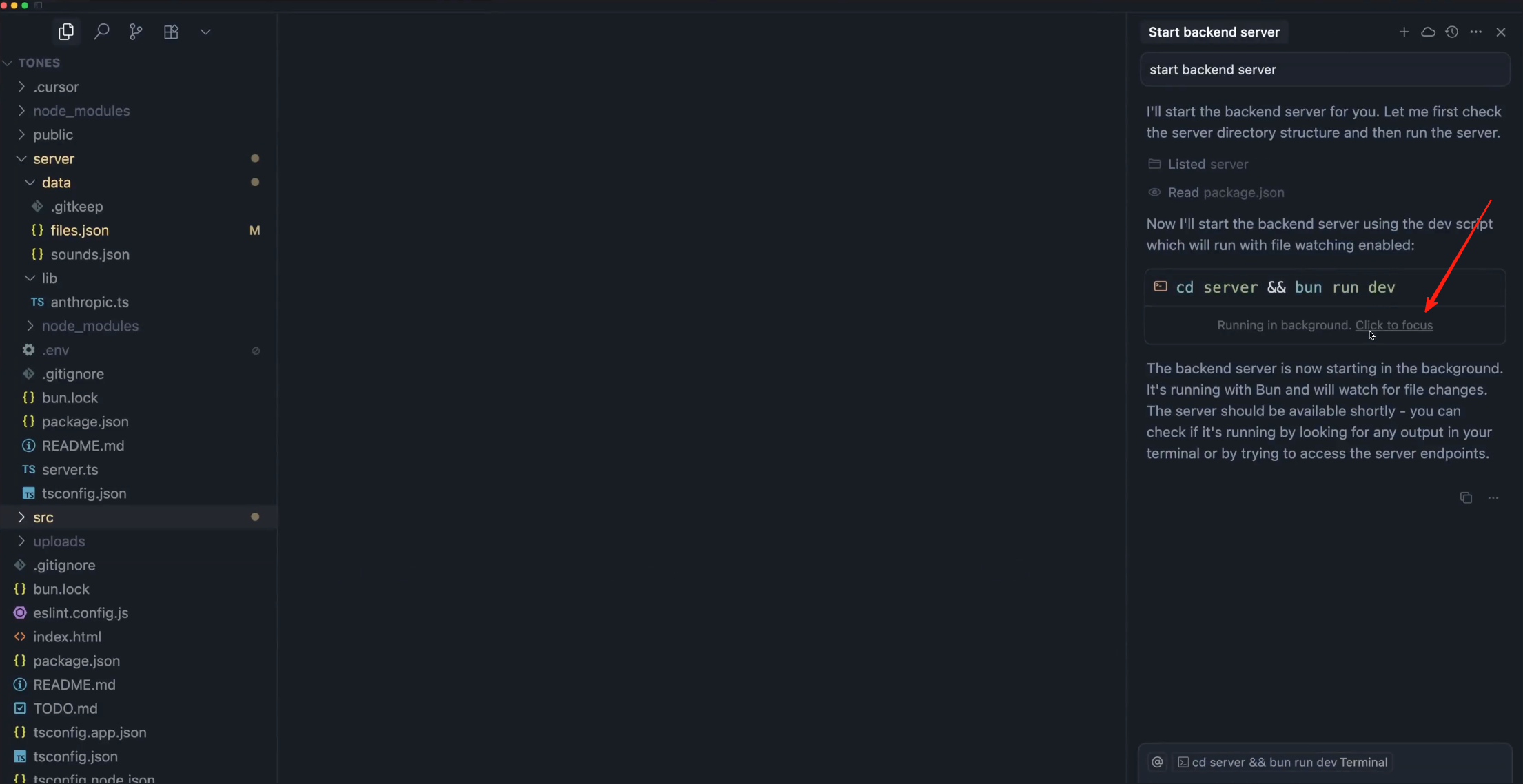

+### 与Agent共享终端

+

+现在Agent可用你的本地终端。若当前没有打开终端,系统会自动创建一个新的,并在后台运行。点击“Focus”可将终端前置,可查看Agent正在执行的命令,也可随时接管操作。

+

+

+

+### 聊天中查看上下文使用情况

+

+在一次对话结束后,现可看到上下文窗口的使用情况。

+

+

+

+### 编辑速度更快

+

+通过懒加载代码检查错误,现在Agent的编辑速度更快了。搜索替换的延迟减少了25%,应用编辑的速度提升了近11%。

+

+

+

+改进:

+

+- 聊天窗口支持激活标签页

+- 右键目录后可直接发送到聊天中

+- 检查点功能可用于Notebooks

+- 提升安全性:用白名单替代黑名单进行自动运行控制

+- 聊天中移除“手动”(*Manual*)模式

+- 启用后,可通过命令面板访问新的扩展监控功能

+

+修复:

+

+- 扩展市场支持自定义 URL

+

+企业版更新:

+

+- 支持团队管理员配置扩展白名单

+

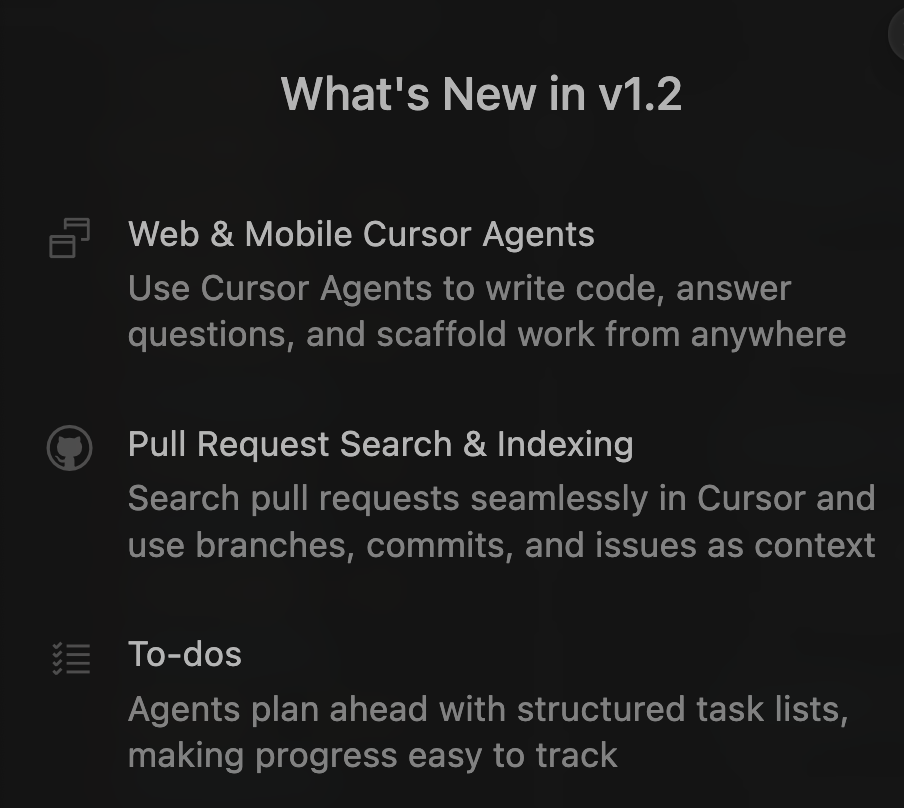

+## 1.2—Agent规划、更好上下文支持 & 更快的 Tab 补全

+

+

+

+2025年7月3日

+

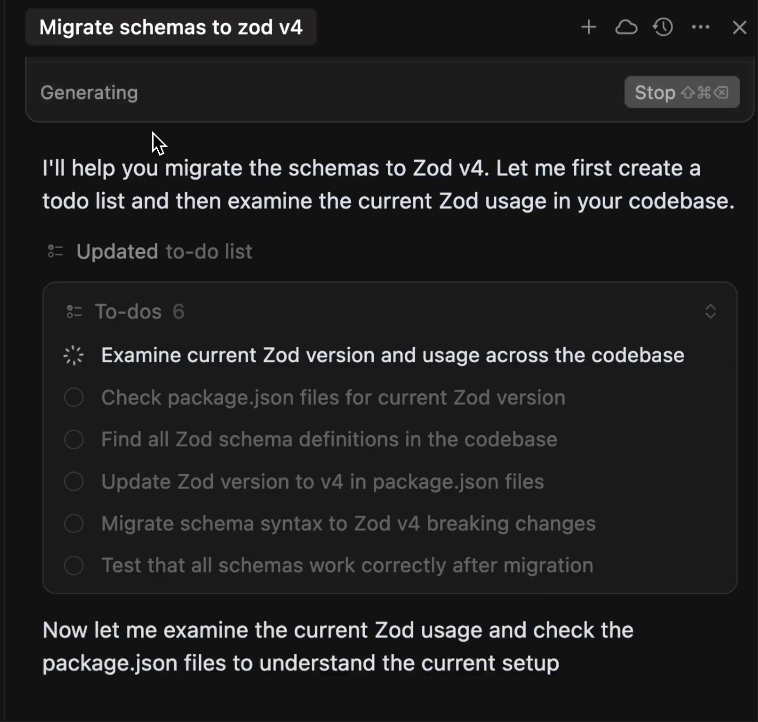

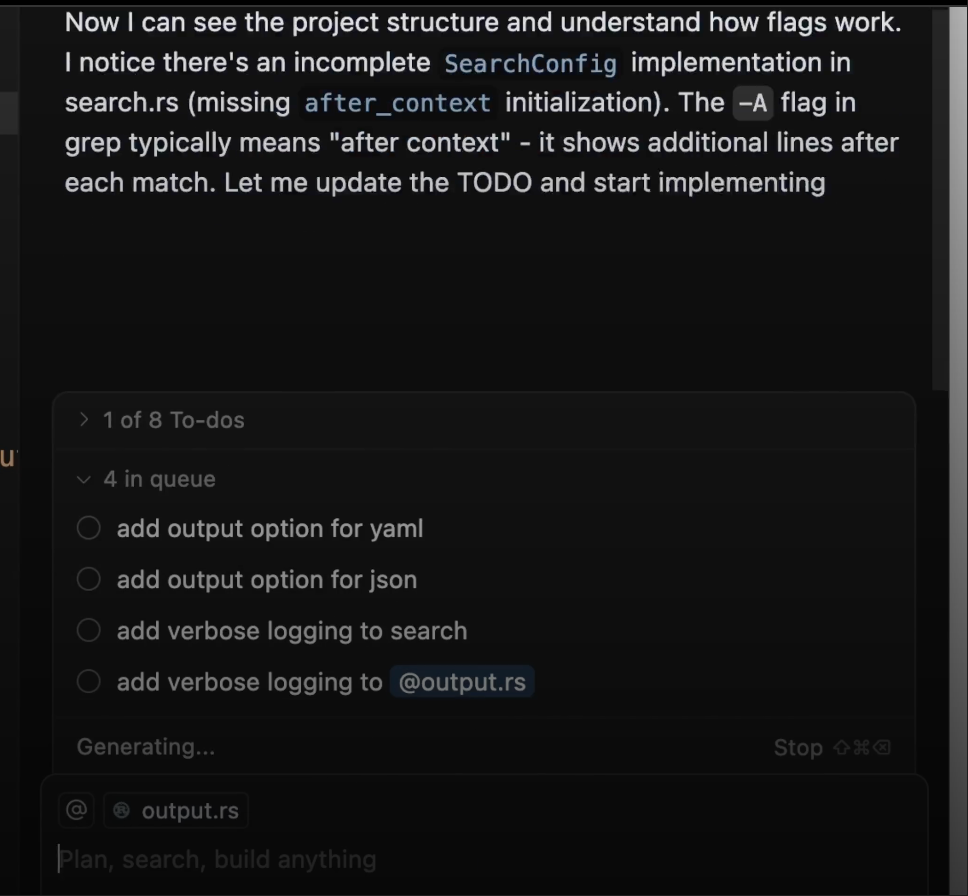

+### Agent To-dos

+

+Agent可提前规划任务,使用结构化的待办清单,让需要长时间完成的任务清晰、易追踪。

+

+Agent会将大型任务拆分为多个子任务,展示其依赖关系,这些都可在对话中看到,并在需要时同步到 Slack。任务推进时,它也会实时更新待办列表,保持上下文清晰、互动流程可控。

+

+

+

+如设置 Slack 集成,也可在 Slack 中查看这些待办事项!

+

+### 消息排队

+

+可为Agent排队发送后续指令,只需输入你的指令并发送即可。当当前任务完成后,它就会继续执行排队中的指令。你也可随时调整任务顺序,无需等待。

+

+

+

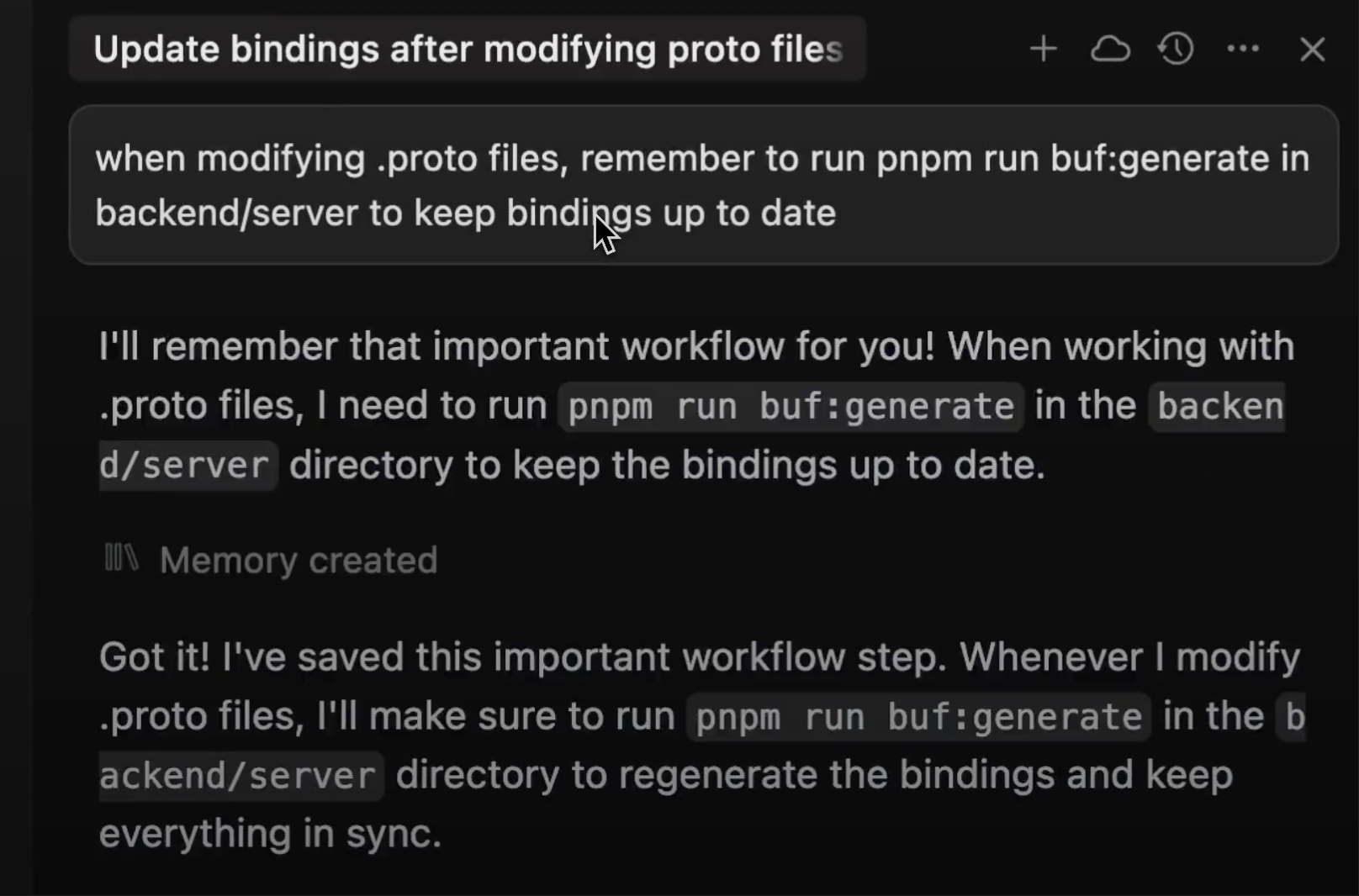

+### 记忆(正式发布)

+

+自 1.0 版本以来,我们提升了记忆内容的生成质量,优化了编辑器中的界面,并加入了“用户审核”机制,以确保由后台生成的记忆信息值得信赖。

+

+

+

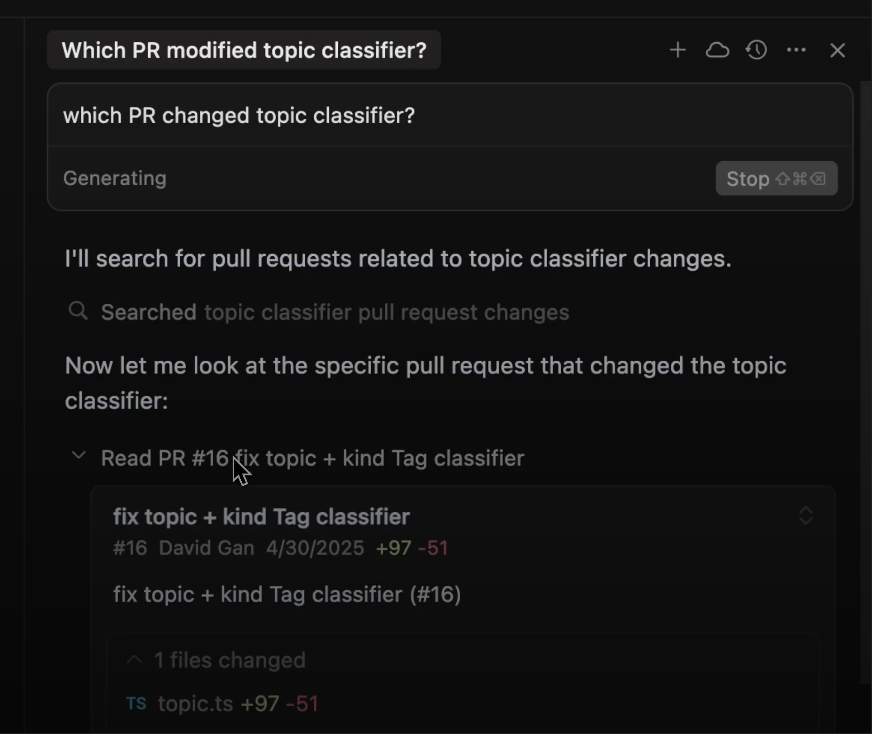

+### PR 索引与搜索

+

+Cursor 会像处理文件一样对 PR 进行索引与摘要。可用语义搜索查找旧的 PR,或显式地将某个 PR、Issue、提交记录或分支添加到当前上下文中。

+

+

+

+相关的 GitHub 评论、BugBot 审查信息和 Slack 中的Agent支持内容也会一并整合进来,让事故分析和问题追踪更迅速。

+

+### 更强的语义搜索嵌入

+

+更新了嵌入模型,使代码库的语义搜索更加准确。同时也重新优化了提示词,使搜索结果更清晰、更加聚焦。

+

+

+

+### 更快的 Tab 补全

+

+Tab 补全现在速度提升了约 100 毫秒,首字节时间(TTFT)缩短了 30%。这得益于我们对内存管理系统的重构和数据传输路径的优化。

+

+

+

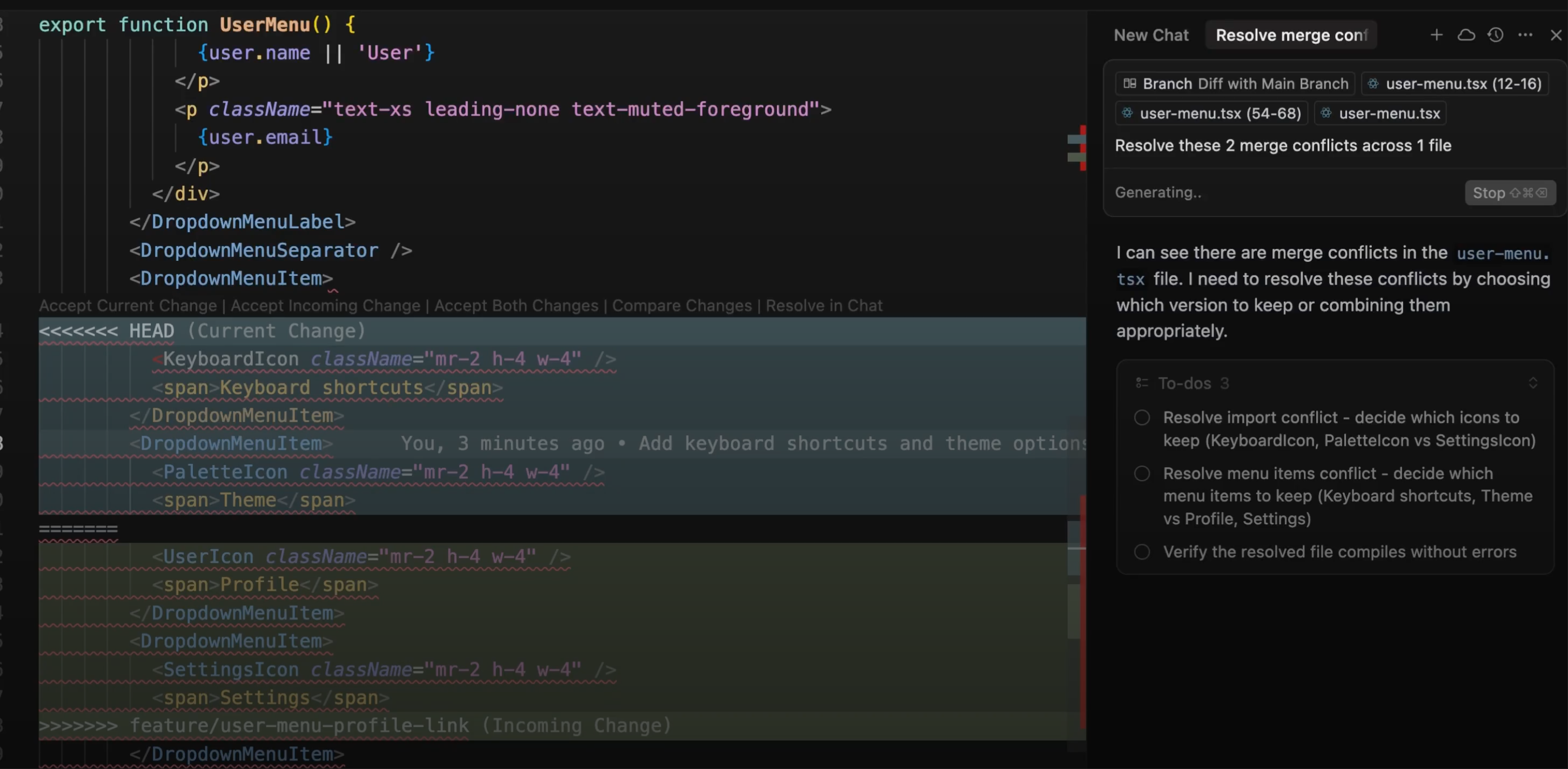

+### 让Agent处理合并冲突

+

+遇到合并冲突时,Agent可尝试自动解决。点击 *在对话中解决*,相关上下文就会自动加载进来,协助解决冲突。

+

+

+

+### 后台Agent功能增强

+

+后台Agent变得更加稳定、可预期,具体改进包括:

+

+- 提交请求(PR)遵循你团队的模板

+- 自动拉取Agent分支的更新

+- 遇到冲突(如 rebase)会自动生成可操作的后续任务

+- 可以直接从侧边栏提交更改

+- 来自 Slack 或网页的深度链接会自动打开相关仓库,即使你本地未打开它

+

+### 改进

+

+- VS Code 升级到 1.99 版本

+- 插件现托管在 Open VSC

+- “提交更改”集成进界面

+- 后台Agent更好地遵循团队的 PR 模板,合并操作更稳定

+

+### 问题修复

+

+- 使用限制错误信息现在更加清晰,并能显示具体范围

+

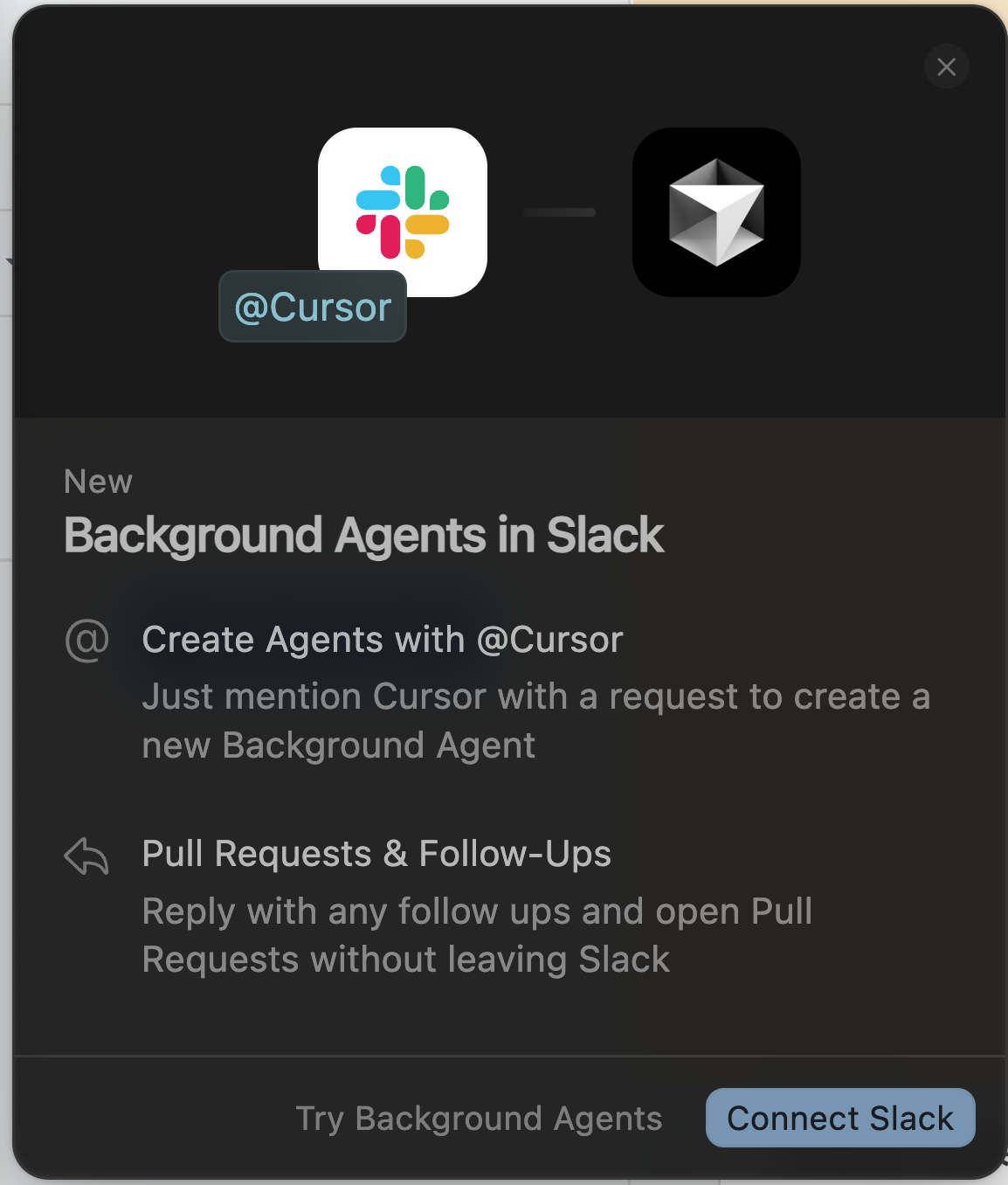

+## 1.1-Slack 中的后台Agent

+

+### 启用后台Agent(Background Agents)

+

+后台Agent在云端运行,允许Agent在你的代码库中异步执行任务。

+

+启用此功能有一些重要的安全注意事项。建议查阅我们的文档了解更多详情。

+

+

+

+

+

+

+

+

+

+现可直接在 Slack 中通过 @Cursor 启动后台Agent。Agent会读取整个对话线程,理解上下文,并直接在 GitHub 上创建 PR,全程无需离开 Slack。

+

+### 在团队协作中使用 Cursor

+

+只需在 Slack 线程中提到 **@Cursor** 并输入你的指令,例如:

+

+

+

+Agent会在安全的远程环境中运行,并将进展直接通过 Slack 通知你,包括跳转链接至 Cursor 和 GitHub。

+

+### Agent理解上下文

+

+Cursor 会在开始前阅读整个 Slack 线程,这样在引用之前的讨论或问题时,后台Agent可完整理解上下文。

+

+

+

+也可让 Cursor 帮你排查问题并返回结果:

+

+

+

+### 快速开始

+

+要在 Slack 中使用后台Agent,需要管理员先完成集成设置。请查阅我们的[设置文档](https://docs.cursor.com/slack),或让你的管理员通过 [控制台 → 集成](https://cursor.com/dashboard?tab=integrations) 页面连接 Cursor。

+

+连接成功后,在任意频道使用 **@Cursor** 并输入提示词即可。输入 `help` 查看所有命令,或用 `settings` 配置默认模型、代码库和分支。

+

+设置中支持 `Cmd/Ctrl+F` 搜索:

+

+- 服务器进度通知

+- 动态工具注册

+- Roots 支持

+

+**1.1.3**

+

+- 增加 PR 搜索和索引功能

+- 支持更换上游市场服务商

+

+

+ ## 1.0-BugBot、后台Agent全面开放、MCP 一键安装

+

+2025年6月4日

+

+本次更新带来了代码审查助手 BugBot、记忆功能初探、一键配置 MCP、Jupyter 支持,以及后台Agent的全面开放。

+

+### BugBot 自动代码审查

+

+BugBot 会自动审查你的 PR,发现潜在错误或问题。

+

+一旦发现问题,BugBot 会在 GitHub 的 PR 页面留言。点击“***在 Cursor 中修复***”,即可跳转回编辑器,自动填写修复提示。

+

+设置方式请参考 [BugBot 使用文档](https://docs.cursor.com/bugbot)。

+

+

+

+### 后台Agent全面开放

+

+所有用户都可以立即使用后台Agent!点击聊天界面的云朵图标或按下 `Cmd/Ctrl+E` 即可启动(关闭隐私模式的用户)。开启隐私模式的用户也将在不久后获得相应功能。

+

+

+

+### Jupyter Notebook 支持Agent

+

+Cursor 现在支持在 Jupyter Notebook 中直接进行编辑!

+

+Agent可以在 Jupyter 中创建和编辑多个代码单元,非常适合科研与数据科学任务。目前仅支持 Sonnet 模型。

+

+

+

+### 记忆功能(Memories)

+

+Cursor现可记住你对话中的关键信息,并在未来引用。这些记忆是基于项目的,用户可以在“设置”中进行管理。

+

+该功能目前为测试版,可前往“设置 → 规则”中开启。

+

+

+

+### MCP一键安装与 OAuth 支持

+

+现可一键安装 MCP 服务,并支持 OAuth 认证,极大简化配置流程。

+

+[docs.cursor.com/tools](https://docs.cursor.com/tools) 页面整理了可用的 MCP 服务列表。

+

+开发者还可以通过 [deeplinks 生成器](https://docs.cursor.com/deeplinks) 添加“添加至 Cursor”按钮到文档或 README 中。

+

+

+

+### 更丰富的聊天回复

+

+Cursor 聊天中现在支持可视化渲染,包括 Mermaid 图表与 Markdown 表格。

+

+

+

+### 全新设置与控制台界面

+

+设置页和控制台界面迎来视觉更新。

+

+可查看个人或团队的使用统计、修改显示名称,以及按工具或模型查看详细分析。

+

+

+

+

+

+- `Cmd/Ctrl+E` 打开后台Agent控制面板

+- `@Link` 与网页搜索支持 PDF 并纳入上下文

+- 设置中新增网络诊断功能

+- 多工具并行调用提升响应速度

+- 聊天工具调用支持折叠

+- 企业用户仅可访问稳定版本

+- 团队管理员可关闭隐私模式

+- 提供 [团队管理 API](https://docs.cursor.com/account/teams/admin-api) 获取使用与消费数据

+- Gemini 2.5 Flash 支持 Max 模式

+

+## 0.50-简化定价、后台Agent、新版 Inline Edit

+

+统一的请求计费模式,所有顶级模型均可用 Max 模式;上线后台Agent功能,支持多任务并行执行。新增 `@folders` 支持、更快的文件编辑、多根工作区支持及更强大的聊天功能如导出与复制。

+

+### 更简单的统一计费

+

+简化原本复杂的定价结构:

+

+- 所有模型均按请求计费

+- Max 模式按 token 计费(类似模型 API 计费)

+- 去除高级工具调用与长上下文模式,简化体验

+

+各版本(Hobby、Pro、Business)配额不变,慢速请求仍包含在套餐内。所有使用情况可在 [控制台](https://cursor.com/dashboard) 查看。

+

+### Max模式全面开放

+

+极致模式现已支持 Cursor 中所有最先进模型,并采用更简洁的token定价模型。该模式旨在让你在最需要时获得完全控制权。你可从模型选择器中启用该模式,查看哪些模型支持该模式。新模型推出后,我们将从第一天起就通过极致模式充分发挥其功能。

+

+当你需要更多:

+

+- 上下文信息

+

+- 智能分析

+- 工具使用时

+

+它是解决最棘手问题的理想选择。对于其他所有问题,仍建议用正常模式,并保持习惯的功能。定价很简单:根据令牌使用量收费。如果您使用过任何基于命令行的编程工具,那么 Max 模式的感觉会类似——只不过是在 Cursor 中。

+

+注意:如果您使用的是旧版 Cursor,您仍然可以在几周内使用之前的 MAX 版本和长上下文模式。但是,这些功能即将停用,因此我们建议您更新以继续使用这些功能。

+

+更多说明见 [Max 模式文档](https://docs.cursor.com/context/max-mode)

+

+

+

+### 新tab模型

+

+训练了一个新 Tab 模型,可跨多个文件提供修改建议。该模型尤其擅长重构、编辑链、多文件修改以及在相关代码之间跳转。

+

+在完成建议中添加语法突出显示:

+

+

+

+### 后台Agent预览

+

+早期预览版正在逐步推出:光标Agent现在可以在后台运行!要试用,请前往“设置”>“测试版”>“后台Agent”。Settings > Beta > Background Agent.

+

+这允许您并行运行多个Agent,并让它们处理更大的任务。这些Agent在各自的远程环境中运行。您可以随时查看状态、发送跟进或接管。

+

+[docs.cursor.com/background-agent](https://docs.cursor.com/background-agent)。

+

+

+

+### 将整个代码库加入上下文

+

+可用 `@folders` 将整个代码库添加到上下文。设置中启用“完整文件夹内容”。若某文件夹或文件太大无法完整加载,会在上下文标签上显示一个小图标提示。

+

+

+

+### 全新 Inline Edit(Cmd/Ctrl+K)集成Agent功能

+

+Inline Edit(Cmd/Ctrl+K)界面焕然一新,新增功能:

+

+- **全文件编辑**(⌘⇧⏎):可对整个文件进行结构性修改,无需调用Agent

+- **发送至Agent**(⌘L):当你需要对多个文件进行修改,或希望由Agent接手复杂逻辑时,可将代码块发送给Agent继续编辑

+

+### Refreshed Inline Edit (Cmd/Ctrl+K) with Agent integration

+

+Inline Edit (Cmd/Ctrl+K) has gotten a UI refresh and new options for full file edits (⌘⇧⏎) and sending to agent (⌘L)

+

+Full file makes it easy to do scope changes to a file without using agent. However, you might come across cases where you're working with a piece of code you want to make multi-file edits to or simply just want more control you can get from agent. That's when you want to send selected codeblock to agent and keep on editing from there.

+

+

+

+### 快速编辑长文件(使用Agent)

+

+Agent新增“查找并替换”工具,使其在编辑大型文件时更高效。无需读取整个文件,Agent现在可以精准定位修改位置,只编辑需要的部分。

+

+在 [Postgres 项目代码](https://github.com/postgres/postgres/blob/master/src/backend/tcop/postgres.c) 中,该工具的编辑速度几乎快一倍。

+

+该功能率先支持 Anthropic 模型。

+

+

+

+### 多代码库(codebases)工作区(workspaces)支持

+

+现可创建多根目录的工作区(multi-root workspace),让多个项目同时可用于 Cursor。

+

+所有工作区内的内容都会被索引并可调用,适合在多个项目文件夹中协作。

+

+所有添加的文件夹都支持 `.cursor/rules` 配置。

+

+多根目录工作区:

+

+

+

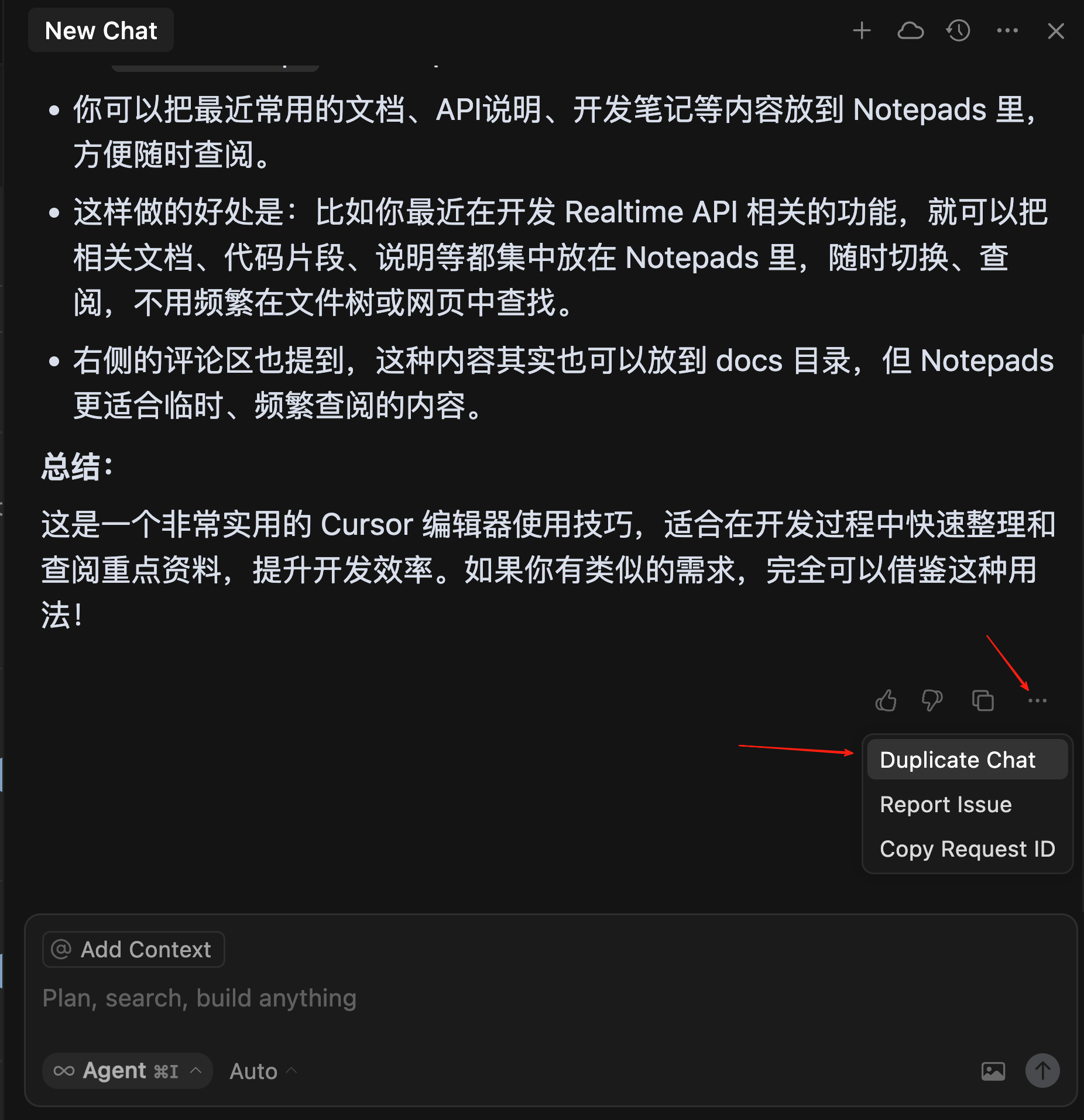

+#### 聊天导出

+

+可将聊天记录导出 Markdown 文件,包含文本和代码块内容,便于保存或分享。

+

+

+

+#### 聊天复制

+

+可复制一段聊天记录并开启新对话,探索不同方向的讨论,同时保留原内容。

+

+在某条消息右上角点击“三点菜单”,选择“复制聊天”即可。

+

+

+

+使用 `Cmd/Ctrl+Shift+Enter` 快速进行整个文件编辑

+

+- Inline Edit 中的全文件编辑快捷键: `Cmd/Ctrl+Shift+K`

+

+- Agent现在使用原生终端仿真(非模拟终端)

+- `@folders` 尽量加载所有可纳入上下文的文件

+- 聊天中新增图标,指示文件是否被完整加载或被压缩

+- MCP 工具现可单独禁用(在 MCP 设置中)

+- 市场新增 C# 扩展插件

+- 聊天字体大小可在设置调节

+- 应用内提供详细更新日志页面

+

+### MCP 功能增强

+

+- 远程工作区(WSL、Remote SSH)支持运行 stdio

+- 支持流式 HTTP

+

+> 注:Claude 3 Opus 不再提供每天 10 次的免费请求额度

+

+**0.50.1**

+

+- 启用后台Agent(Background Agent)功能

+

+

+

+**0.50.2**

+

+- 修复与 ZScaler VPN 的兼容问题

+

+**0.50.4**

+

+- 增强多根目录工作区支持

+

+## 0.49.x 版本更新:规则生成、Agent终端优化、MCP 图片支持等

+

+2025 年 4 月 15 日

+

+------

+

+### 1 自动生成和优化的规则

+

+现可通过命令:

+

+```bash

+/Generate Cursor Rules

+```

+

+##### 直接在对话中生成规则。

+

+时机:希望保留当前对话上下文,以便后续复用。

+

+对于设置了路径模式的 `Auto Attached`(自动附加)规则,Agent现可在读写文件时自动应用正确的规则。

+

+修复问题:`Always`(始终附加)规则现可在更长对话中持续生效。Agent现也可更稳定编辑规则。

+

+

+

+### 2 更便捷的聊天记录访问方式

+

+聊天记录现已整合到命令面板。可通过聊天界面中的 “显示历史” 按钮或使用 `Show Chat History` 命令来查看记录。

+

+

+

+### 3 更轻松的代码审查体验

+

+对话末尾会显示一个内置的差异视图,方便审查Agent生成的代码。每当Agent回复后,可点击底部 `Review changes` 按钮查看改动。

+

+

+

+### MCP 支持图片上下文

+

+你现在可以在 MCP 服务器中传入图片作为上下文内容。当你需要引用截图、UI 草图或图示来补充问题时,这会非常有帮助。

+

+

+

+### Agent终端控制能力提升

+

+对agent启动的终端有更多控制权。命令可在执行前编辑,也可选择跳过执行。

+

+将“弹出窗口(Pop-out)”重命名为“后台运行(Move to background)”,以更准确地反映其作用。

+

+

+

+### 全局忽略文件功能

+

+现可通过用户级设置,定义全局忽略文件规则([global ignore](https://docs.cursor.com/context/ignore-files)),这些规则适用于所有项目。

+

+避免将构建输出、密钥等干扰性或敏感文件纳入prompts,无需为每个项目单独设置。

+

+

+

+### 新增模型

+

+新增模型,可试用 Gemini 2.5 Pro、Gemini 2.5 Flash、Grok 3、Grok 3 Mini、GPT-4.1、o3及o4-mini:

+

+

+

+### 项目结构上下文(Beta)

+

+新功能:将项目结构纳入上下文。

+

+好处:将你的目录结构加入prompt,使agent更好理解项目组织方式,在大型或嵌套 monorepo 项目中提供更准确的建议和导航。

+

+### 快捷键更新

+

+部分 `CMD+K` 快捷键现在可自定义修改

+

+### 界面与功能优化

+

+- Tab 跳转建议界面更新,超出视窗的建议现在也可点击

+- 聊天界面新增模式工具提示

+- 支持通过访问密钥连接 AWS Bedrock

+- Git 中的 `@PR` 功能更名为 `@Branch`

+

+### 错误修复

+

+- “始终附加”规则在总结对话中也能正确保留

+- `.mdc` 文件中的规则现在可由Agent无障碍创建和编辑

+- 修复了 `@mention` 节点在输入框起始位置时的选择问题

+

+### 面向企业和团队的新功能

+

+**全局忽略规则向上查找**

+

+现支持向上遍历目录查找忽略文件(默认关闭,可在管理员设置中开启)

+

+**支持 AWS Bedrock IAM 角色连接**

+

+企业用户现可通过 IAM 角色连接 AWS Bedrock

+

+**用户级使用情况洞察**

+

+管理员可在控制台中查看每位用户的使用和快速请求情况

+

+**团队自动运行控制**

+

+管理员可在控制台中设置全局 MCP 行为

+

+### 补丁更新

+

+**0.49.1**

+

+- 点规则不再在未超出长度限制时错误显示“超长”警告

+

## 0.48.x-聊天标签、自定义模式 & 更快的索引

引入**聊天标签**,支持并行对话,并重新设计**模式系统**,允许添加自定义模式。

diff --git a/docs/md/AI/agent/cline.md b/docs/md/AI/agent/cline.md

new file mode 100644

index 0000000000..f6c2237a75

--- /dev/null

+++ b/docs/md/AI/agent/cline.md

@@ -0,0 +1,125 @@

+# 掌控AI编程全链路:Cline让你随意选模型、透明成本、零信任安全

+

+## 0 坚定开源 AI 编程,毫不妥协!

+

+了解每一次决策。随意选择模型。掌控成本。Cline 为你提供直接、透明的前沿 AI 访问,无限制、无意外,也不存在被锁定在特定模型生态系统中的风险。

+

+## 1 Cline探索 → 规划 → 执行

+

+### 1.1 Plan Mode for复杂任务

+

+Cline 会先扫描你的代码库,并与你共同制定完整的实现计划,确保在动手写任何代码之前,就已经全面理解项目上下文。

+

+### 1.2 完全透明

+

+实时观看 Cline 打开文件、思考方案并提出修改建议。每一次决策都可见,每一次编辑都可以在提交前审阅。

+

+### 1.3 你的模型,你的控制权

+

+需要复杂推理时使用 Claude,处理大规模上下文时选用 Gemini,追求效率时选择 Kimi K2。新模型一旦发布即可即时切换,API 密钥由你自行管理。

+

+## 2 瞥见 Cline 不断扩展的工具箱

+

+为实际工程而生!

+

+### 2.1 .clinerules

+

+定义项目专属指令,让 Cline 遵循编码规范、架构模式或团队约定,从而生成一致且合规的代码。

+

+### 2.2 MCP Integration

+

+通过MCP连接数据库、API 与文档。Cline 成为你通往所有外部系统的桥梁。

+

+### 2.3 Context Intelligence

+

+进度条会实时显示 Cline 正在使用多少上下文资源。没有隐藏的 Token 限制,也不会出现意外截断,所有资源消耗一目了然。

+

+### 2.4 终端掌控

+

+Cline 可以直接在你的终端执行命令、读取输出并调试错误。它就像一个永远记得语法的搭档,与你进行配对编程。

+

+## 3 唯一通过合规审查的 AI 编程智能体

+

+- [SOC 2 Compliant(Q2 2025)](https://trust.cline.bot/)

+- [GDPR Ready(Q2 2025)](https://trust.cline.bot/)

+

+### 3.1 零信任设计

+

+你的代码永远不触及我们的服务器。Cline 完全在客户端运行,使用你自己的 API 密钥,是满足严格安全要求的唯一选择。

+

+### 3.2 全面审计

+

+开源意味着你的安全团队可以审查每一行代码。精准了解 Cline 的工作方式、向 AI 提供商发送了哪些信息以及决策是如何产生的。

+

+### 3.3 为团队而建

+

+无论是初创企业还是《财富》500 强,Cline Teams 都提供集中计费、使用分析与席位管理,同时保持企业所需的安全架构。

+

+## 4 为啥开发者选择 Cline

+

+我们相信 AI 编程应该放大人的能力,而不是掩盖它。所有设计决策都体现了这一承诺。

+

+### 4.1 100% 开源

+

+代码全部托管在 GitHub 上,已有 48k ⭐(且仍在增长),来自阅读、改进并信任这些代码的开发者们。

+

+### 4.2 不玩推理游戏

+

+### 4.3 设计即面向未来

+

+有新模型发布?立刻使用。Cline 支持任何 AI 提供商和任何模型,让你永远不会被旧技术锁定。

+

+### 4.4 完全可视化

+

+不仅是「可解释 AI」(Explainable AI),而是彻底透明。每一次文件读取、每一个决策、每一枚 Token 的使用,都清晰可见。

+

+## 5 我们的设计原则

+

+**北极星(North Star)**:始终打造最优秀的编码智能体,让你的最佳结果即是我们的最佳结果。

+

+### 5.1 开源万物

+

+我们不能隐藏降级、偷工减料或隐匿决策。每一行代码都可以审计。透明不是一个功能,而是架构层面的必然。

+

+### 5.2 不靠推理获利

+

+我们的成功取决于 Cline 功能更强大,而非设法削减你的成本。推理权在你手,唯一的盈利途径是交付被企业客户广泛采用的优质软件。

+

+### 5.3 通用模型访问

+

+今天最好的模型可能来自 Anthropic;明天的模型或许出自尚未成立的实验室。Cline 能即时使用任何模型,不设创新门槛。

+

+### 5.4 只使用你的基础设施

+

+客户端架构意味着你的代码永远不触及我们的服务器。这对安全至关重要,也是众多企业的必备要求,确保真正的数据主权。

+

+**结果**:每一个激励、每一行代码、每一次架构决策都指向同一个目标——让最大能力掌握在你手中。我们只能以此方式成功。

+

+## 6 FAQ

+

+### Cline费用多少?

+

+Cline本身免费且开源。你只需为所使用的 AI 模型付费,按照你选定提供商的实际价格结算,没有加价、没有订阅,也不会有意外费用。

+

+### 代码在用 Cline 时安全吗?

+

+是的。Cline 完全运行在本机上,并直接使用你的 API 密钥。你的代码永远不经过我们的服务器。这种客户端架构正是注重安全的企业选择 Cline 的原因。

+

+### Cline 与 GitHub Copilot 或 Cursor 相比如何?

+

+与自动补全工具不同,Cline 是一个真正的编码智能体,能够理解完整的代码库、规划复杂修改并执行多步骤任务。与订阅服务不同,你可完全控制使用哪种 AI 模型以及花费多少。

+

+### 哪些 AI 模型最适合配合 Cline 使用?

+

+Cline 对模型没有限制。可选:

+

+- Claude 3.5 Sonnet(Claude 3.5 Sonnet)进行复杂推理

+- Gemini 2.5 Pro(Gemini 2.5 Pro)处理超大上下文窗口

+- DeepSeek(DeepSeek)追求成本效率

+- 或在新模型发布后立即使用

+

+很多用户会组合不同模型:高价模型用于规划,低价模型用于执行。

+

+### 可在企业内部使用 Cline 吗?

+

+可以。Cline 的架构(客户端、自带密钥 BYOK、开源)非常适合企业使用。我们提供 Cline Teams,以实现集中计费和管理。已有众多《财富》500 强公司采用 Cline,因为它是唯一满足其合规要求的 AI 编码工具。

\ No newline at end of file

diff --git a/docs/md/AI/llm/configuring-models-in-dify.md b/docs/md/AI/agent/configuring-models-in-dify.md

similarity index 100%

rename from docs/md/AI/llm/configuring-models-in-dify.md

rename to docs/md/AI/agent/configuring-models-in-dify.md

diff --git a/docs/md/AI/llm/dify-agent-and-zapier-mcp-unlock-ai-automation.md b/docs/md/AI/agent/dify-agent-and-zapier-mcp-unlock-ai-automation.md

similarity index 100%

rename from docs/md/AI/llm/dify-agent-and-zapier-mcp-unlock-ai-automation.md

rename to docs/md/AI/agent/dify-agent-and-zapier-mcp-unlock-ai-automation.md

diff --git a/docs/md/AI/llm/dify-deep-research-workflow-farewell-to-fragmented-search-unlock-ai-driven-insights.md b/docs/md/AI/agent/dify-deep-research-workflow-farewell-to-fragmented-search-unlock-ai-driven-insights.md

similarity index 100%

rename from docs/md/AI/llm/dify-deep-research-workflow-farewell-to-fragmented-search-unlock-ai-driven-insights.md

rename to docs/md/AI/agent/dify-deep-research-workflow-farewell-to-fragmented-search-unlock-ai-driven-insights.md

diff --git a/docs/md/AI/llm/dify-v1-0-building-a-vibrant-plugin-ecosystem.md b/docs/md/AI/agent/dify-v1-0-building-a-vibrant-plugin-ecosystem.md

similarity index 100%

rename from docs/md/AI/llm/dify-v1-0-building-a-vibrant-plugin-ecosystem.md

rename to docs/md/AI/agent/dify-v1-0-building-a-vibrant-plugin-ecosystem.md

diff --git a/docs/md/AI/agent/dify-v1-1-0-filtering-knowledge-retrieval-with-customized-metadata.md b/docs/md/AI/agent/dify-v1-1-0-filtering-knowledge-retrieval-with-customized-metadata.md

new file mode 100644

index 0000000000..e69de29bb2

diff --git a/docs/md/AI/agent/kiro.md b/docs/md/AI/agent/kiro.md

new file mode 100644

index 0000000000..302e57d98d

--- /dev/null

+++ b/docs/md/AI/agent/kiro.md

@@ -0,0 +1,544 @@

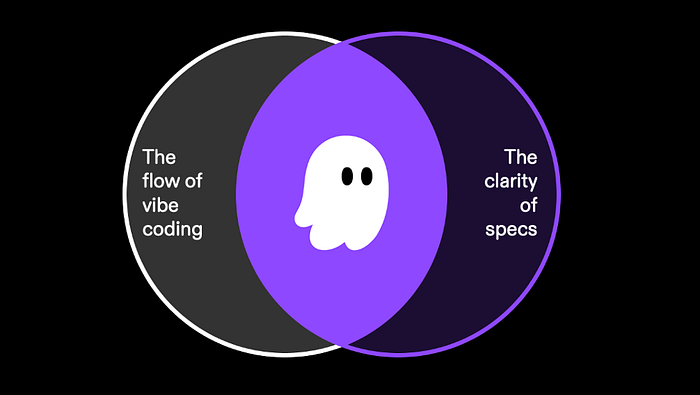

+# 告别Vibe编程:Kiro让你的代码一次成型!

+

+## 0 前言

+

+Kiro,一个专为 vibe coding 应用带来结构的 IDE,默认内置规范驱动开发。

+

+Amazon 刚发布 [Kiro IDE](https://kiro.dev/)。这是他们自己的开发平台,专为 vibe coding 应用带来结构而设计,默认内置规范驱动开发。

+

+这个想法是为了让 vibe coding 应用更易进入生产环境——这是大多数 vibe coding 平台目前仍难解决的问题。

+

+但真正让我对这个新 IDE 感兴趣的是:Kiro 由 Claude 4 Sonnet 驱动。

+

+Anthropic 的 Claude 4 Sonnet 和 Opus 基本上是当前 AI 模型的佼佼者。将它们内置到 Kiro 中对于 vibe coder 来说非常有趣。它本质上会自动将软件工程最佳实践应用到 vibe-coding 工作流程中,帮助为应用开发带来结构和更有组织的方法。

+

+看看有啥特殊功能。

+

+## 1 啥是 Kiro?

+

+一个 AI 驱动的 IDE,专为"vibe coding"而设计,但远不止于此。优势在于通过规范和钩子等功能将这些原型转化为生产系统。

+

+Kiro 规范和钩子:

+

+

+

+- **Kiro 规范**,助你更好规划和理解你的应用。对于思考功能、重构和澄清系统行为很有用。还指导 AI 代理做出更智能的实现决策。

+- **Kiro 钩子**,就像有个高级开发在背后看着你。它们在后台自动化任务,如处理样板代码或在你保存、创建或删除文件时捕获问题或手动触发它们。

+

+Kiro将单个提示转化为完整功能的规范、技术设计和任务分解来简化开发。如输入"添加评论系统"会生成具有边缘情况覆盖的用户故事,然后自动构建包括数据流、API 和数据库模式的设计文档。

+

+

+

+它还会创建一个考虑单元测试、响应性和可访问性的序列化任务列表。

+

+Design documentation in Kiro specs:

+

+

+

+构建时,钩子就像一个同行开发者——自动化诸如测试文件更新、刷新文档、扫描问题和执行代码标准等事情。一旦设置,钩子会在文件事件(如保存或提交)时运行,帮助团队以最少的努力维护质量和一致性。

+

+Kiro 还支持 MCP 和自主代理,所以它在 vibe coding 场景中并不感觉像新手。感觉比 Cursor 或 Windsurf 更先进,因为 Amazon 在这个 IDE 中打包了所有功能。

+

+## 2 安装Kiro

+

+前往 [kiro.dev](https://kiro.dev/downloads/) 并根据硬件和操作系统下载安装文件:

+

+

+

+下载完成后,在你的系统上安装应用程序并启动它。这是初始仪表板的样子。

+

+

+

+有多种方式可以登录 Kiro,但建议用 AWS 账户。由于 Kiro 可能最终会更深地集成到 AWS 工具中,提前链接你的账户可能会让以后的事情更易。

+

+Kiro 建立在 VS Code 之上,可立即导入现有的配置:

+

+

+

+建议在终端中设置 Kiro。这会将 Kiro 添加到你的系统 PATH 中,允许你从终端全局打开它,而不必每次都从应用程序文件夹中查找。

+

+

+

+用户界面仍然感觉很像 VS Code,只是有一些视觉调整来匹配 Amazon 的颜色主题。

+

+

+

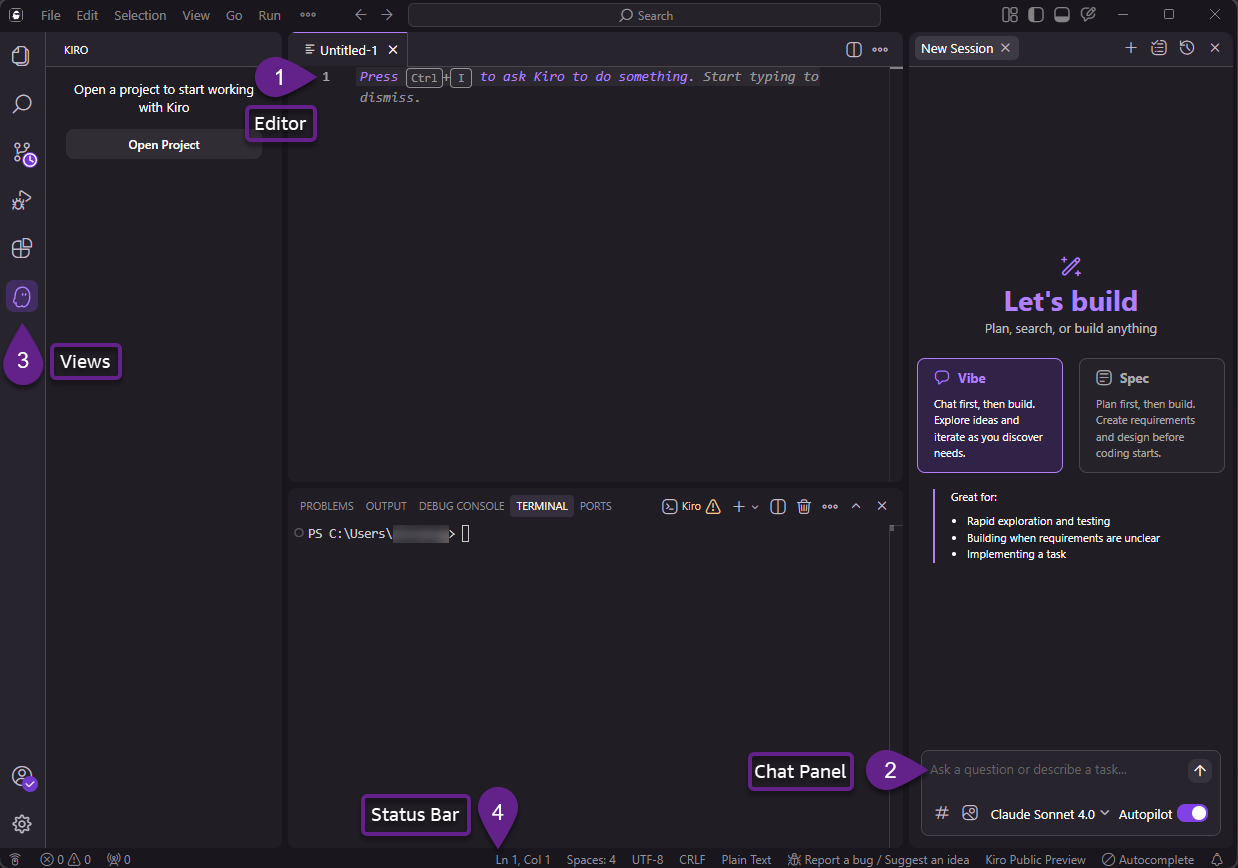

+Kiro IDE界面功能:

+

+

+

+### 编辑器

+

+代码编写和编辑的核心工作区。功能包括:

+

+- 多种语言的语法高亮

+- 行号和错误指示器

+- 代码折叠以便更好地组织

+- 多个标签页用于跨文件工作

+- 分屏视图支持并排编辑

+

+### 聊天面板

+

+你可以使用聊天面板来:

+

+- 询问有关代码的问题

+- 请求代码生成或修改

+- 获得调试和故障排除帮助

+- 请求代码审查和优化建议

+- 使用 # 命令包含上下文(例如,#File、#Folder)

+- 生成样板代码和模板

+

+要将聊天面板移动到IDE的另一侧:

+

+在顶部菜单栏中,选择 视图 > 外观 > 将主侧边栏移到右侧。

+

+### 视图

+

+侧边栏包含几个专门的视图:

+

+- **资源管理器** - 导航项目文件结构,查看Git状态指示器,并访问规范和MCP服务器的特殊部分。

+

+- **搜索** - 在整个项目中执行全局搜索和替换操作。

+

+- **源代码管理** - 管理Git操作,查看更改并处理提交。

+

+- **运行和调试** - 在调试会话期间查看变量、调用堆栈和管理断点。

+

+- **扩展** - 安装和管理IDE扩展。

+

+- **Kiro** - AI特定功能的专用视图:

+ - 规范概览和管理

+ - 代理钩子管理

+ - 代理指导配置

+ - MCP服务器

+

+### 状态栏

+

+位于界面底部,状态栏提供:

+

+- 当前文件信息

+- Git分支和同步状态

+- 错误和警告计数

+- 代理状态指示器

+

+### 命令面板

+

+通过按 Cmd+Shift+P(Mac)或 Ctrl+Shift+P(Windows/Linux)快速访问Kiro的命令来:

+

+- 执行常见操作

+- 访问MCP工具

+- 配置设置

+- 运行代理钩子

+

+### 导航技巧

+

+- 使用键盘快捷键进行更快的导航

+- 利用命令面板快速访问功能

+- 固定常用文件以便轻松访问

+- 使用分屏视图比较或引用代码

+- 配置工作区设置以获得个性化体验

+

+## 3 Kiro 如何工作

+

+规范驱动开发保持 vibe coding 的速度和创造力,但添加了通常缺失的结构。

+

+纯 vibe coding 的最大问题之一是它需要太多的来回交流,特别是在处理复杂功能或大型代码库时。AI 易失去上下文或误解你提示背后的意图。Kiro 通过在编写任何代码之前从规范开始来解决这个问题。

+

+打开一个项目并点击 Kiro 标签。在右侧面板上,你会看到一个聊天界面,可在"Vibe"或"Spec"之间选择。选择 Spec,然后开始描述你希望 AI 处理的任务。

+

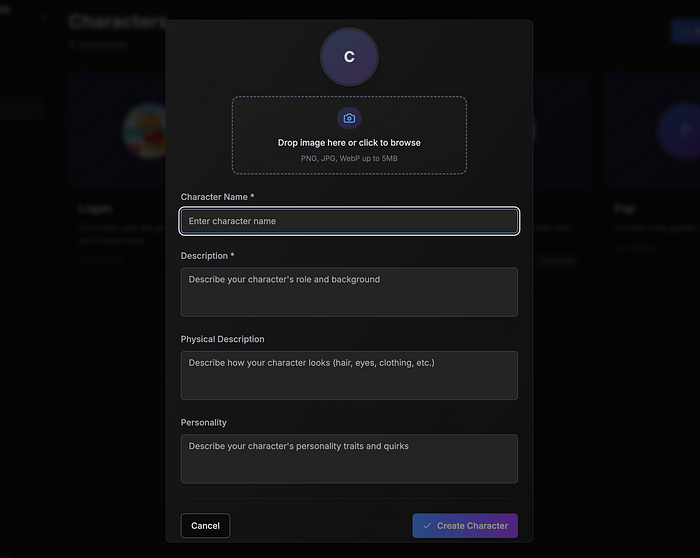

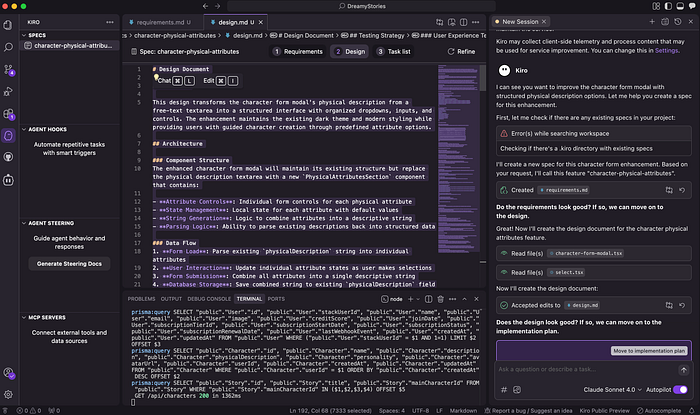

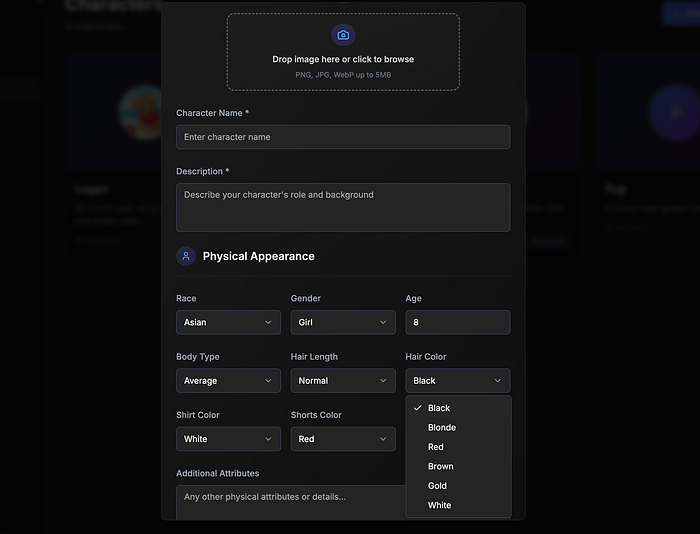

+在我的情况下,我有一个想要升级的角色创建页面。当前的设置只是使用纯文本字段进行物理描述。我想用开关和下拉菜单替换它,为用户提供更视觉化和结构化的输入方法。

+

+

+

+发送给 Kiro 的完整提示:

+

+```vbnet

+In the #character-form-modal.tsx can you help me improve the way the user sets the physical description of the character?

+Instead of simple text description, I want to show toggles and dropdowns. Here are the selectable menus:

+- Race: Asian (default), White, Black, Hispanic

+- Gender: Boy, Girl (default)

+- Age: (must be a number between 1–100, default at 8)

+- Body: Slim, average (default), chubby

+- Hair length: Short, normal (default), long

+- Hair color: Black (default), blonde, red, brown, gold, white

+- Shirt color: red, blue, yellow, pink, black, white (default)

+- Short color: red (default), blue, yellow, pink, black, white

+- Shoes color: red, blue (default), yellow, pink, black, white

+- Others: a text field for other physical attributes

+Organize the components in the modal screen with a nice and modern look and feel.

+When the user clicks on the "Create Character" or "Update Character" button, combine all the physical attributes into a single string and save it to the database.

+```

+

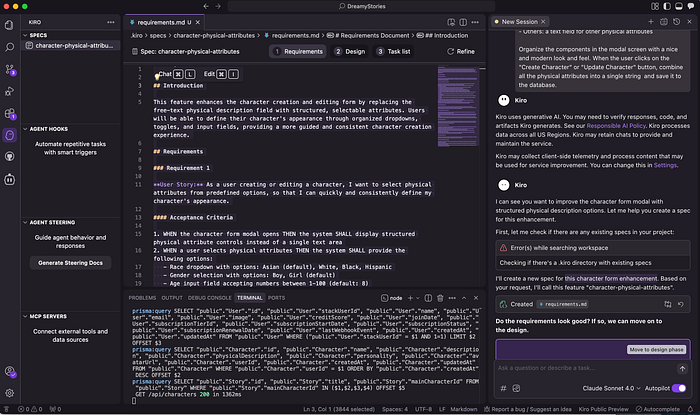

+Kiro 做的第一件事是为功能增强创建规范表。它被保存在仪表板的规范部分下,格式为 markdown。

+

+

+

+以下是规范表的内容:

+

+```vbnet

+## Introduction

+

+This feature enhances the character creation and editing form by replacing the free-text physical description field with structured, selectable attributes. Users will be able to define their character's appearance through organized dropdowns, toggles, and input fields, providing a more guided and consistent character creation experience.

+

+## Requirements

+

+### Requirement 1

+

+**User Story:** As a user creating or editing a character, I want to select physical attributes from predefined options, so that I can quickly and consistently define my character's appearance.

+

+#### Acceptance Criteria

+

+1. WHEN the character form modal opens THEN the system SHALL display structured physical attribute controls instead of a single text area

+2. WHEN a user selects physical attributes THEN the system SHALL provide the following options:

+ - Race dropdown with options: Asian (default), White, Black, Hispanic

+ - Gender selection with options: Boy, Girl (default)

+ - Age input field accepting numbers between 1-100 (default: 8)

+ - Body type dropdown with options: Slim, Average (default), Chubby

+ - Hair length dropdown with options: Short, Normal (default), Long

+ - Hair color dropdown with options: Black (default), Blonde, Red, Brown, Gold, White

+ - Shirt color dropdown with options: Red, Blue, Yellow, Pink, Black, White (default)

+ - Shorts color dropdown with options: Red (default), Blue, Yellow, Pink, Black, White

+ - Shoes color dropdown with options: Red, Blue (default), Yellow, Pink, Black, White

+ - Others text field for additional physical attributes

+3. WHEN the user submits the form THEN the system SHALL combine all selected physical attributes into a single descriptive string

+4. WHEN the form is submitted THEN the system SHALL save the combined physical description to the database in the existing physicalDescription field

+

+### Requirement 2

+

+**User Story:** As a user editing an existing character, I want the form to pre-populate with the character's current physical attributes, so that I can modify specific aspects without losing existing information.

+

+#### Acceptance Criteria

+

+1. WHEN editing an existing character THEN the system SHALL attempt to parse the existing physicalDescription field

+2. IF the existing description cannot be parsed into structured attributes THEN the system SHALL display default values and preserve the original text in the "Others" field

+3. WHEN the form loads with an existing character THEN the system SHALL pre-select the appropriate dropdown values based on the character's current physical description

+

+### Requirement 3

+

+**User Story:** As a user interacting with the character form, I want the physical attributes section to have a modern and organized layout, so that the form is easy to navigate and visually appealing.

+

+#### Acceptance Criteria

+

+1. WHEN the physical attributes section is displayed THEN the system SHALL organize controls in a logical grid layout

+2. WHEN displaying the physical attributes THEN the system SHALL group related attributes together (e.g., hair attributes, clothing attributes)

+3. WHEN the form is rendered THEN the system SHALL maintain the existing modal styling and dark theme

+4. WHEN the user interacts with the controls THEN the system SHALL provide clear visual feedback and maintain accessibility standards

+

+### Requirement 4

+

+**User Story:** As a user, I want age validation to prevent invalid entries, so that character creation remains consistent and error-free.

+

+#### Acceptance Criteria

+

+1. WHEN a user enters an age value THEN the system SHALL validate that the value is between 1 and 100

+2. IF an invalid age is entered THEN the system SHALL display an error message and prevent form submission

+3. WHEN the age field loses focus with an invalid value THEN the system SHALL reset to the default value of 8

+```

+

+我对计划的详细程度印象深刻。它将任务分解为四个明确的需求,每个都有用户故事和详细的验收标准。它包含了我要求的一切——从 UI 应该如何看起来到年龄验证应该如何行为。它甚至添加了解析和保留旧数据的逻辑。

+

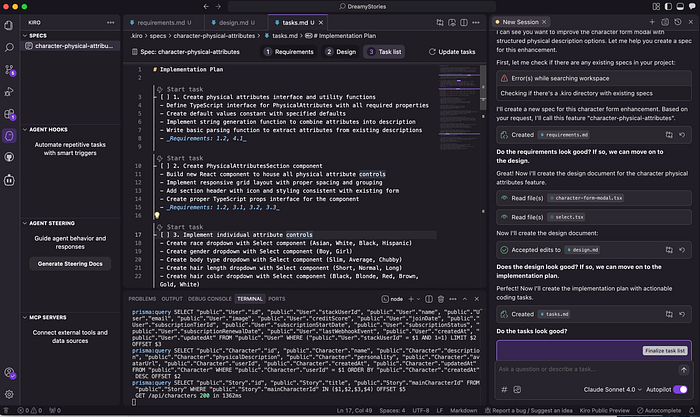

+审查后,我点击了"进入设计阶段"。以下是最终设计文档的样子:

+

+~~~markdown

+# Design Document

+## Overview

+This design transforms the character form modal's physical description from a free-text textarea into a structured interface with organized dropdowns, inputs, and controls. The enhancement maintains the existing dark theme and modern styling while providing users with guided character creation through predefined attribute options.

+## Architecture

+### Component Structure

+The enhanced character form modal will maintain its existing structure but replace the physical description textarea with a new `PhysicalAttributesSection` component that contains:

+- **Attribute Controls**: Individual form controls for each physical attribute

+- **State Management**: Local state for each attribute with default values

+- **String Generation**: Logic to combine attributes into a descriptive string

+- **Parsing Logic**: Ability to parse existing descriptions back into structured data

+### Data Flow

+1. **Form Load**: Parse existing `physicalDescription` string into individual attributes

+2. **User Interaction**: Update individual attribute states as user makes selections

+3. **Form Submission**: Combine all attributes into a single descriptive string

+4. **Database Storage**: Save combined string to existing `physicalDescription` field

+## Components and Interfaces

+### Physical Attributes Interface

+```typescript

+interface PhysicalAttributes {

+ race: 'Asian' | 'White' | 'Black' | 'Hispanic';

+ gender: 'Boy' | 'Girl';

+ age: number;

+ body: 'Slim' | 'Average' | 'Chubby';

+ hairLength: 'Short' | 'Normal' | 'Long';

+ hairColor: 'Black' | 'Blonde' | 'Red' | 'Brown' | 'Gold' | 'White';

+ shirtColor: 'Red' | 'Blue' | 'Yellow' | 'Pink' | 'Black' | 'White';

+ shortsColor: 'Red' | 'Blue' | 'Yellow' | 'Pink' | 'Black' | 'White';

+ shoesColor: 'Red' | 'Blue' | 'Yellow' | 'Pink' | 'Black' | 'White';

+ others: string;

+}

+```

+### Default Values

+```typescript

+const DEFAULT_ATTRIBUTES: PhysicalAttributes = {

+ race: 'Asian',

+ gender: 'Girl',

+ age: 8,

+ body: 'Average',

+ hairLength: 'Normal',

+ hairColor: 'Black',

+ shirtColor: 'White',

+ shortsColor: 'Red',

+ shoesColor: 'Blue',

+ others: ''

+};

+```

+### Layout Design

+#### Grid Organization

+The physical attributes section will use a responsive grid layout:

+```

+┌─────────────────────────────────────────────────────────┐

+│ Physical Appearance │

+├─────────────────────────────────────────────────────────┤

+│ [Race ▼] [Gender ▼] [Age: 8 ] │

+│ │

+│ [Body ▼] [Hair Length ▼] [Hair Color ▼] │

+│ │

+│ [Shirt Color ▼] [Shorts Color ▼] [Shoes Color ▼] │

+│ │

+│ ┌─────────────────────────────────────────────────────┐ │

+│ │ Others: Additional attributes... │ │

+│ │ │ │

+│ └─────────────────────────────────────────────────────┘ │

+└─────────────────────────────────────────────────────────┘

+```

+#### Visual Grouping

+- **Basic Info**: Race, Gender, Age (top row)

+- **Physical Build**: Body type, Hair attributes (middle row)

+- **Clothing**: Shirt, Shorts, Shoes colors (bottom row)

+- **Additional**: Others text field (separate section)

+### Styling Specifications

+#### Section Header

+- Title: "Physical Appearance" with icon

+- Consistent with existing form section styling

+- Subtle border/separator from other sections

+#### Form Controls

+- **Dropdowns**: Use existing Select component with dark theme

+- **Age Input**: Number input with validation styling

+- **Others Field**: Textarea matching existing form styling

+- **Grid**: 3-column responsive layout on larger screens, stacked on mobile

+#### Color Coding

+- Maintain existing color scheme (blue-purple gradients)

+- Use subtle background variations for different attribute groups

+- Error states for invalid age input

+## Data Models

+## Error Handling

+### Age Validation

+- **Range Check**: Validate 1-100 range on input

+- **Type Check**: Ensure numeric input only

+- **Reset Logic**: Auto-reset to default (8) on invalid input

+- **Visual Feedback**: Red border and error message for invalid values

+### Form Submission

+- **Required Fields**: Maintain existing validation for name and description

+- **Attribute Validation**: Ensure all dropdowns have valid selections

+- **Fallback Handling**: If attribute parsing fails, preserve original description

+### Backward Compatibility

+- **Existing Characters**: Parse what's possible, preserve rest in "Others"

+- **Migration Strategy**: No database changes required

+- **Graceful Degradation**: System works with both structured and unstructured descriptions

+## Testing Strategy

+### Unit Tests

+- **String Generation**: Test all attribute combinations produce valid descriptions

+- **Parsing Logic**: Test parsing of various description formats

+- **Validation**: Test age input validation edge cases

+- **Default Values**: Verify correct defaults are applied

+### Integration Tests

+- **Form Submission**: Test complete form flow with new attributes

+- **Character Editing**: Test loading and updating existing characters

+- **API Integration**: Verify data flows correctly to backend

+### Visual Tests

+- **Layout Responsiveness**: Test grid layout on different screen sizes

+- **Theme Consistency**: Verify dark theme styling matches existing components

+- **Accessibility**: Test keyboard navigation and screen reader compatibility

+### User Experience Tests

+- **Form Flow**: Test complete character creation process

+- **Error Handling**: Test validation feedback and error recovery

+- **Performance**: Ensure form remains responsive with new controls

+~~~

+

+

+

+再次花时间审查设计文档,看看 AI 在哪些部分不正确。进行最终更改,然后点击"进入实施计划"按钮。

+

+Kiro 现在将创建实施计划。在我们的示例中,AI 将在源代码中执行12组更改。

+

+```markdown

+# Implementation Plan

+

+- [ ] 1. Create physical attributes interface and utility functions

+ - Define TypeScript interface for PhysicalAttributes with all required properties

+ - Create default values constant with specified defaults

+ - Implement string generation function to combine attributes into description

+ - Write basic parsing function to extract attributes from existing descriptions

+ - _Requirements: 1.2, 4.1_

+

+- [ ] 2. Create PhysicalAttributesSection component

+ - Build new React component to house all physical attribute controls

+ - Implement responsive grid layout with proper spacing and grouping

+ - Add section header with icon and styling consistent with existing form

+ - Create proper TypeScript props interface for the component

+ - _Requirements: 1.2, 3.1, 3.2, 3.3_

+

+- [ ] 3. Implement individual attribute controls

+ - Create race dropdown with Select component (Asian, White, Black, Hispanic)

+ - Create gender dropdown with Select component (Boy, Girl)

+ - Create body type dropdown with Select component (Slim, Average, Chubby)

+ - Create hair length dropdown with Select component (Short, Normal, Long)

+ - Create hair color dropdown with Select component (Black, Blonde, Red, Brown, Gold, White)

+ - _Requirements: 1.2, 3.4_

+

+- [ ] 4. Implement clothing attribute controls

+ - Create shirt color dropdown with Select component (Red, Blue, Yellow, Pink, Black, White)

+ - Create shorts color dropdown with Select component (Red, Blue, Yellow, Pink, Black, White)

+ - Create shoes color dropdown with Select component (Red, Blue, Yellow, Pink, Black, White)

+ - Apply consistent styling and spacing to all clothing dropdowns

+ - _Requirements: 1.2, 3.4_

+

+- [ ] 5. Implement age input with validation

+ - Create number input field for age with proper styling

+ - Add input validation to enforce 1-100 range

+ - Implement error display for invalid age values

+ - Add auto-reset to default value (8) when invalid input is detected

+ - Create proper error styling consistent with existing form theme

+ - _Requirements: 1.2, 4.1, 4.2, 4.3_

+

+- [ ] 6. Create others text field

+ - Implement textarea for additional physical attributes

+ - Apply consistent styling with existing form textareas

+ - Add proper placeholder text and labeling

+ - _Requirements: 1.2, 3.4_

+

+- [ ] 7. Integrate PhysicalAttributesSection into character form modal

+ - Replace existing physical description textarea with new PhysicalAttributesSection

+ - Add state management for all physical attributes in main component

+ - Implement proper state initialization with default values

+ - Wire up all attribute change handlers

+ - _Requirements: 1.1, 2.1, 3.3_

+

+- [ ] 8. Implement attribute parsing for existing characters

+ - Add logic to parse existing physicalDescription into structured attributes

+ - Handle cases where parsing fails by preserving original text in others field

+ - Ensure proper fallback to default values when attributes cannot be determined

+ - Test parsing with various description formats

+ - _Requirements: 2.1, 2.2_

+

+- [ ] 9. Implement string generation on form submission

+ - Modify form submission handler to generate description string from attributes

+ - Combine all selected attributes into coherent descriptive text

+ - Ensure generated string maintains proper grammar and readability

+ - Preserve any additional text from others field in final description

+ - _Requirements: 1.3, 1.4_

+

+- [ ] 10. Add responsive styling and theme consistency

+ - Implement responsive grid layout that works on mobile and desktop

+ - Apply dark theme styling consistent with existing modal

+ - Add proper spacing, borders, and visual grouping

+ - Ensure all controls match existing form component styling

+ - Test layout on different screen sizes

+ - _Requirements: 3.1, 3.2, 3.3, 3.4_

+

+- [ ] 11. Write unit tests for utility functions

+ - Create tests for string generation function with various attribute combinations

+ - Write tests for parsing function with different description formats

+ - Add tests for age validation logic

+ - Test default value application and edge cases

+ - _Requirements: 1.2, 1.3, 4.1_

+

+- [ ] 12. Test complete form integration

+ - Test character creation flow with new physical attributes section

+ - Test character editing flow with existing characters

+ - Verify form submission works correctly with generated description strings

+ - Test error handling and validation feedback

+ - Ensure backward compatibility with existing character data

+ - _Requirements: 1.1, 1.4, 2.1, 2.2, 4.2_

+```

+

+

+

+一旦你对计划满意,点击"最终确定任务列表"按钮来最终确定规范表。

+

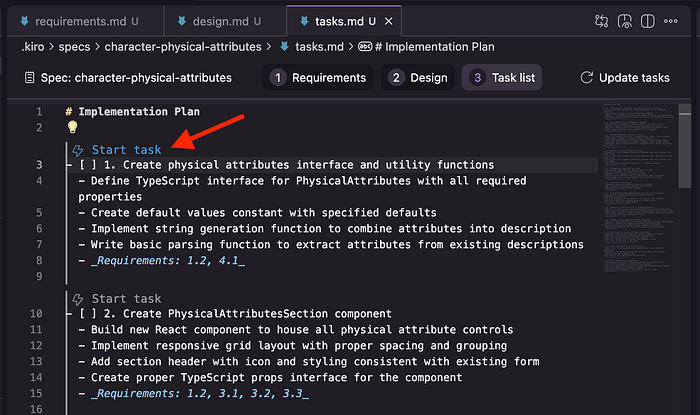

+对于下一步,我们现在可以通过打开 `tasks.md` 文件并点击任何任务项目旁边的"开始任务"来开始实施每个任务。

+

+

+

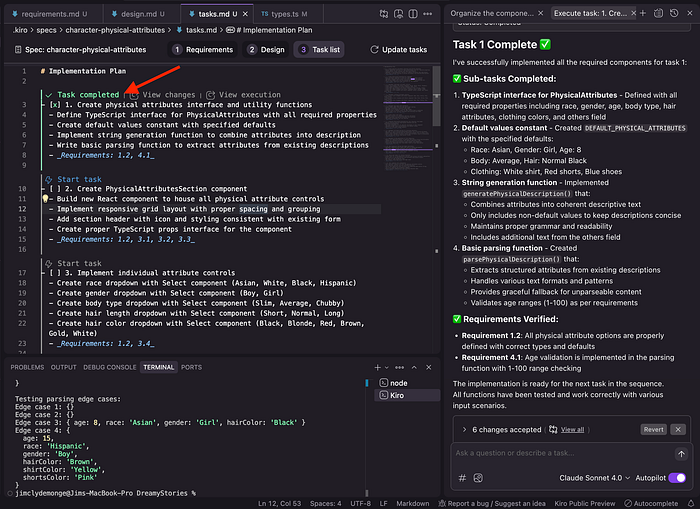

+完成后,任务项目将被标记为已完成。你可以通过点击"查看更改"按钮来检查代码差异。所有执行日志也将显示在聊天面板上。

+

+

+

+继续执行其余任务。一旦所有任务项目都标记为已完成,检查 Web 应用程序以查看更改是否按预期工作。

+

+

+

+UI 与我提示中描述的所有内容匹配,当我点击生成角色按钮时,数据会存储在数据库中。

+

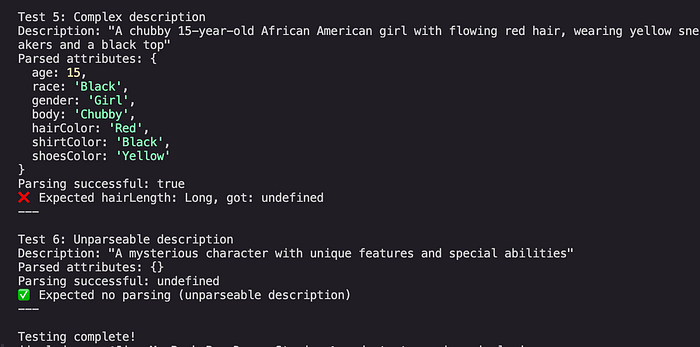

+计划的一部分是测试阶段。Kiro 运行了示例输入,解析它们,并检查准确性。

+

+

+

+```yaml

+Test 5: Complex description

+Description: "A chubby 15-year-old African American girl with flowing red hair, wearing yellow sneakers and a black top"

+Parsed attributes: {

+ age: 15,

+ race: 'Black',

+ gender: 'Girl',

+ body: 'Chubby',

+ hairColor: 'Red',

+ shirtColor: 'Black',

+ shoesColor: 'Yellow'

+}

+Parsing successful: true

+❌ Expected hairLength: Long, got: undefined

+---

+

+Test 6: Unparseable description

+Description: "A mysterious character with unique features and special abilities"

+Parsed attributes: {}

+Parsing successful: undefined

+✅ Expected no parsing (unparseable description)

+---

+```

+

+每次在测试中遇到错误时,Kiro 都会执行修复。

+

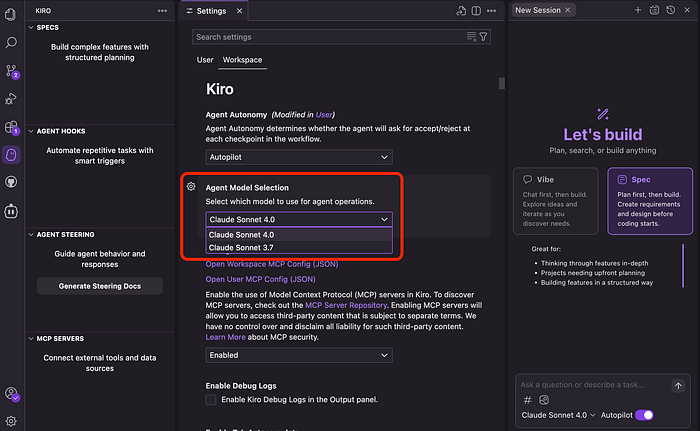

+## 4 Kiro 由 Claude 驱动

+

+Kiro 由 Anthropic 的 Claude 模型驱动,目前在测试版中免费。

+

+这是现在尝试它的最好原因之一。Claude 4 Sonnet 很昂贵,大多数平台要么限制其使用,要么将其隐藏在更高级别后面。例如,Cursor 悄悄地引入了使用限制,这使得每月20美元的计划对许多开发者来说无法使用。

+

+其他 vibe coding 工具如 Windsurf 或 Cline 也不提供对 Claude 模型的免费访问。你要么自带密钥,要么付费使用。

+

+在 Kiro 中,你可以在 Claude Sonnet 4.0 或 3.7 之间选择。只需前往设置 > 工作区并选择你想要的模型。

+

+

+

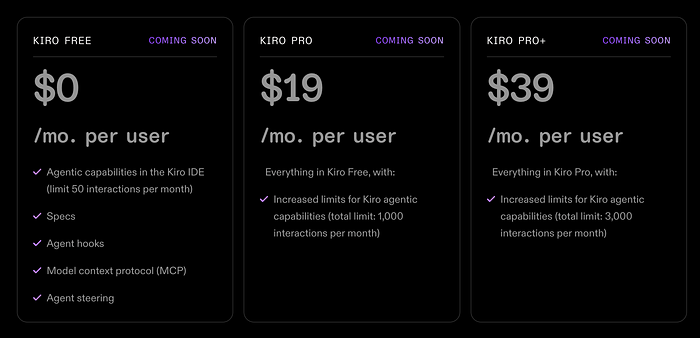

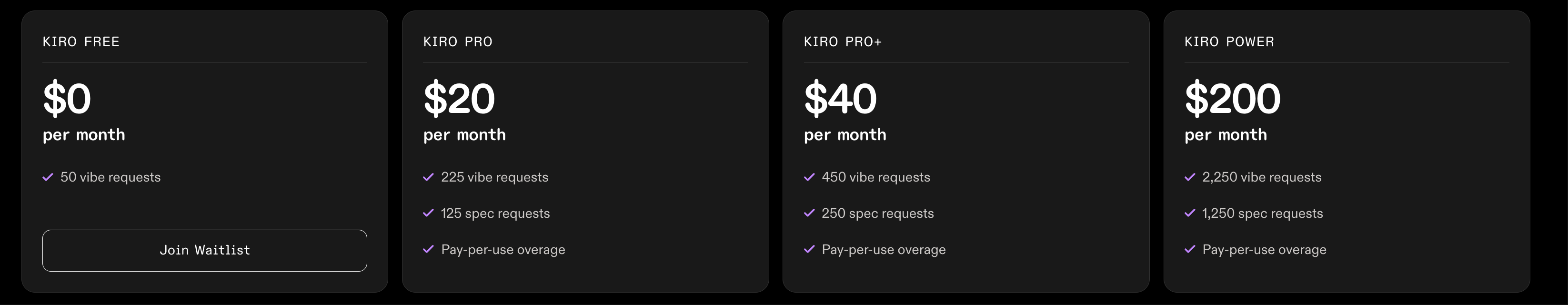

+目前,Kiro 仍处于预览阶段,所以你可以免费尝试它,具有慷慨的使用限制。在[定价页面](https://kiro.dev/pricing/)上查看更多详细信息。

+

+

+

+最新版价格:

+

+

+

+- 免费层让你访问所有核心功能,包括规范、代理钩子、MCP 支持和代理指导——但每月限制在50次 AI 交互。

+- 一旦付费计划推出,将有两个选项:每月19美元的 Kiro Pro,每月交互限制为1,000次,以及每月39美元的 Kiro Pro+,将这一数字提高到3,000次交互。

+

+所有层级都包含相同的核心功能。唯一的区别是你获得多少 AI 使用量。

+

+## 5 最终想法

+

+我印象深刻的是,Kiro 从我的提示中做出的所有代码更改在前端和后端都一次性工作。无需后续提示。

+

+就开发体验而言,在进行实际代码更改之前创建规范会减慢你的速度。

+

+如果你打算进行小修复或小代码更新,你不需要使用规范功能。直接要求 AI 进行代码更改。Claude 4 模型足够聪明,可以弄清楚哪个文件和哪行代码需要更新。

+

+但是如果你正在处理大型功能实施或主要代码重构,这种"编码前计划"方法绝对有用。作为一个已经 vibe coding 一年多的人,有时 AI 会误解请求并最终浪费我宝贵的积分。

+

+我注意到的另一件事是响应速度的不一致。有时 AI 似乎陷入无限循环,因为它没有响应。不过我们需要理解,这是一个初始版本,很多人同时使用它。

+

+无论如何,Kiro 是一个真正好的平台,为 vibe coding 体验提供了新的视角。我很好奇其他开发者对规范和钩子功能的看法。对我来说,这是避免与 AI 误解的好方法,同时也有更清洁和更有组织的代码库。

\ No newline at end of file

diff --git a/docs/md/AI/agent/perplexity-labs.md b/docs/md/AI/agent/perplexity-labs.md

new file mode 100644

index 0000000000..efa5243373

--- /dev/null

+++ b/docs/md/AI/agent/perplexity-labs.md

@@ -0,0 +1,37 @@

+# 不止于搜索!Perplexity Labs深度解析:以项目为核心的 AI 工作流!

+

+## 0 前言

+

+Perplexity推出全新功能 [Labs](https://www.perplexity.ai/pl/hub/blog/introducing-perplexity-labs),专为 Pro 订阅用户设计,旨在支持更复杂的任务,功能超越了传统的问答服务。这一重大更新标志着 Perplexity 从以搜索为核心的交互模式,转向由生成式 AI 驱动的结构化、多步骤工作流。

+

+## 1 交互模式

+

+Perplexity Labs 让用户可在一个统一界面完成多种任务,包括生成报告、分析数据、编写和执行代码、构建轻量级网页应用等。用户可以通网页和移动端的新模式切换器进入 Labs,桌面端支持也即将上线。

+

+## 2 适用场景

+

+与专注于简洁回答的 Perplexity Search 和提供深入信息整合的 Research(原名 Deep Research)不同,Labs 更适合需要完整成果输出的用户。这些成果可能包括格式化的电子表格、可视化图表、交互式仪表盘和基础网页工具等。

+

+每个 Lab 项目都包含一个“Assets”标签页,用户可在此查看或下载所有生成的素材,如图表、图片、CSV 文件和代码文件。有些 Labs 还支持“App”标签页,可以直接在项目环境中渲染基本网页应用。

+

+## 3 使用反馈

+

+Perplexity 的 CEO 和联合创始人 Aravind Srinivas 表示:

+

+> 推出 Perplexity Labs,是我们在 Perplexity 上进行搜索的一种全新方式,支持更复杂的任务,如构建交易策略、仪表盘、用于房地产研究的无头浏览任务、迷你网页应用、故事板,以及生成素材的目录等。

+

+实际使用看,Labs 实现了多个软件工具功能的整合与自动化,大大减少了手动操作,尤其适用于结构化研究、数据处理或原型开发等场景。

+

+用户反馈也显示出平台在速度和语境理解方面的优势。Sundararajan Anandan 就曾[分享](https://www.linkedin.com/feed/update/urn:li:ugcPost:7333908730314399752?commentUrn=urn%3Ali%3Acomment%3A(ugcPost%3A7333908730314399752%2C7334912579871326209)&dashCommentUrn=urn%3Ali%3Afsd_comment%3A(7334912579871326209%2Curn%3Ali%3AugcPost%3A7333908730314399752)):

+

+> 我最近尝试了 Perplexity Labs,它真的改变了游戏规则。以前需要花几个小时才能完成的手动研究和格式整理,现在在 10 分钟内就能输出清晰、可执行的见解。虽然目前还处于早期阶段,平台也有待进一步完善,但初次体验已经相当令人惊艳。

+

+不过,一些早期用户也指出了可改进的地方,特别是在初次生成后进行跟进操作或修改代码方面功能有限。正如一位 Reddit 用户[评论](https://www.reddit.com/r/perplexity_ai/comments/1kza7vo/comment/mv6koy5/?utm_source=share&utm_medium=web3x&utm_name=web3xcss&utm_term=1&utm_content=share_button)所说:

+

+> Labs 最大的问题在于它对后续操作的支持不够,基本要求用户一击命中,非常考验技巧。

+

+## 4 总结

+

+Perplexity 还宣布将统一产品术语,将“Deep Research”简化为“Research”,以便更清晰地区分三种模式:Search、Research 和 Labs。

+

+目前,Perplexity Labs 已正式上线,向所有 Pro 用户开放。平台还提供了 [Projects Gallery](https://www.perplexity.ai/labs),展示了各种示例和使用案例,帮助用户快速上手完成实际任务。

\ No newline at end of file

diff --git a/docs/md/AI/agent/qoder.md b/docs/md/AI/agent/qoder.md

new file mode 100644

index 0000000000..efa90ba9d7

--- /dev/null

+++ b/docs/md/AI/agent/qoder.md

@@ -0,0 +1,201 @@

+# Qoder,让你从“执行者”到“架构师”!

+

+## 1 AI 编程的发展趋势

+

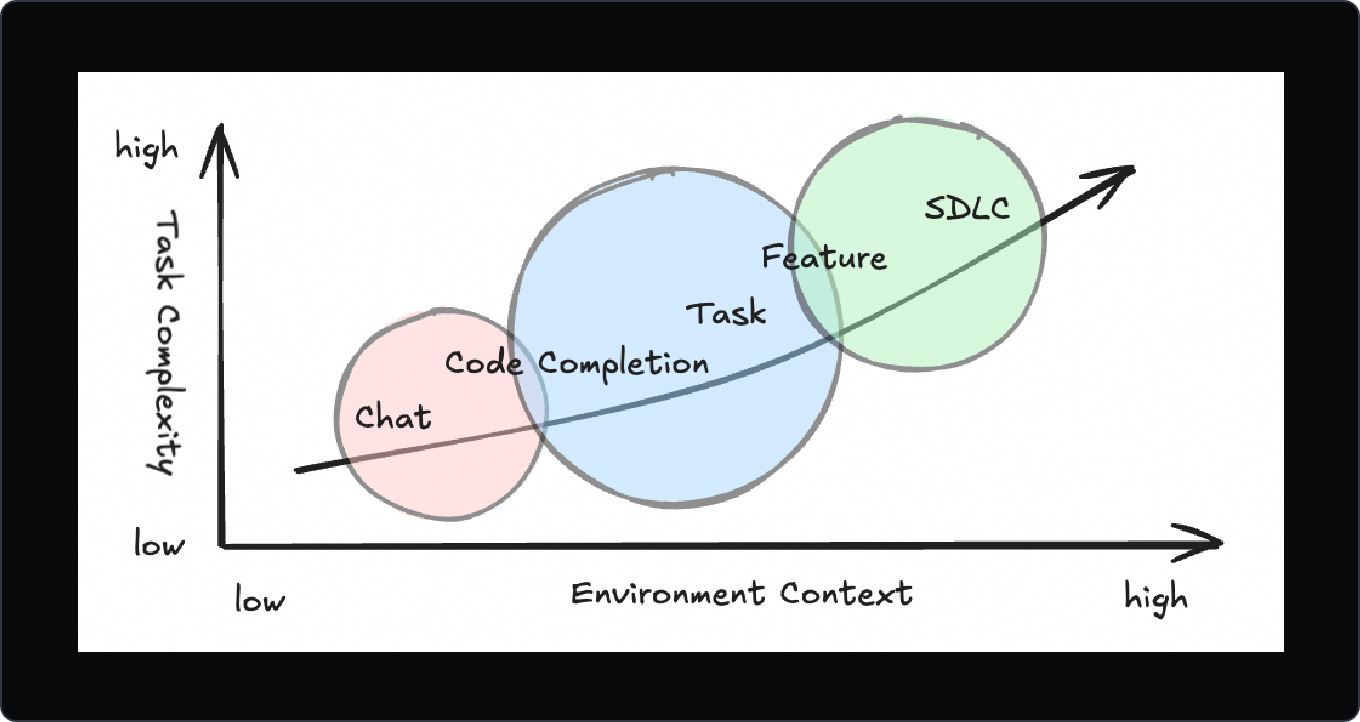

+随LLM进步,AI辅助编程正快速演变。应用范围已从最初简单代码提示,扩展到端到端功能实现,AI自主性也越来越高。

+

+AI编程能力正经历三个关键阶段:

+

+1. 辅助写代码:基础的自动补全与代码片段生成

+2. 对话式重构:通过对话实现交互式修改与重构

+3. 自主编程:将完整的开发任务交给 AI Agen

+

+这种演变使 AI 的角色从工具转为合作伙伴,能承担复杂且长期的软件工程任务。

+

+

+

+## 2 现实软件开发的挑战

+

+虽社交媒体常见“一条指令生成惊艳项目”案例,但现实软件开发依旧复杂。Fred Brooks 在《人月神话》指出,软件开发本质困难,原因在于:

+

+- 复杂性

+- 一致性要求

+- 可变性

+- 不可见性

+

+这些挑战在 AI 时代不仅没消失,反而在某些方面放大:

+

+- 软件抽象性让知识传递和继承变得困难,易产生技术债和协作摩擦

+- AI虽能自动化重复性工作,但若开发者忽视设计与需求澄清,就会导致 AI 生成的代码难维护

+- 目前人机协作大多是同步的,需不断来回沟通,限制 AI 效率,也让它无法充分发挥

+

+## 3 思路

+

+阿里一直在探索如何打造一款工具,让 AI 充分发挥潜力,同时解决软件开发中的核心难题。

+

+### 3.1 透明化

+

+#### ① 知识可见性

+

+首要目标是 **让不可见的东西变得可见**。AI 应该像一位熟悉代码库的专家,助开发者理解项目架构、设计决策和技术债。

+

+这种可见性能:

+

+- 缩短上手时间

+- 提升知识传递效率

+- 让 AI 生成的代码更好地 **贴合** 项目的整体结构

+

+

+

+#### ② 执行透明度

+

+如果 AI 在后台默默运行,开发者容易感到失去掌控感。为此设计了:

+

+- To-dos待办清单:明确的任务拆分

+- Action Flow行动流程:实时的执行跟踪

+

+开发者可随时看到 AI 的计划、进度和决策,让过程透明且值得信赖。

+

+

+

+在 AI 编程中,可见性不是可选项,而是高效协作的必要条件。

+

+### 3.2 增强的上下文工程

+

+**更好的上下文带来更好的代码**。核心在于增强型上下文工程,包括:

+

+- 深度理解代码库:AI 不只“读代码”,而是理解其结构、依赖和设计理念

+- 记忆能力:保存项目历史、用户操作和人机交互,支持长期上下文保持

+

+通过丰富输入上下文,Qoder 不仅生成更精准代码建议,还能为架构决策提供洞察,实现从“代码补全”到“智能协作开发”的跃升。

+

+

+

+增强型上下文工程不仅是一项技术特性,更是一种新的开发理念。

+

+### 3.3 基于 Spec 的任务委托

+

+AI Agent时代开发者核心角色 **从“执行者”转变为“意图澄清者”**。

+

+#### ① 聊天模式(Chat Mode):与Agent协作

+

+- 通过对话引导 AI

+- 审阅、修改并确认每一次改动

+- 适合短小、迭代型任务

+

+#### ② 任务模式(Quest Mode):自主委托

+

+- 你先写一份详细的规格说明(Spec)

+- 你再将任务交给 AI

+- AI 异步执行,仅遇到障碍才请求帮助

+- 适合长期、定义清晰的任务

+

+

+

+Spec不只是任务说明,它还是一种思考工具和沟通媒介:帮助统一人机目标,指引项目方向,并成为团队知识库的一部分。

+

+任务模式正是为这种新范式而生:写 Spec → 委托任务 → 检查结果。

+

+

+

+#### ③ 协作方式

+

+| **Chat Agent Mode** | **Quest Mode** |

+| ------------------- | ------------------- |

+| 聊天迭代 | 先写 Spec |

+| 通过对话完成编码 | 委托任务给 AI Agent |

+| 适合短任务 | 适合长任务 |

+| 监督工作过程 | 精确描述目标 |

+

+未来的开发流程或许是这样的:

+

+1. 上午:和业务方澄清需求

+2. 下午:用 AI 辅助起草详细的 Spec

+3. 晚上:通过任务模式委托工作

+4. 第二天:审查结果,优化并继续迭代

+

+写 Spec → 检查 & 重构 —— 软件开发的新工作流。

+

+### 3.4 提供最合适的模型

+

+随着可用模型越来越多,我们提出一个问题:“选择正确的模型应该由用户来做吗?” **不应该**。

+

+开发者需要的是解决方案,而不是去研究模型对比。他们无需去看评测指标来挑选模型。

+

+Qoder 会根据任务复杂度和上下文,自动匹配最合适的模型,确保性能最优,同时减少用户负担。

+

+**你专注于想要实现什么,我们负责怎么实现。**

+

+## 4 用 Qoder 完成工作

+

+### 4.0 安装

+

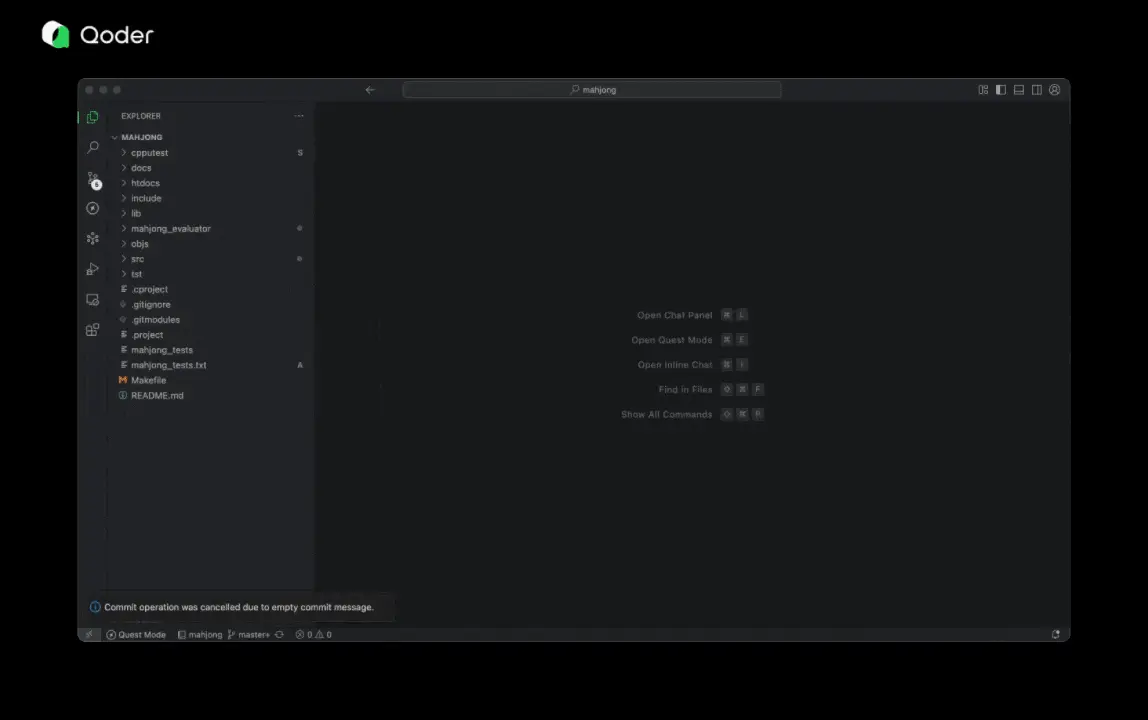

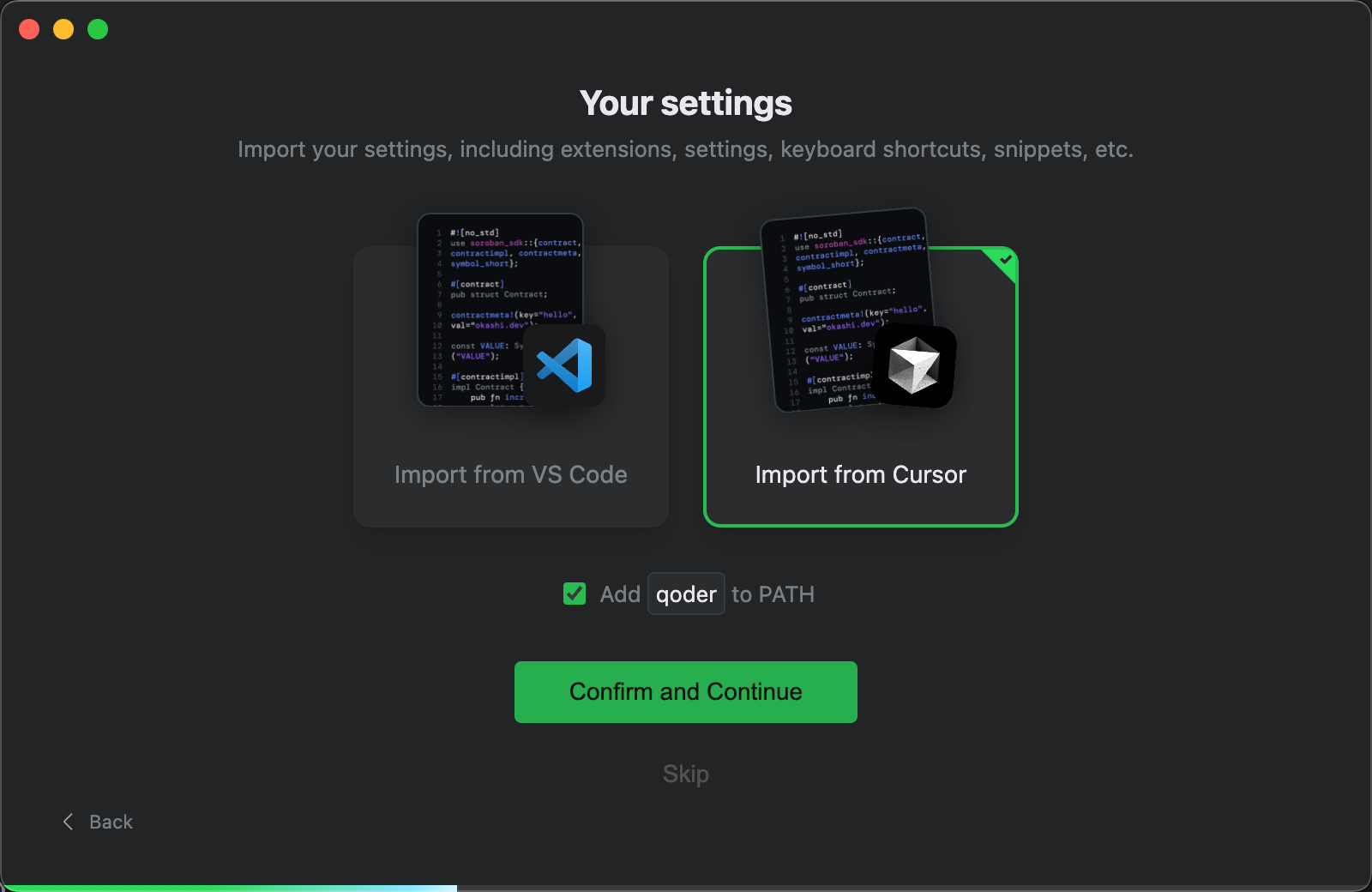

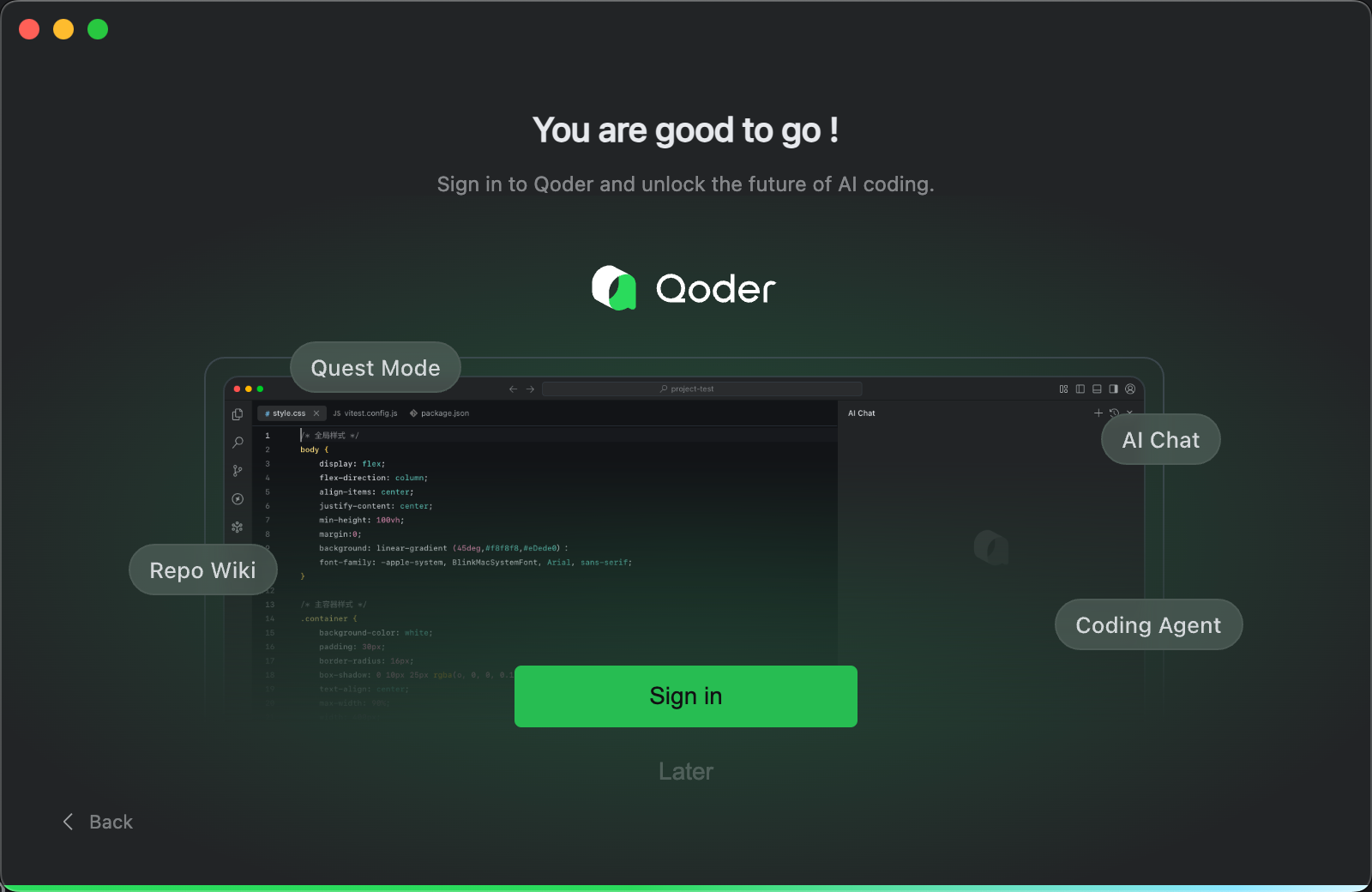

+欢迎页:

+

+

+

+导入cursor的配置页:

+

+

+

+语言和主题:

+

+

+

+面板介绍:

+

+

+

+登录你伟大的账号吧!gmail 即可,无需join waitlist!

+

+

+

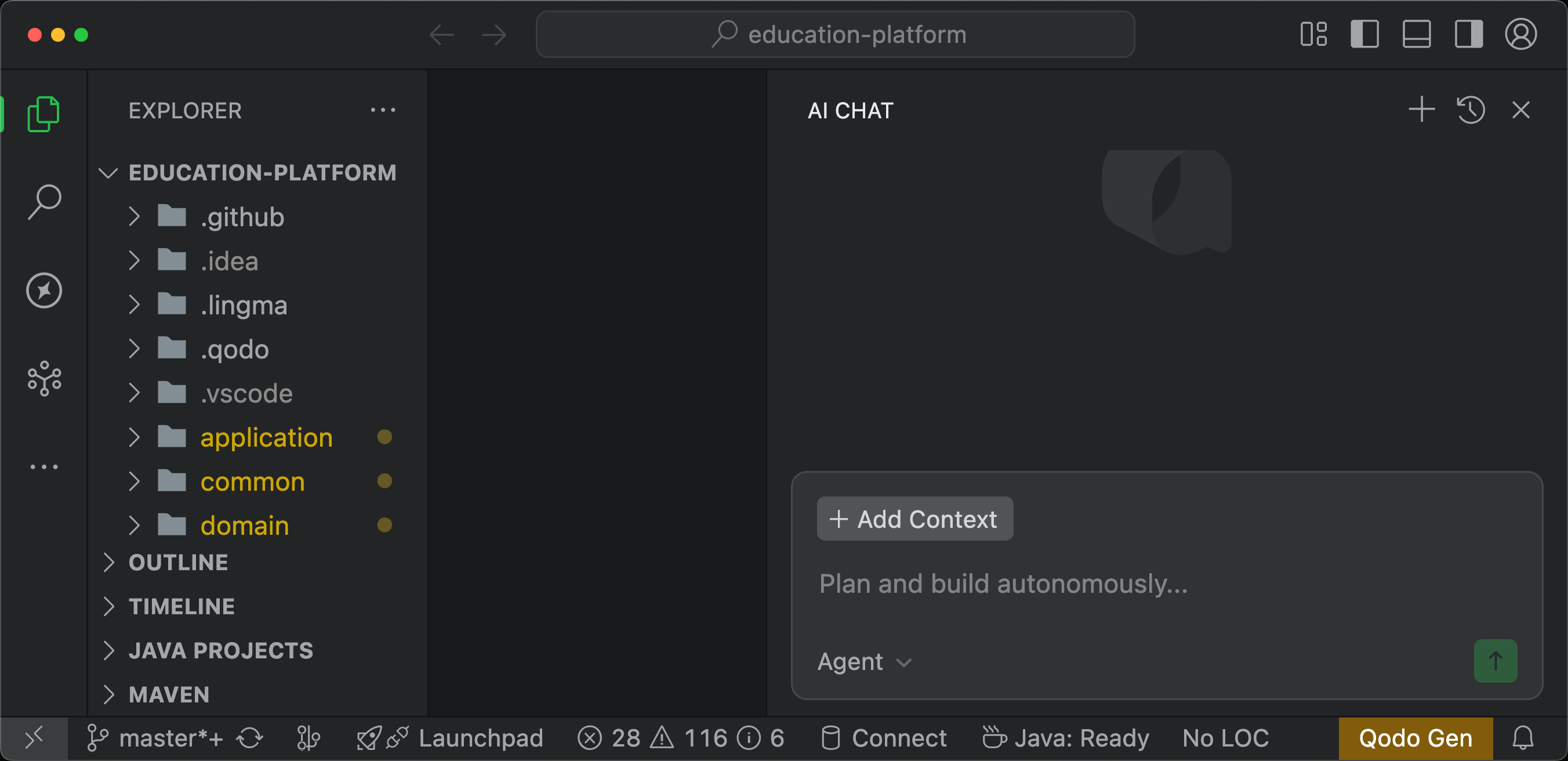

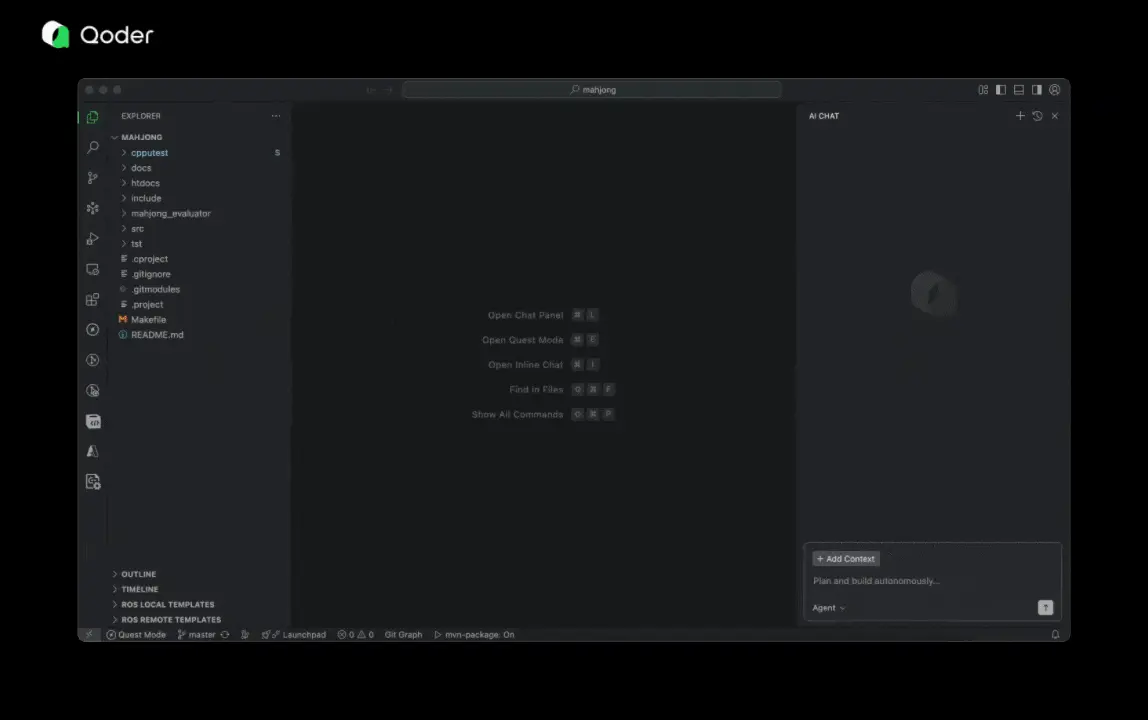

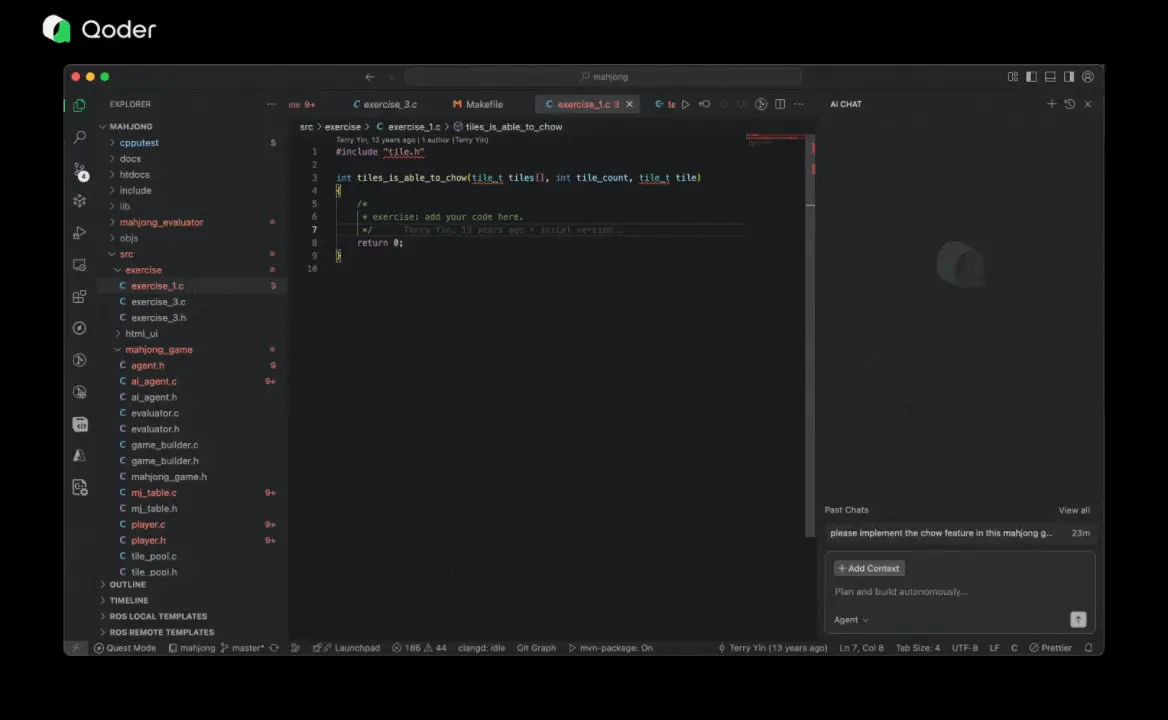

+实际页面:

+

+

+

+### 4.1 开始一个新项目

+

+Qoder上手零门槛,你只需要用自然语言描述想法。如:

+

+- “创建一个 Spring Boot 应用,实现照片上传、预览和下载功能。”

+

+Qoder 会自动生成项目框架和核心业务逻辑。

+

+或者,你也可先用任务模式生成 Spec,描述技术栈、架构和初始版本。一个好的初始版本就是能直接运行的项目。

+

+### 4.2 在现有项目中增加功能

+

+大部分开发都是在已有代码库上进行。在写代码前,开发者需要先了解:

+

+- 项目的功能

+- 技术架构

+

+Repo Wiki 可以即时提供这些信息。Qoder 会在后台建立代码库索引并导入记忆,当你开始一个任务时,相关上下文已经准备好,无需手动选择。

+

+这样,从第一行代码起就能获得精准、上下文相关的辅助。

+

+

+

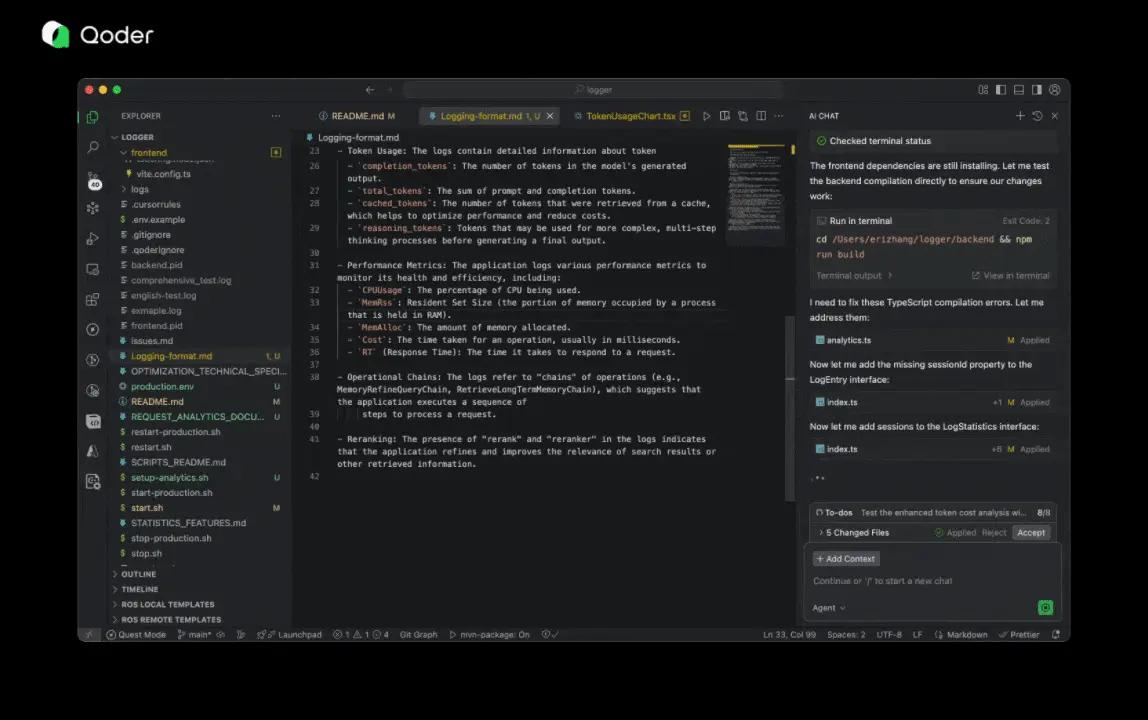

+## 5 熟悉的代码编辑 + AI 协助

+

+日常开发中,Qoder 提供支持:

+

+- 代码补全

+- 下一步编辑建议(NES):预测多行的后续修改

+- 内联编辑:直接在对话中修改代码

+

+这些功能能无缝融入现有工作习惯,提升效率而不打断开发节奏。

+

+

+

+## 6 最后的思考

+

+我们的愿景是解决软件开发中的核心难题:

+

+- 让不可见的部分可视化

+- 加强人机之间的知识对齐

+- 消除技术债务和协作摩擦

+- 让开发者摆脱重复劳动,专注于创新

+

+Qoder 现已开放公测,完全免费。

\ No newline at end of file

diff --git a/docs/md/AI/agent/roocode.md b/docs/md/AI/agent/roocode.md

new file mode 100644

index 0000000000..1f6495ff99

--- /dev/null

+++ b/docs/md/AI/agent/roocode.md

@@ -0,0 +1,53 @@

+# RooCode实用指南:从coser到人工中继的全能AI代码助手

+

+## 0 前言

+

+原名 RooChat,Codelime/Cline 的一个分支,也是VS Code插件,重点是Agent,可深度对话、分析需求、规划任务,甚至扮演不同技术角色。https://roocode.com/

+

+

+

+## 1 内置cosplay

+

+可让 AI 扮演不同角色,如“架构师”、“测试工程师”等。特别是“架构师”角色,能站在更高维度与你一同分c's析项目结构、梳理需求、设计方案,甚至绘制 Mermaid 流程图或架构图。类似Cursor "Thinking" 模式,但角色专业性和交互深度,RooCode 更丰富。

+

+

+

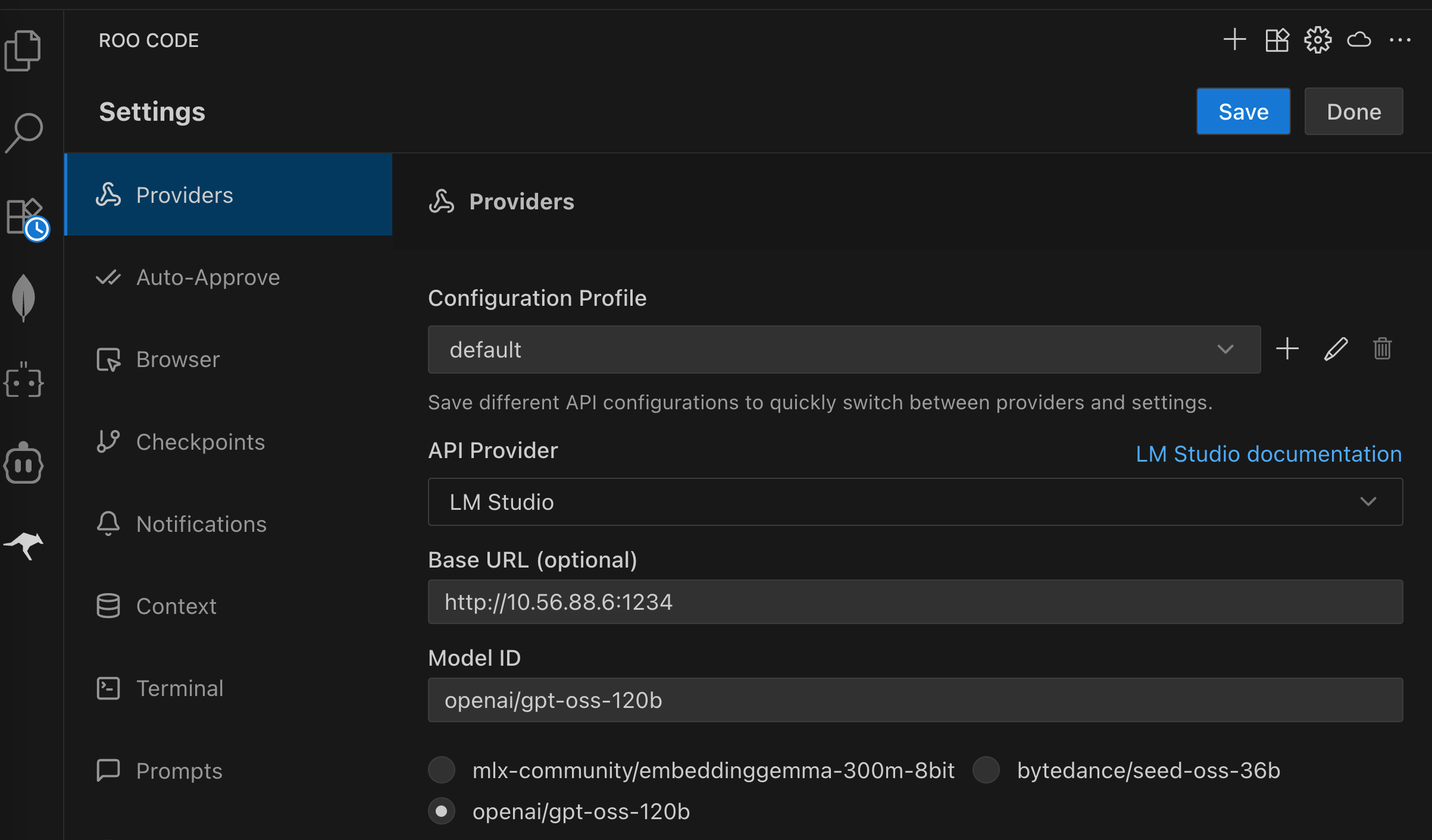

+## 2 灵活的模型配置

+

+需用户自行配置 AI 模型。对于追求性价比的用户,可通过配置 OpenRouter、LM Studio 等模型供应商,选择其中的免费或者本地大模型,如 OpenAI 的 openai/gpt-oss-120b,实现零成本使用:

+

+

+

+若追求顶尖代码能力,如公认的Claude4,也可考虑接入一些国内的第三方模型 API 平台。这些平台通常价格比官方 API 更实惠,但需自行承担服务不稳定、甚至跑路风险,小额尝试,切勿一次性投入过多。

+

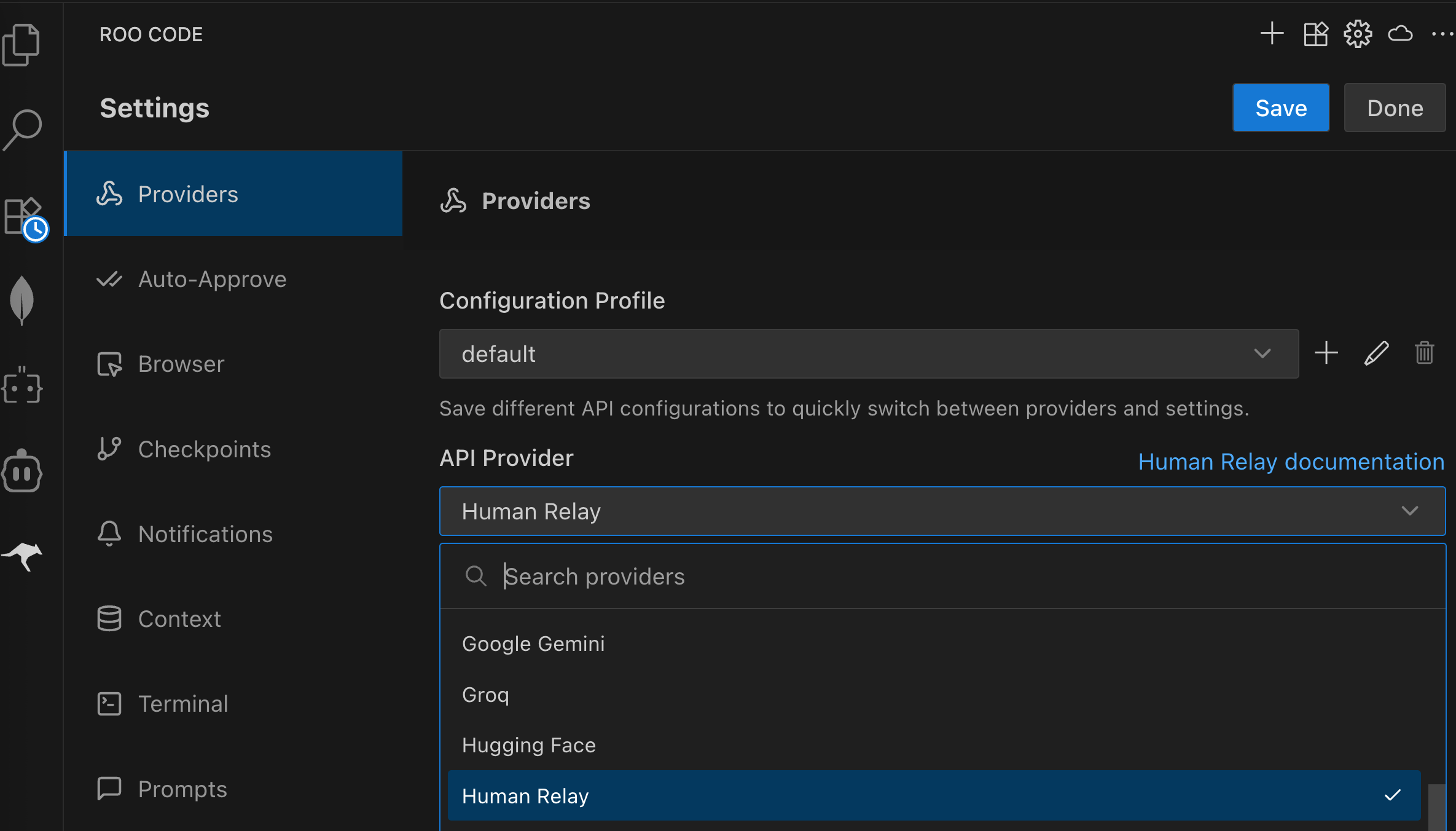

+## 3 Manual Relay

+

+人工中继。

+

+### 使用场景

+

+处理非常庞大的上下文(如整个代码库或超长文档)时,直接调用 API 的 Token 消耗昂贵。启用“人工中继”模式后,RooCode 不直接调用配置好的模型 API,而是将生成的 Prompt (提示词) 或问题展示给你。你要手动将这些内容复制到你拥有高级会员权限的 AI 网页端(如 ChatGPT Plus)进行提问,获得答案后,再将答案粘贴回 RooCode。RooCode 会基于你粘贴回来的内容继续执行下一步的 Agent 任务。

+

+### 优势

+

+极大节省 API Token 费用,尤其适合处理超大上下文;可以充分利用你已有的网页端 AI 会员资格。

+

+### 缺点

+

+需要手动复制粘贴,较为繁琐。

+

+

+

+ 需将问题粘贴到Web端AI:

+

+

+

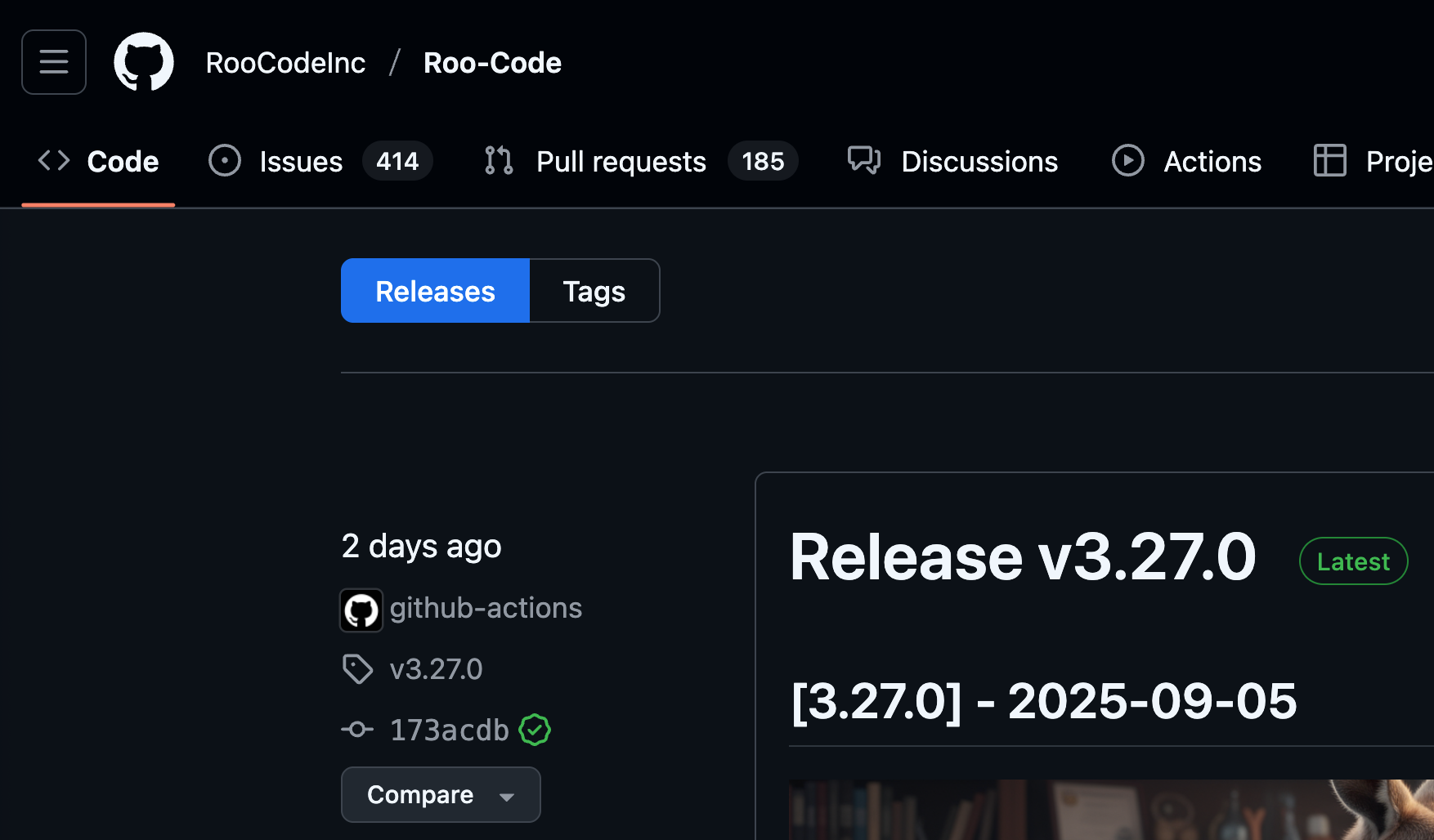

+## 4 社区活跃

+

+RooCode开发者非常活跃,表明开发者在积极听取社区反馈并持续完善插件,更有希望带来更多实用的新功能。

+

+

+

+## 5 总结

+

+RooCode扮演着智能 Agent 的角色,擅长需求分析、任务规划、架构设计,并能通过灵活的模型配置和“人工中继”模式控制成本。

\ No newline at end of file

diff --git a/docs/md/AI/agent/solo.md b/docs/md/AI/agent/solo.md

new file mode 100644

index 0000000000..62aec2827a

--- /dev/null

+++ b/docs/md/AI/agent/solo.md

@@ -0,0 +1,117 @@

+# SOLO is All You Need

+

+能构建完整软件的 AI。

+

+你可能正开着好几个标签页:

+

+- 一个用 ChatGPT 写 PRD(产品需求文档)

+- 一个 AI 研究工具

+- 一个 AI 编码工具执行任务

+- 可能还有一个工具做代码审查和测试……

+

+本该是流畅的开发流程,却变成了在管理一群互不相识的 AI 助手,还得不断重复同样的信息。

+

+AI agent很强,各自解决问题没问题,但整体依旧割裂,离真正的成品发布还有距离。

+

+于是我们换了思路:如何打造一个真正推动软件开发的解决方案?

+

+这就是 **TRAE SOLO** 的由来——不仅会写代码,还能思考、规划、构建并完整交付功能的“上下文工程师”,全程掌握关键信息和工具。

+

+## 1 TRAE SOLO 新特性

+

+### 1.1 SOLO 模式

+

+从需求到部署,全流程自动处理开发工作。你可以在集成视图中实时查看编辑器、浏览器、终端和文档,SOLO 会自动写代码、修 Bug、发布功能,无需人工干预。

+

+### 1.2 @SOLO Builder

+

+内置 Web 开发工具,可将想法直接变成可上线的完整网站。从 PRD、UI 设计、代码生成到部署,一气呵成,适合专业开发者与爱好者。

+

+### 1.3 SOLO 模式与 IDE 模式一键切换

+

+可完全交给 AI 接管,也可以在聊天面板中协作开发。左上角一个开关即可切换。

+

+### 1.4 统一价格

+

+SOLO 已包含在 Pro 计划中,无需额外订阅。

+

+## 2 核心:上下文工程(Context Engineering)

+

+高效的 AI 开发不只是从写代码或写提示词开始。随任务复杂度增加,**完整、精准、结构化的上下文** 比所谓的“神奇提示”更重要。

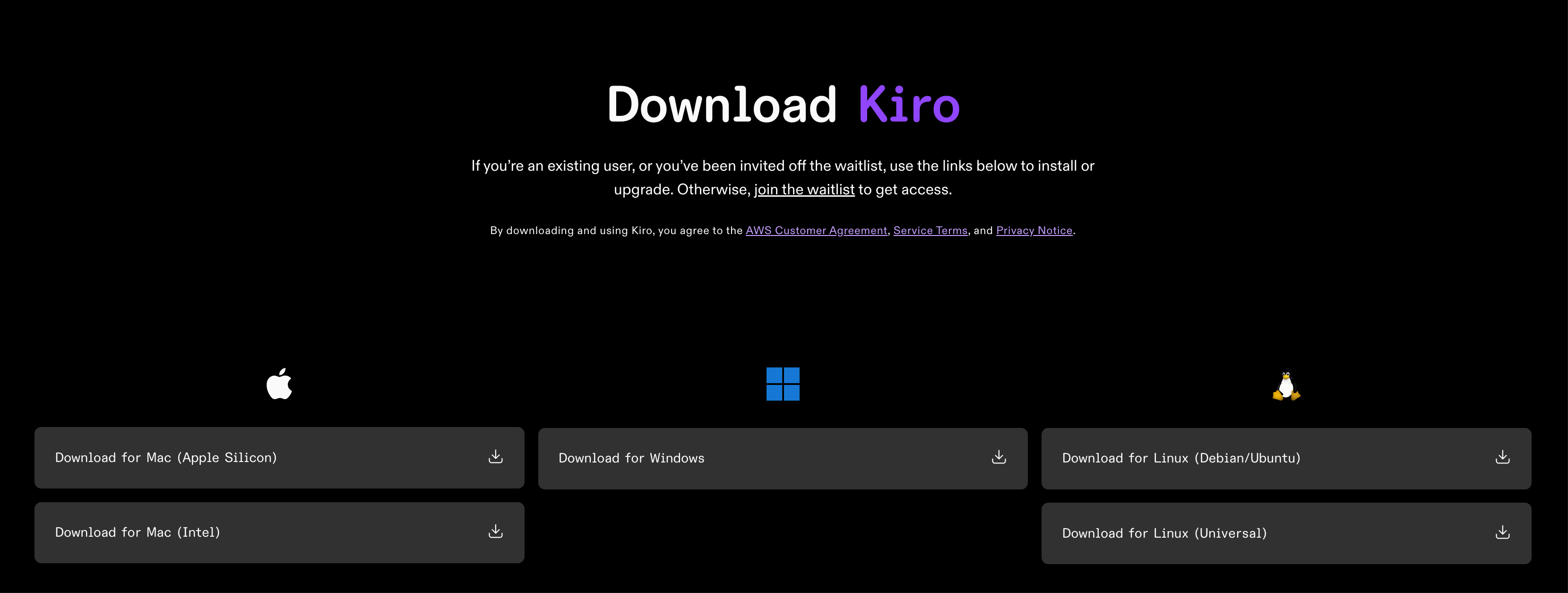

+